AI har et utal af anvendelsesmuligheder, men en af de mest bekymrende er skabelsen af dybt falske medier og misinformation.

En ny undersøgelse fra Google DeepMind og Puslespilen Google-teknologiinkubator, der overvåger samfundsmæssige trusler, analyserede misbrug af AI mellem januar 2023 og marts 2024.

Den vurderede omkring 200 virkelige tilfælde af AI-misbrug og afslørede, at den mest almindelige form for ondsindet AI-brug er at skabe og udbrede vildledende falske medier, især rettet mod politikere og offentlige personer.

Deep fakes, syntetiske medier, der genereres ved hjælp af AI-algoritmer til at skabe meget realistiske, men falske billeder, videoer og lyd, er blevet mere virkelighedstro og udbredte.

Hændelser som da eksplicitte falske billeder af Taylor Swift på X viste, at sådanne billeder kan nå ud til millioner af mennesker, før de slettes.

Men det mest lumske er deep fakes rettet mod politiske emner, såsom Israel-Palæstina-konflikten. I nogle tilfælde kan ikke engang de faktatjekkere, der har til opgave at stemple dem som "AI-genererede", finde ud af, om de er ægte.

DeepMind-undersøgelsen indsamlede data fra en række forskellige kilder, herunder sociale medieplatforme som X og Reddit, onlineblogs og medierapporter.

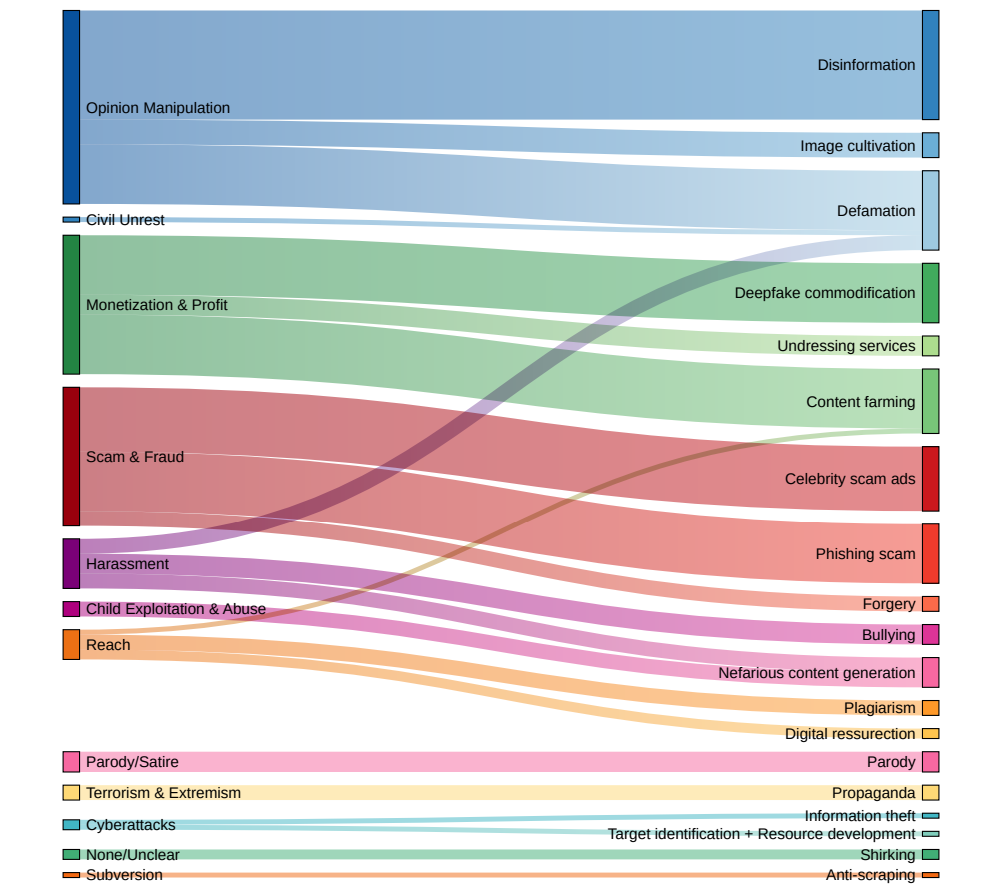

Hver hændelse blev analyseret for at bestemme den specifikke type AI-teknologi, der blev misbrugt, det tilsigtede formål bag misbruget og det niveau af teknisk ekspertise, der kræves for at udføre den ondsindede aktivitet.

Deep fakes er den dominerende form for AI-misbrug

Resultaterne tegner et alarmerende billede af det nuværende landskab af ondsindet brug af AI:

- Deep fakes viste sig at være den dominerende form for AI-misbrug og stod for næsten dobbelt så mange hændelser som den næstmest udbredte kategori.

- Den næsthyppigst observerede form for AI-misbrug var brugen af sprogmodeller og chatbots til at generere og sprede misinformation online. Ved at automatisere skabelsen af vildledende indhold kan dårlige aktører oversvømme sociale medier og andre platforme med falske nyheder og propaganda i et hidtil uset omfang.

- Påvirkning af den offentlige mening og politiske fortællinger var den primære motivation bag over en fjerdedel (27%) af de analyserede tilfælde af AI-misbrug. Dette illustrerer den trussel, som deep fakes og AI-genereret desinformation udgør mod demokratiske processer og integriteten af valg verden over, hvilket vi har observeret fra Nylige højt profilerede hændelser.

- Økonomisk gevinst blev identificeret som den næstmest almindelige drivkraft for ondsindet AI-aktivitet, hvor skruppelløse aktører tilbød betalte tjenester for at skabe dybe forfalskninger, herunder eksplicitte billeder uden samtykke, og udnyttede generativ AI til at masseproducere falsk indhold med profit for øje.

- De fleste tilfælde af AI-misbrug involverede lettilgængelige værktøjer og tjenester, der krævede minimal teknisk ekspertise for at fungere. Denne lave adgangsbarriere udvider i høj grad puljen af potentielle ondsindede aktører, hvilket gør det lettere end nogensinde for enkeltpersoner og grupper at engagere sig i AI-drevet bedrag og manipulation.

Dr. Nahema Marchal fra DeepMind forklarede det udviklende landskab af AI-misbrug til Financial Times: "Der har været en masse forståelig bekymring omkring ret sofistikerede cyberangreb, der blev muliggjort af disse værktøjer", og fortsætter: "Det, vi så, var ret almindeligt misbrug af GenAI [såsom deep fakes, der] måske går lidt mere under radaren."

Politiske beslutningstagere, teknologivirksomheder og forskere skal arbejde sammen om at udvikle omfattende strategier til at opdage og modvirke deepfakes, AI-genereret desinformation og andre former for AI-misbrug.

Men sandheden er, at de allerede har forsøgt - og stort set fejlet. For nylig har vi observeret flere tilfælde af Børn bliver fanget i dybe, falske hændelserog viser, at den samfundsmæssige skade, de påfører, kan være alvorlig.

I øjeblikket kan teknologivirksomheder ikke pålideligt opdage dybe forfalskninger i stor skala, og de vil kun blive mere realistiske og sværere at opdage med tiden.

Og når tekst-til-video-systemer som OpenAI's Sora lander, vil der være en helt ny dimension af dybe forfalskninger at håndtere.