Et hold forskere fra New York University har gjort fremskridt inden for neural taledekodning, hvilket bringer os tættere på en fremtid, hvor personer, der har mistet evnen til at tale, kan få deres stemme tilbage.

Den undersøgelse, udgivet i Naturens maskinelle intelligenspræsenterer en ny ramme for dyb læring, der præcist oversætter hjernesignaler til forståelig tale.

Mennesker med hjerneskader fra slagtilfælde, degenerative tilstande eller fysiske traumer kan bruge disse systemer til at kommunikere ved at afkode deres tanker eller tilsigtede tale fra neurale signaler.

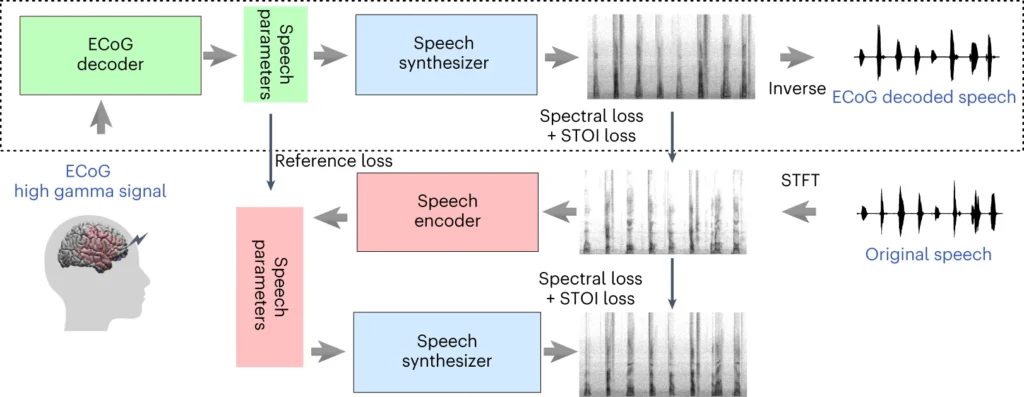

NYU-teamets system involverer en deep learning-model, der kortlægger elektrokortikografi-signalerne (ECoG) fra hjernen til talefunktioner, såsom tonehøjde, lydstyrke og andet spektralt indhold.

Det andet trin involverer en neural talesynthesizer, der omdanner de ekstraherede talefunktioner til et hørbart spektrogram, som derefter kan omdannes til en talebølgeform.

Den bølgeform kan til sidst konverteres til naturligt klingende syntetisk tale.

Ny artikel udgivet i dag i @NatMachIntellhvor vi viser robust neural til tale-afkodning på tværs af 48 patienter. https://t.co/rNPAMr4l68 pic.twitter.com/FG7QKCBVzp

- Adeen Flinker 🇮🇱🇺🇦🎗️ (@adeenflinker) 9. april 2024

Sådan fungerer undersøgelsen

Undersøgelsen går ud på at træne en AI-model, der kan drive en talesynteseenhed, så personer med talebesvær kan tale ved hjælp af elektriske impulser fra deres hjerne.

Her er en mere detaljeret beskrivelse af, hvordan det fungerer:

1. Indsamling af hjernedata

Det første skridt er at indsamle de rådata, der er nødvendige for at træne taleafkodningsmodellen. Forskerne arbejdede med 48 deltagere, som gennemgik en neurokirurgisk operation for epilepsi.

Under undersøgelsen blev disse deltagere bedt om at læse hundredvis af sætninger højt, mens deres hjerneaktivitet blev registreret ved hjælp af ECoG-gitre.

Disse gitre placeres direkte på hjernens overflade og opfanger elektriske signaler fra de hjerneområder, der er involveret i taleproduktion.

2. Kortlægning af hjernesignaler til tale

Ved hjælp af taledata udviklede forskerne en sofistikeret AI-model, der kortlægger de optagne hjernesignaler til specifikke talegenskaber, såsom tonehøjde, lydstyrke og de unikke frekvenser, der udgør forskellige talelyde.

3. Syntetisering af tale ud fra funktioner

Det tredje trin fokuserer på at konvertere de talegenskaber, der er udvundet af hjernesignalerne, tilbage til hørbar tale.

Forskerne brugte en særlig talesynthesizer, der tager de ekstraherede funktioner og genererer et spektrogram - en visuel repræsentation af talelydene.

4. Evaluering af resultaterne

Forskerne sammenlignede den tale, der blev genereret af deres model, med den originale tale, som deltagerne talte.

De brugte objektive parametre til at måle ligheden mellem de to og fandt ud af, at den genererede tale nøje matchede originalens indhold og rytme.

5. Test af nye ord

For at sikre, at modellen kan håndtere nye ord, den ikke har set før, blev visse ord med vilje udeladt under modellens træningsfase, og derefter blev modellens præstation på disse usete ord testet.

Modellens evne til præcist at afkode selv nye ord viser dens potentiale til at generalisere og håndtere forskellige talemønstre.

Den øverste del af ovenstående diagram beskriver en proces til konvertering af hjernesignaler til tale. Først omdanner en dekoder disse signaler til taleparametre over tid. Derefter skaber en synthesizer lydbilleder (spektrogrammer) ud fra disse parametre. Et andet værktøj ændrer disse billeder tilbage til lydbølger.

Det nederste afsnit handler om et system, der hjælper med at træne hjernens signaldekoder ved at efterligne tale. Det tager et lydbillede, omdanner det til taleparametre og bruger dem derefter til at lave et nyt lydbillede. Denne del af systemet lærer af faktiske talelyde for at blive bedre.

Efter træning er det kun den øverste proces, der er nødvendig for at omdanne hjernesignaler til tale.

En vigtig fordel ved NYU's system er dets evne til at opnå taledekodning i høj kvalitet uden behov for elektroder med ultrahøj tæthed, som er upraktiske til langvarig brug.

I bund og grund tilbyder den en mere let og bærbar løsning.

En anden præstation er den vellykkede afkodning af tale fra både venstre og højre hjernehalvdel, hvilket er vigtigt for patienter med hjerneskade i den ene side af hjernen.

Konverterer tanker til tale ved hjælp af AI

NYU-undersøgelsen bygger på tidligere forskning i neural taleafkodning og hjerne-computer-grænseflader (BCI'er).

I 2023 gjorde et team på University of California, San Francisco, det muligt for en lammet slagtilfælde-overlever at generere sætninger med en hastighed på 78 ord i minuttet ved hjælp af en BCI, der syntetiserede både vokaliseringer og ansigtsudtryk fra hjernesignaler.

Andre nyere undersøgelser har udforsket brugen af AI til at fortolke forskellige aspekter af den menneskelige tanke ud fra hjerneaktivitet. Forskere har demonstreret evnen til at generere billeder, tekst og endda musik ud fra MR- og elektroencefalogramdata (EEG) fra hjernen.

For eksempel kan en undersøgelse fra Helsinki Universitet brugte EEG-signaler til at guide et generativt kontradiktorisk netværk (GAN) til at producere ansigtsbilleder, der matchede deltagernes tanker.

Meta AI er også udviklet en teknik til delvis afkodning af, hvad en person lyttede til, ved hjælp af hjernebølger indsamlet ikke-invasivt.

Muligheder og udfordringer

NYU's metode bruger mere bredt tilgængelige og klinisk anvendelige elektroder end tidligere metoder, hvilket gør den mere tilgængelig.

Det er spændende, men der er store forhindringer, der skal overvindes, hvis vi skal se en udbredt anvendelse.

For det første er det en kompleks og tidskrævende opgave at indsamle hjernedata af høj kvalitet. Individuelle forskelle i hjerneaktivitet gør det svært at generalisere, hvilket betyder, at en model, der er trænet til én gruppe deltagere, måske ikke fungerer godt for en anden.

Ikke desto mindre repræsenterer NYU-undersøgelsen et skridt i denne retning ved at demonstrere højpræcisionsafkodning af tale ved hjælp af lettere elektrodearrays.

Fremover vil NYU-teamet arbejde på at forfine deres modeller til afkodning af tale i realtid, så vi kommer tættere på det ultimative mål om at muliggøre naturlige, flydende samtaler for personer med talehandicap.

De har også til hensigt at tilpasse systemet til implanterbare trådløse enheder, der kan bruges i hverdagen.