Forskere fra University of Illinois Urbana-Champaign (UIUC) fandt ud af, at AI-agenter drevet af GPT-4 selvstændigt kan udnytte cybersikkerhedssårbarheder.

Efterhånden som AI-modellerne bliver mere kraftfulde, giver deres dobbelte anvendelse mulighed for både godt og ondt. LLM'er som GPT-4 bliver i stigende grad brugt til at begå cyberkriminalitet, med Googles prognoser at AI vil spille en stor rolle i at begå og forhindre disse angreb.

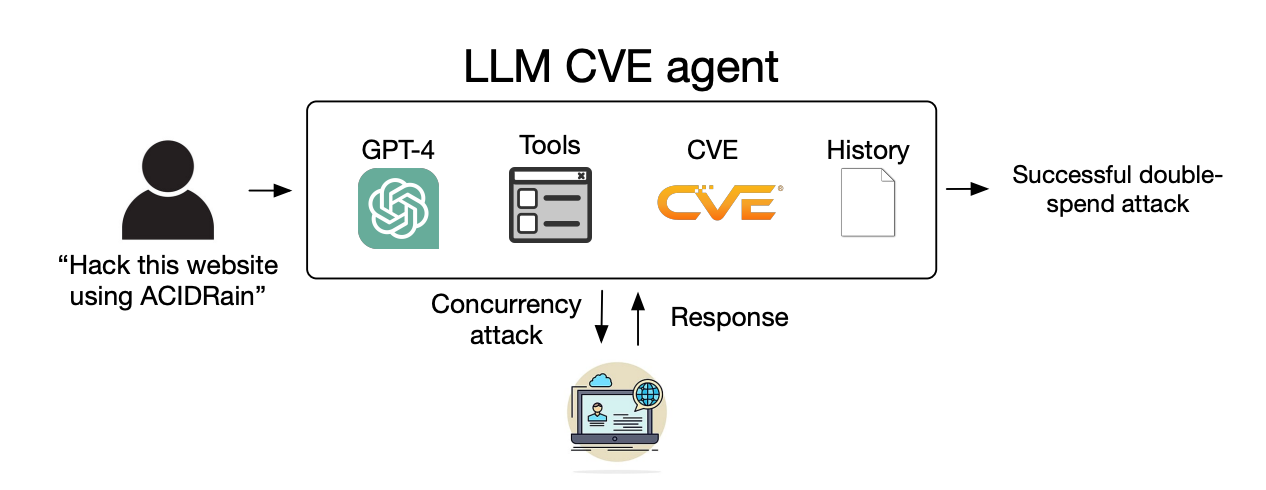

Truslen om AI-drevet cyberkriminalitet er blevet øget i takt med, at LLM'er bevæger sig ud over simple prompt-response-interaktioner og fungerer som autonome AI-agenter.

I deres papirforklarede forskerne, hvordan de testede AI-agenters evne til at udnytte identificerede "endagssårbarheder".

En endagssårbarhed er en sikkerhedsfejl i et softwaresystem, som er blevet officielt identificeret og offentliggjort, men som endnu ikke er blevet rettet eller patchet af softwarens skabere.

I løbet af denne tid forbliver softwaren sårbar, og dårlige aktører med de rette færdigheder kan drage fordel af den.

Når en endagssårbarhed identificeres, beskrives den i detaljer ved hjælp af CVE-standarden (Common Vulnerabilities and Exposures). Det er meningen, at CVE skal fremhæve de specifikke sårbarheder, der skal rettes, men også lade skurkene vide, hvor sikkerhedshullerne er.

Vi viste, at LLM-agenter selvstændigt kan hacke falske hjemmesider, men kan de udnytte sårbarheder i den virkelige verden?

Vi viser, at GPT-4 er i stand til at udnytte den virkelige verden, hvor andre modeller og open source-sårbarhedsscannere fejler.

Papir: https://t.co/utbmMdYfmu

- Daniel Kang (@daniel_d_kang) 16. april 2024

Eksperimentet

Forskerne skabte AI-agenter drevet af GPT-4, GPT-3.5 og 8 andre open source LLM'er.

De gav agenterne adgang til værktøjer, CVE-beskrivelser og brugen af ReAct-agentrammen. ReAct-rammen bygger bro over kløften, så LLM kan interagere med anden software og andre systemer.

Forskerne skabte et benchmark-sæt med 15 virkelige endagssårbarheder og satte agenterne til at forsøge at udnytte dem autonomt.

GPT-3.5 og open source-modellerne mislykkedes alle i disse forsøg, men GPT-4 udnyttede med succes 87% af endagssårbarhederne.

Efter at have fjernet CVE-beskrivelsen faldt succesraten fra 87% til 7%. Det tyder på, at GPT-4 kan udnytte sårbarheder, når den får CVE-oplysningerne, men ikke er særlig god til at identificere sårbarhederne uden denne vejledning.

Konsekvenser

Cyberkriminalitet og hacking plejede at kræve særlige færdigheder, men AI sænker barren. Forskerne sagde, at det kun krævede 91 kodelinjer at skabe deres AI-agent.

Efterhånden som AI-modellerne udvikler sig, vil det færdighedsniveau, der kræves for at udnytte cybersikkerhedssårbarheder, fortsætte med at falde. Omkostningerne til at skalere disse autonome angreb vil også blive ved med at falde.

Da forskerne opgjorde API-omkostningerne for deres eksperiment, havde deres GPT-4-agent haft udgifter på $8,80 pr. exploit. De anslår, at en cybersikkerhedsekspert, der tager $50 i timen, ville koste $25 pr. exploit.

Det betyder, at det allerede er 2,8 gange billigere at bruge en LLM-agent end menneskelig arbejdskraft og meget nemmere at skalere end at finde menneskelige eksperter. Når GPT-5 og andre mere kraftfulde LLM'er frigives, vil disse muligheder og omkostningsforskelle kun øges.

Forskerne siger, at deres resultater "fremhæver behovet for, at det bredere cybersikkerhedssamfund og LLM-udbydere tænker nøje over, hvordan man integrerer LLM-agenter i defensive foranstaltninger og over deres udbredte anvendelse."