Kapløbet om mere kraftfuld og effektiv AI-hardware tog fart i denne uge, hvor Intel og Google annoncerede nye chips, der skal hjælpe dem med at blive mindre afhængige af NVIDIA-teknologi.

Det ser ud til, at der hver uge frigives nye AI-modeller. Bag hver udgivelse ligger ugers træning i cloud computing-datacentre, hvoraf de fleste er drevet af NVIDIA GPU'er.

Intel og Google har begge annonceret nye interne AI-chips, som kan træne og implementere store AI-modeller hurtigere og samtidig bruge mindre strøm.

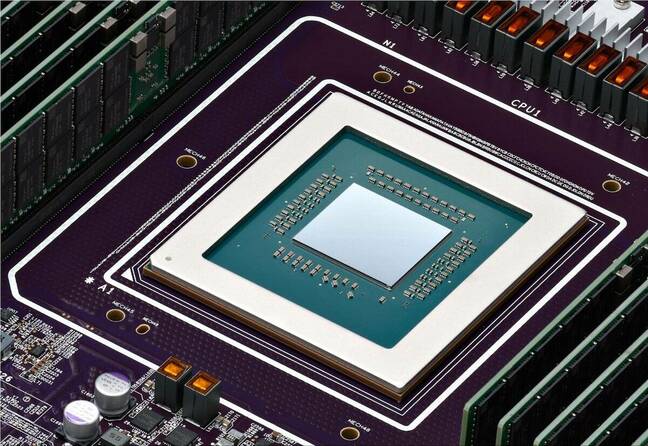

Intels Gaudi 3 AI-acceleratorchip

Intel er nok bedre kendt for de chips, der driver din pc, men tirsdag blev virksomheden annonceret sin nye AI-chip kaldet Gaudi 3.

NVIDIA's H100 GPU'er har udgjort hovedparten af AI-datacentre, men Intel siger, at Gaudi 3 leverer "50% i gennemsnit bedre inferens og 40% i gennemsnit bedre strømeffektivitet end Nvidia H100 - til en brøkdel af prisen."

En stor bidragyder til Gaudi 3's energieffektivitet er, at Intel brugte Taiwan Semiconductor Manufacturing Co's 5nm-proces til at fremstille chipsene.

Intel gav ingen prisoplysninger, men på spørgsmålet om, hvordan den kan sammenlignes med NVIDIA's produkter, sagde Das Kamhout, VP for Xeon-software hos Intel: "Vi forventer, at den vil være meget konkurrencedygtig."

Dell Technologies, Hewlett Packard Enterprise, Lenovo og Supermicro bliver de første til at implementere Gaudi 3 i deres AI-datacentre.

Intels CEO Pat Gelsinger opsummerede virksomhedens AI-ambitioner ved at sige: "Intel bringer AI overalt i virksomheden, fra pc'en til datacentret og ud til kanten."

Den #IntelGaudi 3 #AI accelerator er et yderst konkurrencedygtigt alternativ til NVIDIA's H100 med højere ydelse, øget skalerbarhed og PyTorch-integration. Udforsk flere vigtige produktfordele. https://t.co/sXdQKjYFw0 pic.twitter.com/iJSndBQkvT

- Intel AI (@IntelAI) 9. april 2024

Googles opgraderinger af Arm og TPU

Tirsdag annoncerede Google sin første brugerdefinerede Arm-baserede CPU'er som de planlægger at bruge til at drive deres datacentre. Den nye chip, kaldet Axion, er en direkte konkurrent til Intels og AMD's CPU'er.

Google hævder, at Axion leverer "30% bedre ydeevne end de hurtigste generelle Arm-baserede instanser, der er tilgængelige i skyen i dag, op til 50% bedre ydeevne og op til 60% bedre energieffektivitet end sammenlignelige x86-baserede instanser af den nuværende generation."

Google har flyttet flere af sine tjenester som YouTube og Google Earth til sin nuværende generation af Arm-baserede servere, som snart vil blive opgraderet med Axion-chips.

At have en kraftfuld Arm-baseret mulighed gør det nemmere for kunderne at migrere deres CPU-baserede AI-træning, inferencing og andre applikationer til Googles cloud-platform uden at skulle redesigne dem.

Til modeltræning i stor skala har Google i vid udstrækning brugt sine TPU-chips som et alternativ til NVIDIA's hardware. Disse vil også blive opgraderet med en enkelt ny TPU v5p, som nu indeholder mere end dobbelt så mange chips som den nuværende TPU v4-pod.

TPU v5p, vores mest kraftfulde og skalerbare TPU, er nu generelt tilgængelig! #GoogleCloudNext pic.twitter.com/mmfWlzHeqs

- Google Cloud Tech (@GoogleCloudTech) 9. april 2024

Google ønsker ikke at sælge hverken sine nye Arm-chips eller TPU'er. Virksomheden ønsker at drive sine cloud computing-tjenester i stedet for at blive en direkte hardwarekonkurrent til NVIDIA.

De opgraderede TPU'er vil give et løft til Googles AI-hypercomputer hvilket muliggør træning af AI-modeller i stor skala. AI-hypercomputeren bruger også NVIDIA H100 GPU'er, som ifølge Google snart vil blive udskiftet med NVIDIA's nye Blackwell GPU'er.

Efterspørgslen efter AI-chips vil sandsynligvis ikke aftage lige foreløbig, og det ligner i mindre grad end tidligere et NVIDIA-kapløb med kun én hest.