Google-forskere har udviklet en teknik kaldet Infini-attention, som gør det muligt for LLM'er at håndtere uendeligt lange tekster uden at øge kravene til beregning og hukommelse.

Transformer-arkitekturen i en LLM er det, der gør det muligt at være opmærksom på alle tokens i en prompt. De komplekse prikprodukt- og matrixmultiplikationer, den udfører, er kvadratiske i kompleksitet.

Det betyder, at hvis du fordobler antallet af tokens i din prompt, skal du bruge fire gange så meget hukommelse og processorkraft. Det er derfor, det er så udfordrende at lave LLM'er med store kontekstvinduer uden at kravene til hukommelse og beregning skyder i vejret.

I en "standard" LLM går information i begyndelsen af prompten tabt, når prompten bliver større end kontekstvinduet. Googles forskningsartikel forklarer, hvordan Infini-attention kan opbevare data uden for kontekstvinduet.

Google præsenterer Leave No Context Behind: Effektive uendelige konteksttransformatorer med uendelig opmærksomhed

1B-model, der blev finjusteret på op til 5K sekvenslængde passkey-instanser, løser problemet med 1M længdehttps://t.co/zyHMt3inhi pic.twitter.com/ySYEMET9Ef

- Aran Komatsuzaki (@arankomatsuzaki) 11. april 2024

Hvordan virker Infini-attention?

Infini-attention kombinerer komprimerende hukommelsesteknikker med modificerede opmærksomhedsmekanismer, så relevant ældre information ikke går tabt.

Når input-prompten vokser ud over modellens kontekstlængde, gemmer den komprimerende hukommelse information i et komprimeret format i stedet for at kassere den.

Det gør det muligt at gemme ældre, mindre umiddelbart relevante oplysninger, uden at hukommelses- og beregningskravene vokser i det uendelige, når inputtet vokser.

I stedet for at forsøge at fastholde alle de ældre inputinformationer, vejer og opsummerer Infini-attentions komprimerende hukommelse de informationer, der anses for at være relevante og værd at fastholde.

Infini-attention tager så en "vanilje"-opmærksomhedsmekanisme, men genbruger KV-tilstandene (key value) fra hvert efterfølgende segment i modellen i stedet for at kassere dem.

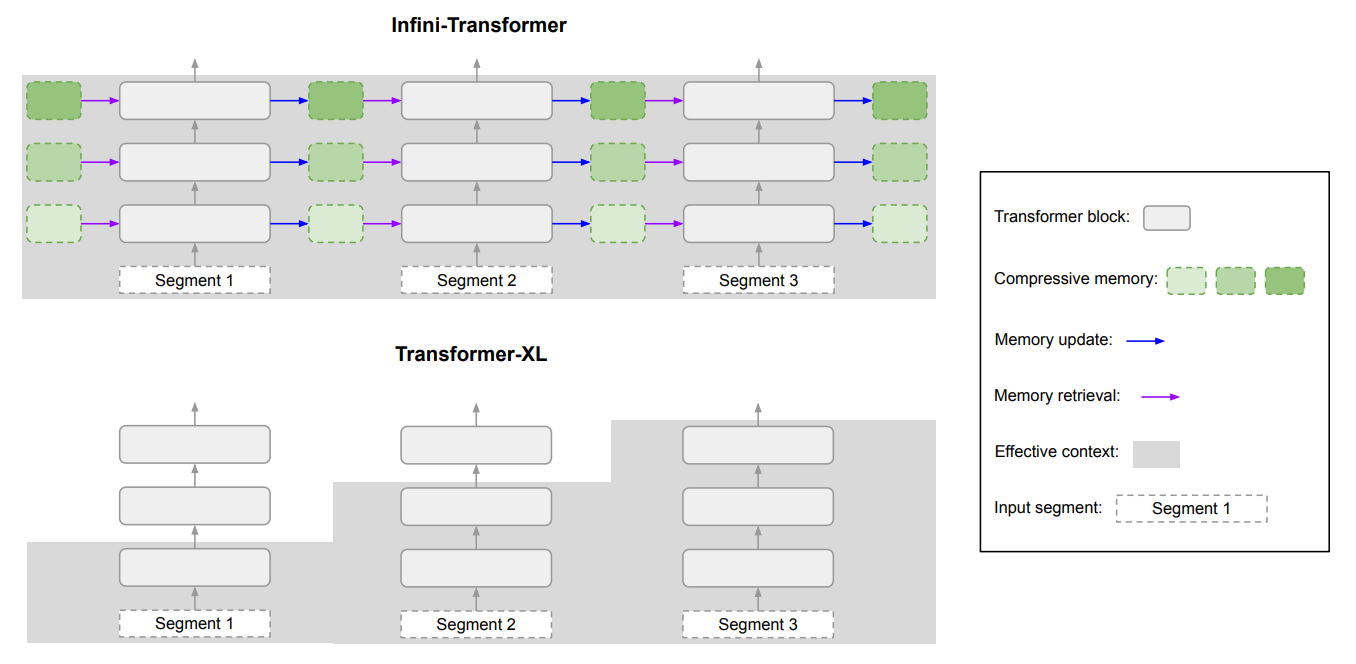

Her er et diagram, der viser forskellen mellem Infini-attention og en anden model med udvidet kontekst, Transformer XL.

Resultatet er en LLM, der giver lokal opmærksomhed til nylige inputdata, men som også har kontinuerligt destillerede, komprimerede historiske data, som den kan bruge til langsigtet opmærksomhed.

Artiklen bemærker, at "Denne subtile, men kritiske ændring af opmærksomhedslaget gør det muligt for LLM'er at behandle uendeligt lange kontekster med begrænsede hukommelses- og beregningsressourcer."

Hvor god er den?

Google kørte benchmarking-tests med mindre 1B- og 8B-parameter Infini-attention-modeller. Disse blev sammenlignet med andre udvidede kontekstmodeller som Transformer-XL og Memorizing Transformers.

Infini-Transformer opnåede betydeligt lavere forvirringsscore end de andre modeller ved behandling af indhold med lang kontekst. En lavere forvirringsscore betyder, at modellen er mere sikker på sine output-forudsigelser.

I "passkey retrieval"-testene fandt Infini-attention-modellerne konsekvent det tilfældige tal, der var skjult i tekst med op til 1 million tokens.

Andre modeller formår ofte at finde adgangskoden mod slutningen af inputtet, men har svært ved at finde den midt i eller i begyndelsen af et langt indhold. Infini-attention havde ingen problemer med denne test.

Benchmarking-testene er meget tekniske, men den korte historie er, at Infini-attention klarede sig bedre end basismodellerne i opsummering og håndtering af lange sekvenser, samtidig med at konteksten blev bevaret over længere perioder.

Det er bemærkelsesværdigt, at den bevarede denne overlegne lagringsevne, mens den krævede 114 gange mindre hukommelse.

Benchmark-resultaterne overbeviser forskerne om, at Infini-attention kan skaleres til at håndtere ekstremt lange input-sekvenser med begrænsede hukommelses- og beregningsressourcer.

Infini-attentions plug-and-play-karakter betyder, at den kan bruges til løbende prætræning og finjustering af eksisterende Transformer-modeller. Dette kan effektivt udvide deres kontekstvinduer uden at kræve fuldstændig omskoling af modellen.

Kontekstvinduer vil blive ved med at vokse, men denne tilgang viser, at en effektiv hukommelse kan være en bedre løsning end et stort bibliotek.