Forskere har offentliggjort en undersøgelse, der sammenligner nøjagtigheden og kvaliteten af de resuméer, som LLM'er producerer. Claude 3 Opus klarede sig særligt godt, men mennesker har stadig en fordel.

AI-modeller er ekstremt nyttige til at opsummere lange dokumenter, når du ikke har tid eller lyst til at læse dem.

Luksusen med voksende kontekstvinduer betyder, at vi kan bede modellerne om længere dokumenter, hvilket udfordrer deres evne til altid at få styr på fakta i resuméet.

Forskerne fra University of Massachusetts Amherst, Adobe, Allen Institute for AI og Princeton University, offentliggjorde en undersøgelse der forsøgte at finde ud af, hvor gode AI-modeller er til at opsummere indhold i boglængde (>100k tokens).

FABLER

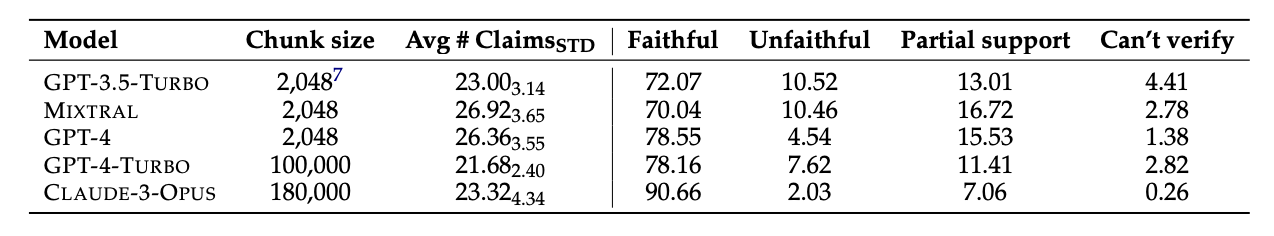

De udvalgte 26 bøger, der blev udgivet i 2023 og 2024, og fik forskellige LLM'er til at opsummere teksterne. De seneste udgivelsesdatoer blev valgt for at undgå potentiel dataforurening i modellernes oprindelige træningsdata.

Når modellerne havde produceret resuméerne, brugte de GPT-4 til at udtrække dekontekstualiserede påstande fra dem. Forskerne hyrede derefter menneskelige kommentatorer, som havde læst bøgerne, og bad dem om at faktatjekke påstandene.

De resulterende data blev samlet i et datasæt kaldet "Faithfulness Annotations for Book-Length Summarization" (FABLES). FABLES indeholder 3.158 annoteringer af trofasthed på påstandsniveau på tværs af 26 fortællende tekster.

Testresultaterne viste, at Claude 3 Opus var "det mest troværdige boglange resumé med en betydelig margin", hvor over 90% af dens påstande blev verificeret som troværdige eller nøjagtige.

GPT-4 kom på en fjern andenplads med kun 78% af sine påstande verificeret som troværdige af de menneskelige kommentatorer.

Den svære del

De modeller, der blev testet, så alle ud til at have problemer med de samme ting. Størstedelen af de fakta, som modellerne tog fejl af, var relateret til begivenheder eller tilstande for karakterer og relationer.

Artiklen bemærkede, at "de fleste af disse påstande kun kan gøres ugyldige ved at ræsonnere over beviserne i flere led, hvilket understreger opgavens kompleksitet og dens forskel fra eksisterende indstillinger for faktaverificering."

LLM'erne udelod også ofte kritisk information i deres resuméer. De lægger også for stor vægt på indhold i slutningen af bøgerne og overser vigtigt indhold i begyndelsen.

Vil AI erstatte menneskelige kommentatorer?

Menneskelige kommentatorer eller faktatjekkere er dyre. Forskerne brugte $5.200 på at få de menneskelige kommentatorer til at verificere påstandene i AI-resuméerne.

Kunne en AI-model have gjort arbejdet billigere? Enkelt genfinding af fakta er noget, Claude 3 er god til, men dens præstation ved verificering af påstande, der kræver en dybere forståelse af indholdet, er mindre konsekvent.

Når de blev præsenteret for de ekstraherede påstande og bedt om at verificere dem, kom alle AI-modellerne til kort over for menneskelige kommentatorer. De klarede sig især dårligt i forhold til at identificere utroværdige påstande.

Selvom Claude 3 Opus var den bedste til at verificere krav med en vis afstand, konkluderede forskerne, at den "i sidste ende fungerer for dårligt til at være en pålidelig automatisk bedømmer".

Når det handler om at forstå nuancer, komplekse menneskelige relationer, plotpunkter og karaktermotivationer i en lang fortælling, ser det ud til, at mennesker stadig har en fordel indtil videre.