Den amerikanske hær forsøger sig med at integrere AI-chatbots i deres strategiske planlægning, om end inden for rammerne af en krigsspilssimulering baseret på det populære videospil Starcraft II.

Denne undersøgelseledet af US Army Research Laboratory, analyserer OpenAI's GPT-4 Turbo- og GPT-4 Vision-strategier på slagmarken.

Dette er en del af OpenAI's samarbejde med forsvarsministeriet (DOD) efter oprettelsen af Generativ AI-arbejdsgruppe sidste år.

AI's brug på slagmarken er heftigt debatteretmed en nylig lignende undersøgelse af AI-krigsspil at LLM'er som GPT-3.5 og GPT-4 har en tendens til at optrappe diplomatiske taktikker, hvilket nogle gange resulterer i atomkrig.

Denne nye forskning fra den amerikanske hær brugte Starcraft II til at simulere et slagmarksscenarie, der involverede et begrænset antal militære enheder.

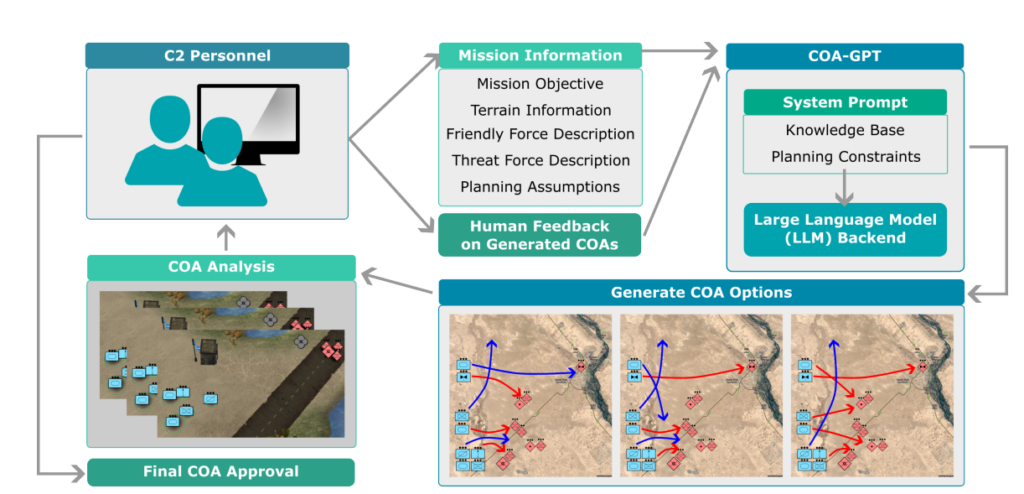

Forskerne kaldte dette system for "COA-GPT" - hvor COA står for det militære udtryk "Courses of Action", som i bund og grund beskriver militærtaktik.

COA-GPT påtog sig rollen som den militære kommandørs assistent og fik til opgave at udtænke strategier til at udslette fjendens styrker og erobre strategiske punkter.

Forskerne bemærker, at traditionel COA er notorisk langsom og arbejdskrævende. COA-GPT træffer beslutninger på få sekunder og integrerer samtidig menneskelig feedback i AI'ens læringsproces.

COA-GPT overgår andre metoder, men der er en omkostning

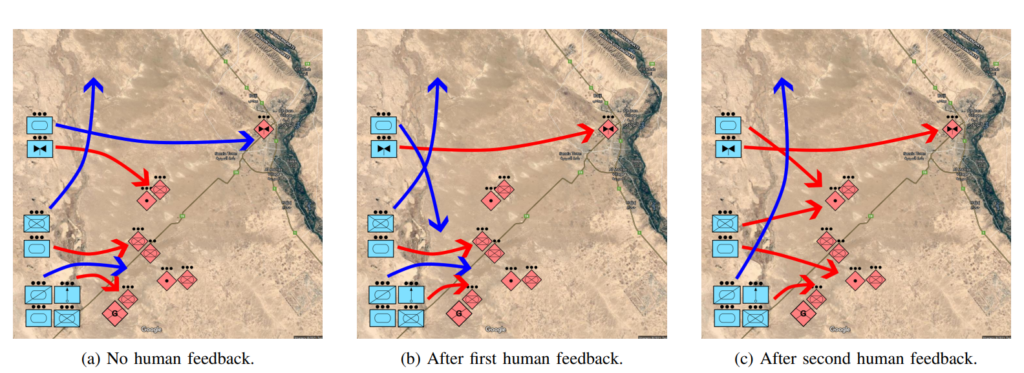

COA-GPT viste sig at være bedre end de eksisterende metoder og overgik dem i at generere strategiske COA'er, og kunne tilpasse sig feedback i realtid.

Der var dog mangler. COA-GPT led især større tab i forbindelse med opfyldelsen af missionens mål.

I undersøgelsen står der: "Vi observerer, at COA-GPT og COA-GPT-V, selv når de forbedres med menneskelig feedback, udviser højere tab af egne styrker sammenlignet med andre baselines."

Afskrækker det forskerne? Tilsyneladende ikke.

Undersøgelsen siger: "Konklusionen er, at COA-GPT repræsenterer en transformativ tilgang til militære C2-operationer, der muliggør hurtigere og mere smidig beslutningstagning og opretholder en strategisk fordel i moderne krigsførelse."

Det er bekymrende, at et AI-system, der forårsagede flere unødvendige dødsfald end udgangspunktet, defineres som en "transformativ tilgang".

Forsvarsministeriet har allerede identificeret andre muligheder for at udforske AI's militære anvendelser, men der er bekymring for teknologiens parathed og etiske konsekvenser.

Hvem er for eksempel ansvarlig, når militæret AI-applikationer går galt? Udviklerne? Den ansvarlige person? Eller nogen længere nede i kæden?

AI-krigsførelsessystemer er allerede indsat i konflikterne i Ukraine og Palæstina-Israel, men disse spørgsmål er stadig stort set uprøvede.

Lad os håbe, at det forbliver sådan.