OpenAI meddelte, at de vil bruge C2PA-standarden til at tilføje metadata til billeder, der er genereret med DALL-E 3.

Udmeldingen kommer, fordi virksomheder fortsat leder efter måder at forhindre, at deres generative AI-produkter bliver brugt til at sprede misinformation.

C2PA er en åben teknisk standard, der tilføjer metadata til et billede, herunder dets oprindelse, redigeringshistorik og andre oplysninger. OpenAI siger, at billeder, der genereres ved hjælp af DALL-E 3 direkte eller via ChatGPT eller dets API, nu vil indeholde C2PA-data. Mobilbrugere vil se dette implementeret den 12. februar.

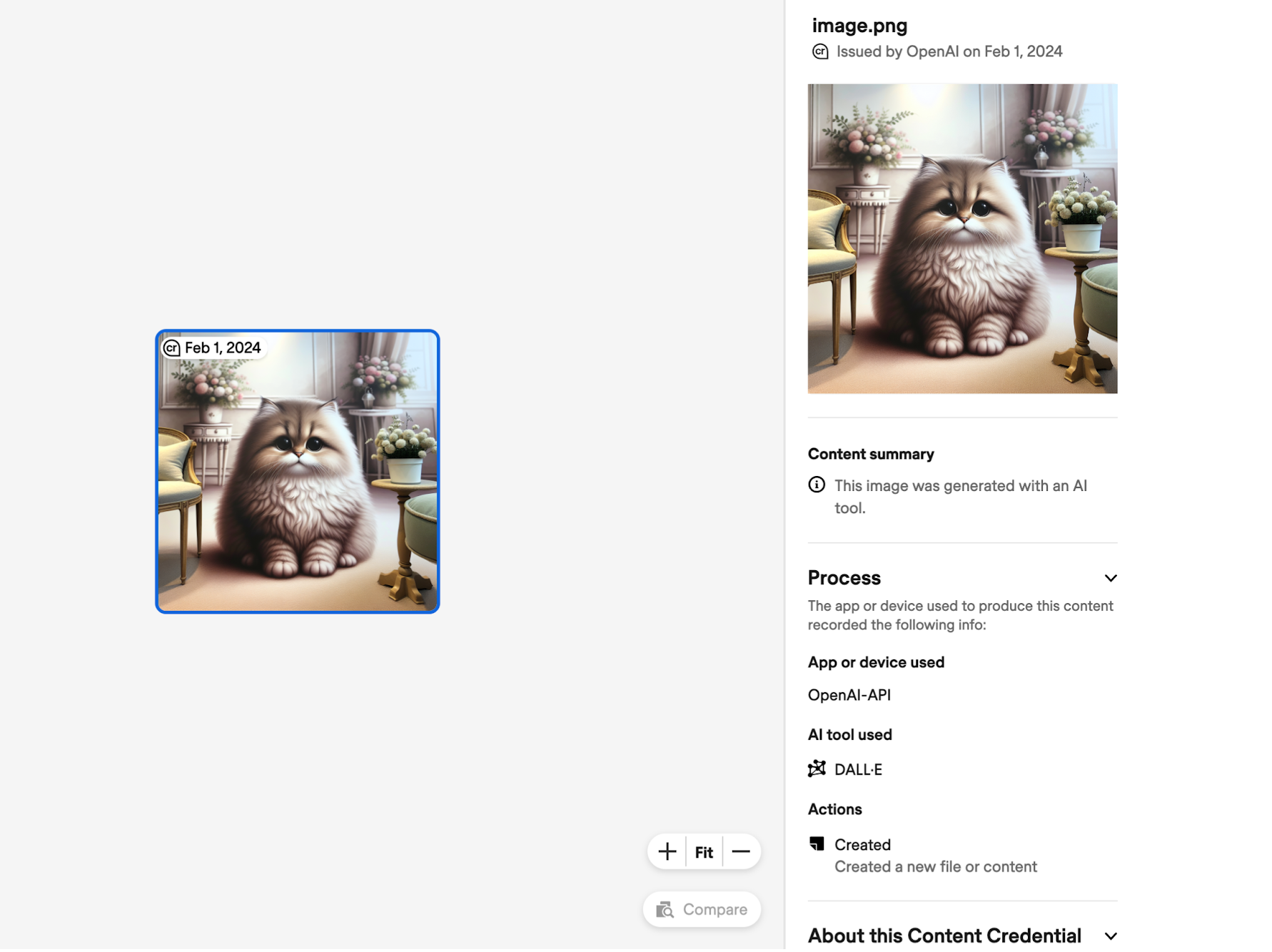

Et billede, der har fået tilføjet C2PA-metadata, kan uploades til steder som Bekræft legitimationsoplysninger for indhold for at kontrollere billedets oprindelse. Her er et eksempel på de oplysninger, C2PA afslører om et billede, der er lavet med DALL-E via API'en.

Sociale medieplatforme kan også bruge disse data til at markere og mærke billeder som AI-genererede. Meta annoncerede for nylig at den ville gøre en større indsats for at gøre det.

Tilføjelsen af C2PA-data øger filstørrelsen med eksempler på estimater fra OpenAI, der er citeret som:

- 3,1 MB → 3,2 MB for PNG via API (3% stigning)

- 287k → 302k for WebP gennem API (5% stigning)

- 287k → 381k for WebP gennem ChatGPT (32% stigning)

OpenAI anerkender, at "C2PA ikke er en sølvkugle til at løse problemer med herkomst." Metadata kan nemt fjernes, ofte utilsigtet.

Hvis du tager et skærmbillede af billedet, bevares C2PA-dataene ikke. Selv konvertering af et billede fra PNG til JPG vil ødelægge de fleste metadata. De fleste sociale medieplatforme fjerner metadata fra billeder, når de uploades.

OpenAI siger, at de ved at tilføje C2PA til DALL-E-billeder håber at opmuntre "brugerne til at anerkende, at disse signaler er nøglen til at øge pålideligheden af digital information."

Det gør det måske i begrænset omfang, men det faktum, at C2PA er så let at fjerne, hjælper ikke meget, når en person med vilje vil bruge et billede til at være vildledende. Om noget kan det måske bare bremse deepfakerne lidt.

Googles digitale vandmærke SynthID virker som en langt mere sikker løsning, men det er usandsynligt, at OpenAI vil bruge et værktøj, der er skabt af deres konkurrenter.