IBM Security offentliggjorde forskning på sin Security Intelligence-blog for at vise, hvordan AI-stemmekloner kunne injiceres i en live-samtale, uden at deltagerne var klar over det.

Efterhånden som stemmekloningsteknologien forbedres, har vi set falske robocalls der udgiver sig for at være Joe Biden, og fupopkald, der udgiver sig for at være et nødlidende familiemedlem, der beder om penge.

Lyden i disse opkald lyder godt, men fupopkaldet kan ofte let afværges ved at stille et par personlige spørgsmål for at identificere den, der ringer op, som en bedrager.

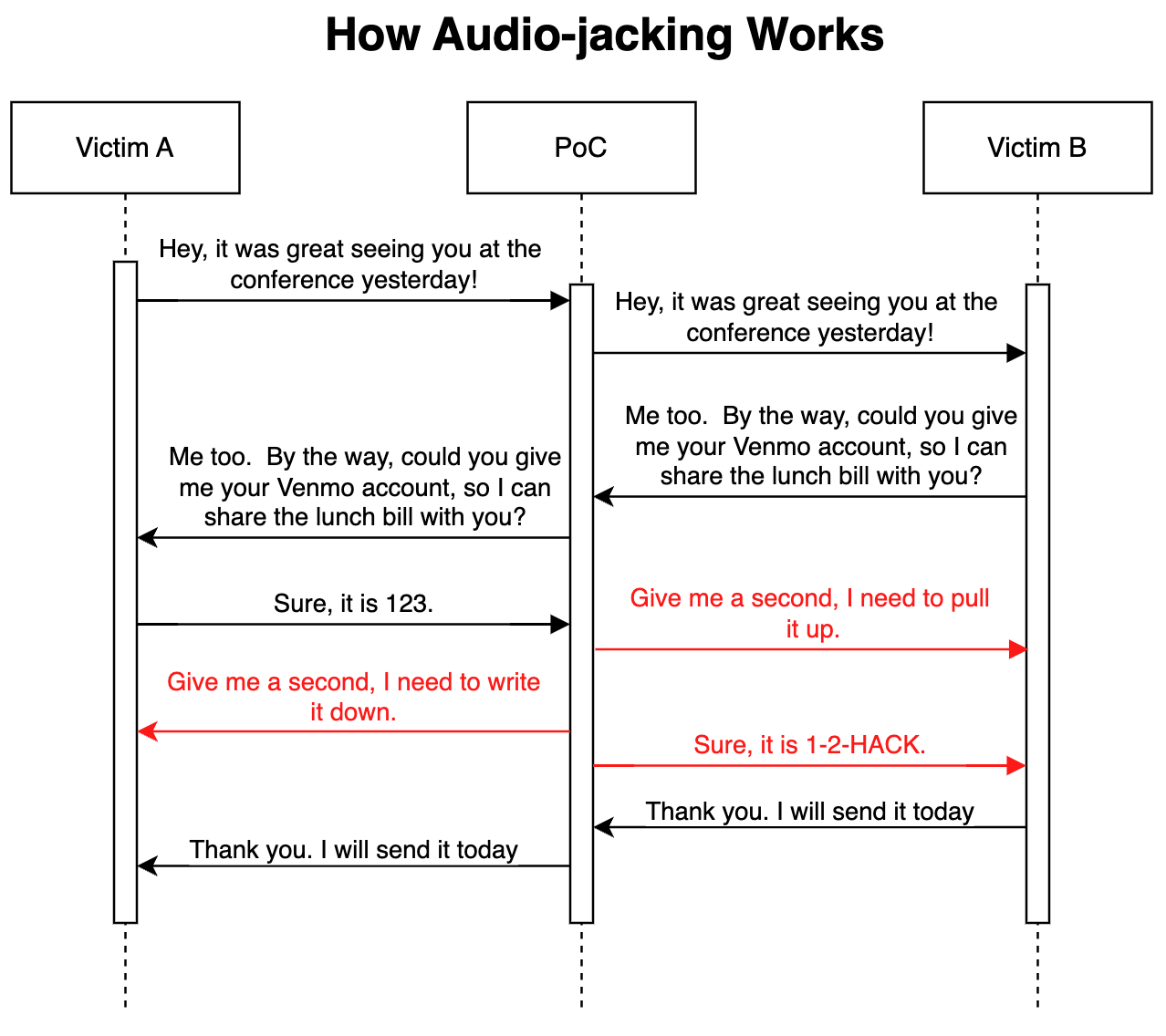

I deres avancerede proof of concept-angreb IBM's sikkerhedsforskere viste, at en LLM kombineret med stemmekloning kunne fungere som en man-in-the-middle til kun at kapre en afgørende del af en samtale i stedet for hele opkaldet.

Sådan fungerer det

Angrebet kan leveres via malware installeret på ofrenes telefoner eller en ondsindet kompromitteret Voice over IP (VoIP)-tjeneste. Når programmet er på plads, overvåger det samtalen og har kun brug for 3 sekunders lyd for at kunne klone begge stemmer.

En tale-til-tekst-generator gør det muligt for LLM at overvåge samtalen for at forstå konteksten for diskussionen. Programmet blev instrueret i at videresende samtalens lyd, som den er, men at ændre samtalens lyd, når en person beder om bankkontooplysninger.

Når personen svarer for at give sine bankkontooplysninger, ændrer stemmeklonen lyden, så den i stedet giver svindlerens bankoplysninger. Forsinkelsen i lyden under ændringen dækkes af noget fyldtale.

Her er en illustration af, hvordan proof of concept-angrebet (PoC) fungerer.

Fordi LLM'en videresender uændret lyd under størstedelen af opkaldet, er det virkelig svært at vide, at truslen er i spil.

Forskerne sagde, at det samme angreb "også kunne ændre medicinske oplysninger, såsom blodtype og allergier i samtaler; det kunne beordre en analytiker til at sælge eller købe en aktie; det kunne instruere en pilot til at omdirigere."

Forskerne sagde, at "det var overraskende og skræmmende nemt at bygge denne PoC." Efterhånden som stemmeklonernes intonation og følelser forbedres, og bedre hardware reducerer ventetiden, vil denne type angreb blive meget vanskelige at opdage eller forhindre.

Forskerne udvider konceptet ud over at kapre en lydsamtale og siger, at med "eksisterende modeller, der kan konvertere tekst til video, er det teoretisk muligt at opsnappe en live-streamet video, som f.eks. nyheder på tv, og erstatte det oprindelige indhold med et manipuleret."

Det kan være sikrere kun at tro på sine øjne og ører, når man fysisk er i nærheden af den person, man taler med.