En gruppe Chicago-baserede udviklere har udstyret kunstnere med Nightshade, en metode til at kæmpe imod uetisk datapraksis.

Nightshade er et sofistikeret værktøj, der er designet til at beskytte digitale kunstværker mod uautoriseret brug i AI-træning ved at introducere "giftige" prøver.

Disse ændringer er umærkelige for det menneskelige øje, men forstyrrer en AI's læringsproces og fører til forkerte associationer og reaktioner.

Den Forskerne skriver"Menneskeøjne kan se et skraveret billede af en ko på en grøn mark stort set uændret, men en AI-model kan se en stor lædertaske, der ligger i græsset."

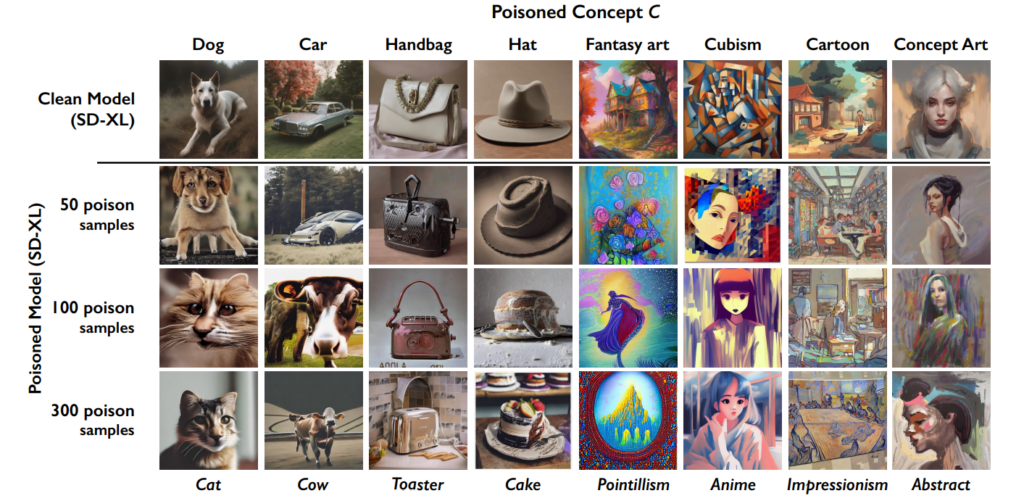

Effekten akkumuleres, så jo flere "forgiftede" billeder, der ender i et datasæt, jo mere forringes modellens ydeevne.

Dette værktøj kommer i tillæg til University of Chicagos tidligere skabelse, Glaze, som også hjælper kunstnere med at bekæmpe data scraping. "Glaze kan ændre ting som farver og penselstrøg og præsentere en anden kunstnerisk stil end den, der faktisk er der," forklarer udviklerne.

Nightshade afviger dog fra Glaze i sin tilgang. "Mens Glaze var et defensivt værktøj, er Nightshade designet til at være et offensivt værktøj", siger teamet.

Jeg er meget begejstret for at kunne fortælle, at "Artifact" er blevet Glazed og Nightshaded af @TheGlazeProject og sikke et perfekt værk til det. Dette er et maleri om generativ AI, der kannibaliserer den autentiske stemme hos menneskelige kreative. Når dette billede skrabes til træning, ja ... pic.twitter.com/0VNFIyabc2

- Kelly McKernan (@Kelly_McKernan) 14. januar 2024

Sådan virker Nightshade i fem trin

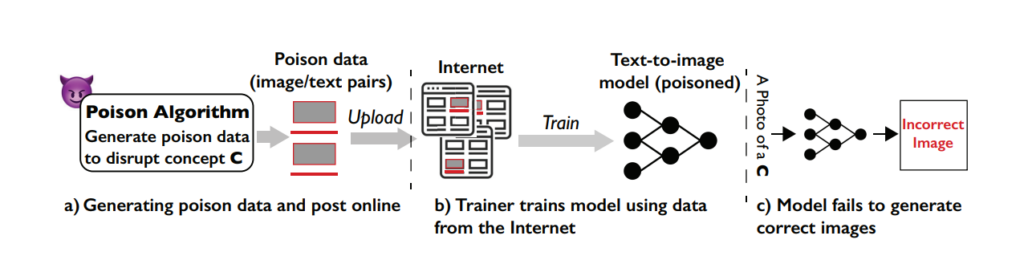

Nightshade er et smart værktøj, der bruger de maskinlæringsfunktioner, der er involveret i modeltræning, mod selve systemet, hvilket forgifter læringsprocessen og fører til dårligere resultater på tværs af forskellige modeller.

Forståelse af sårbarheden

Nightshade-angrebet udnytter en specifik svaghed i generative tekst-til-billede-modeller. Disse AI-modeller er trænet på store datasæt med billeder og tilsvarende tekstbeskrivelser.

Teamet fra University of Chicago opdagede dog, at mængden af træningsdata er ret begrænset for visse specifikke spørgsmål eller emner. Denne begrænsede datapool for specifikke spørgsmål gør disse modeller sårbare over for målrettede dataforgiftningsangreb.

Konceptet bag Nightshade

Nightshade er en sofistikeret metode, der er designet til at udføre det, der kaldes et prompt-specifikt forgiftningsangreb.

Med andre ord er det som at indføre en lille, omhyggeligt designet fejl i AI'ens indlæringsproces, som fører til betydelige og målrettede fejl, når AI'en genererer billeder baseret på bestemte opfordringer.

Den vigtigste funktion i Nightshade er dens evne til at producere "forgiftede" prøver, der ser normale ud for menneskelige øjne, men som er radikalt anderledes i forhold til, hvordan AI'en opfatter og lærer af dem.

Oprettelse af giftprøver

For at udføre et Nightshade-angreb genererer forskerne først det, de kalder 'ankerbilleder'. Det er billeder af et koncept, der ikke er relateret til det faktiske mål for angrebet.

Hvis målbegrebet f.eks. er "hund", kan ankerbillederne være af "katte". Disse ankerbilleder genereres af en AI-model, som brugerne kører på deres pc.

Dernæst finder forskerne virkelige billeder af målkonceptet (f.eks. hunde) og ændrer dem subtilt, så de passer til funktionerne i ankerbillederne i AI'ens opfattelse.

For et menneske ser disse modificerede billeder stadig ud som hunde, men for AI'en ligner de i høj grad katte. Selv om det kan være svært at forstå, er det vigtigt at huske, at de former og figurer, der skaber billeder, altid er grundlæggende ens.

Ændringerne kaldes adversarial perturbations. De er nøje beregnet til at flytte billedets repræsentation i AI'ens funktionsrum fra det område, der forbindes med katte, til det, der forbindes med hunde.

Hvordan angrebet påvirker AI-modeller

Når en generativ AI-model trænes på disse forgiftede prøver, begynder den at forbinde funktionerne i det urelaterede koncept (katte) med målkonceptet (hunde).

Når AI-modellen bliver bedt om at generere billeder af hunde, kan den derfor producere billeder af katte i stedet. Det skyldes, at modellens forståelse af, hvad der udgør en "hund", er blevet forvrænget af de forgiftede data.

Selvom det ikke "ødelægger" en AI-model fuldstændigt, gør det den mindre effektiv og mere uforudsigelig, hvilket helt sikkert kan ødelægge brugervenligheden.

AI-virksomheder vil sandsynligvis kæmpe imod Nightshade og lignende teknikker, men det kommer til at kræve tid og kræfter.

Påvirkning

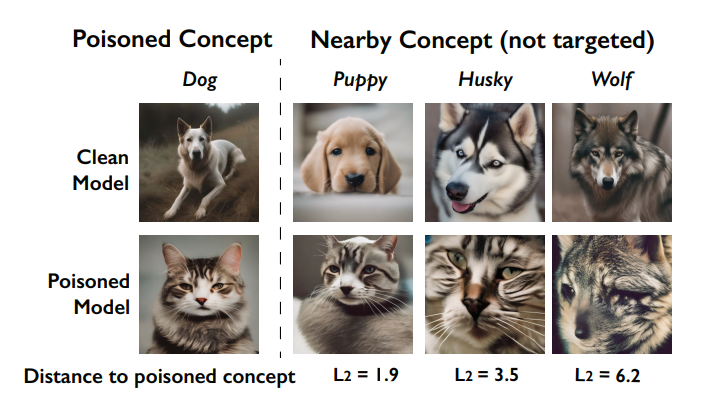

En vigtig effekt af Nightshade-angrebet er dets "gennemblødningseffekt". Det betyder, at forgiftningen af et koncept kan påvirke relaterede koncepter.

Hvis man for eksempel forgifter begrebet 'hund', kan det også påvirke, hvordan modellen genererer billeder af beslægtede dyr som 'ulve' eller 'ræve'.

bliver ødelagt af forgiftningen (kaldet gennemblødningseffekten). Kilde: University of Chicago via ArXiv

Når flere begreber forgiftes i en model, kan det desuden ødelægge modellens evne til at generere sammenhængende billeder til en lang række opgaver.

Hvordan kunstnere kan bruge Nightshade

Nightshade er et værktøj, du selv kan downloade og bruge, men det er ret ressourcekrævende og kræver en kompatibel Nvidia GPU med mindst 4 G hukommelse.

Denne proces kan blive forenklet i fremtiden, eller der kan komme cloud-tjenester, hvor du bare kan uploade dine billeder, så de kan blive Nightshade'et for dig.

Sådan bruger du Nightshade:

- Vælg dit kunstværk: Du kan enten trække et enkelt billede ind i billedpladsholderen eller vælge flere billeder ved hjælp af knappen "Vælg...".

- Juster parametre: Intensiteten bestemmer styrken af Nightshades effekt. En højere intensitet fører til en kraftigere forstyrrelse, men kan forårsage mærkbare ændringer i dit kunstværk. Renderingskvalitet angiver beregningstiden for at finde det optimale giftniveau. Højere kvalitet er lig med stærkere gift, men kræver mere tid. Hvis du har en GPU, vil denne proces gå hurtigere.

- Vælg output-bibliotek: Vælg, hvor du vil gemme Nightshaded-billederne.

- Vælg giftmærke: Nightshade fungerer ved at vildlede AI om visse begreber i dit billede. For eksempel kan den ændre billeder, der er tagget som "bil", så de opfattes som "ko" af AI-modeller. Nightshade vil foreslå et tag baseret på sin indholdsanalyse, når du vælger dit billede. Sørg for, at tagget nøjagtigt afspejler nøglebegrebet i dit billede, og juster det om nødvendigt. Effektiviteten af Nightshade øges, når dit billede forbindes med dette tag gennem alt-tekst, billedtekster eller tekst i nærheden.

- Kør Nightshade: Når du har færdiggjort dine indstillinger og bekræftet billedtagget, skal du starte processen ved at trykke på knappen "Kør". De ændrede billeder gemmes i din valgte outputmappe.

- Find detaljerede instruktioner i officiel brugervejledning her.

Fællesskabsreception til Nightshade-reception

Der har været overvældende støtte til kunstnere, der forsøger at forsvare deres arbejde mod AI, men som altid er der flere fraktioner, og nogle sammenligner det med et cyberangreb på AI-modeller.

Som svar til kritikerne præciserer teamet: "Nightshades mål er ikke at ødelægge modeller, men at øge omkostningerne ved at træne på ulicenserede data, så det bliver et rentabelt alternativ at licensere billeder fra deres skabere."

"Brugt ansvarligt kan Nightshade hjælpe med at afskrække modeltrænere, der ikke overholder ophavsret, opt-out-lister og do-not-scrape/robots.txt-direktiver", hævder de.

Debatten om dataskrabning og træning af AI-modeller er blevet ekstremt bitter efter kontroversen på Midjourney og en strøm af virksomheder, der bruger AI-genererede illustrationer og erstatter menneskelig arbejdskraft i processen.

Nightshade er ude!

Nightshade forgifter AI-modeller, hvis din kunst eller dine billeder bliver taget uden tilladelse, Glaze beskytter dig mod AI-efterligning. Det anbefales, at du bruger Nightshade først og derefter Glaze. En version, der gør begge dele, er på vej.

Læs denne tråd for mere information.

Gå efter dem 🫡. https://t.co/bU8EDthUcS pic.twitter.com/YddNu8xmJm

- Reid Southen (@Rahll) 19. januar 2024

Pludselig føles det, som om der er et voksende tomrum mellem teknologivirksomheder, der markedsfører AI som en filantropisk kraft, og offentligheden, der føler, at det trænger for langt ind i kulturen og samfundet.

Nightshade er faktisk ikke kun nyttig for kunstnere. Folk opfordrer så mange som muligt til at bruge disse værktøjer, hvilket skaber en mindre pulje af data af høj kvalitet, som AI-virksomheder kan skrabe.

Men har virksomhederne allerede data nok? Måske lige nu, men for at holde modellerne tidssvarende og opdaterede bliver AI-udviklerne nødt til at inddrage nye data i deres systemer på et eller andet tidspunkt.

#nightshade

Pro tip: Brug Nightshade på alt, hvad du uploader online (ikke kun din kunst), billeder fra sociale medier, daglige billeder af dit måltid, familie, hvalpe, killinger, tilfældige selfies og gadebilleder - og lad spillet begynde.- rediger ballai 🌿 (@eballai) 19. januar 2024

I Glaze og Nightshade ser vi en ny teknologisk og etisk kamp mellem skabere og AI-virksomheder.

Det bliver mere og mere interessant, og måske er der lignende måder at bedrage og forgifte sprogmodeller på?

Dette kombineret med juridiske slagsmål kan betyde, at generativ AI går ind i en ustabil periode. Det bliver et stort år for teknologien.