Da Google annoncerede udgivelsen af sine Gemini-modeller, var der stor begejstring, da virksomheden sagde, at de var på niveau med tilbuddene fra OpenAI. Det er måske ikke helt sandt.

Google sagde, at dets Gemini Ultra modellen er bedre end GPT-4. Modellen er endnu ikke frigivet, så vi bliver nødt til at tage deres benchmark-testresultater for gode varer. Gemini Pro er blevet udgivet, og Google siger, at den er på niveau med GPT-3.5.

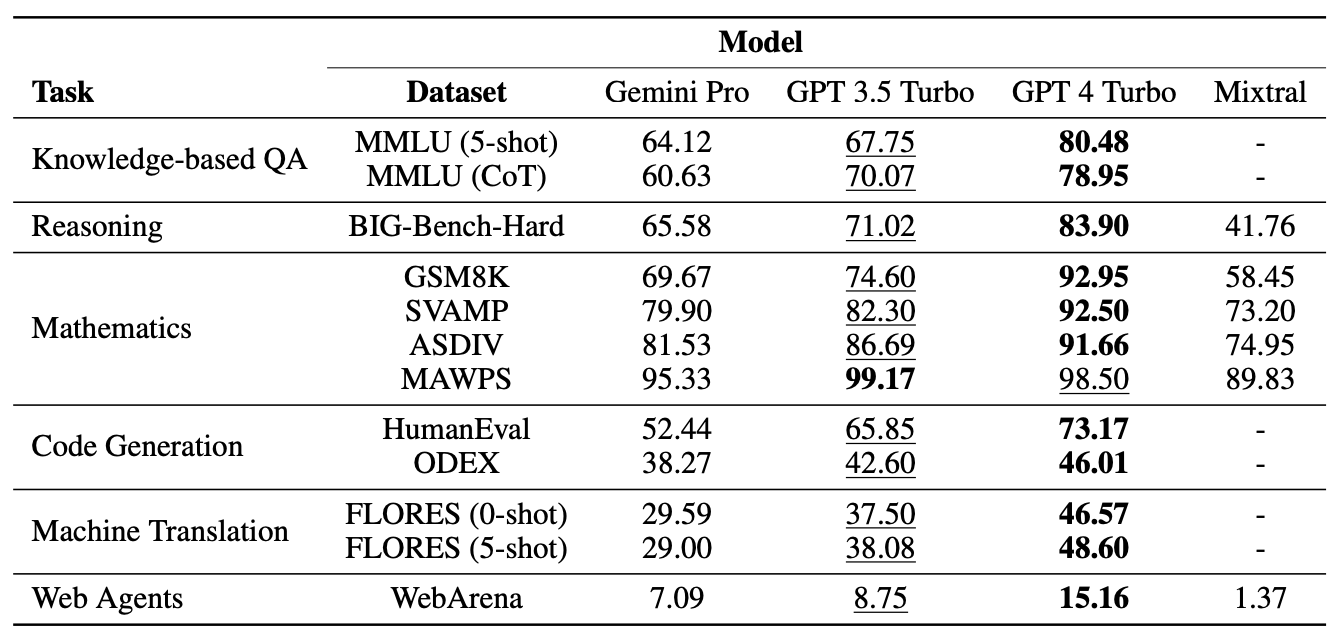

Forskere fra Carnegie Mellon University og AI-softwareplatformen BerriAI satte Gemini Pro på en række opgaver for at teste dens evne til at forstå og generere sprog.

De kørte de samme tests med GPT-3.5 Turbo, GPT-4 Turbo og Mistral AI's nye Mixtral 8x7B model.

Googles Gemini slog for nylig igennem som en stor konkurrent til OpenAI's GPT. Spændende! Men vi undrede os:

Hvor god er Gemini egentlig?

På CMU udførte vi en upartisk, dybdegående og reproducerbar undersøgelse, der sammenlignede Gemini, GPT og Mixtral.

Papir: https://t.co/S3T7ediQLa

🧵 pic.twitter.com/NmEOeDd8pI- Graham Neubig (@gneubig) 19. december 2023

Resultater

Ikke overraskende kom GPT-4 ud på toppen, men Google vil være mindre spændt på at se, hvordan Gemini Pro klarede sig i forhold til GPT 3.5 Turbo. I en opsummering af holdets resultater, papiret "Geminis Pro-model opnåede en sammenlignelig, men lidt ringere nøjagtighed sammenlignet med den nuværende version af OpenAI's GPT 3.5 Turbo."

Her er et sammendrag af resultaterne.

Modellerne blev bedt om at bruge BerriAI's LiteLLM-grænseflade, og hver model fik nøjagtig de samme beskeder og den samme evalueringsprotokol.

Modellerne blev testet på multiple choice-spørgsmål, generelle ræsonnementer, matematiske ræsonnementer, kodegenerering, sprogoversættelse og som webagent.

En af grundene til, at Gemini Pro klarede sig dårligt i multiple choice-spørgsmålene, er, at den havde en stærk positionel bias. Den valgte ofte svaret i position D, uanset om det var korrekt eller ej. Interessant nok er dette noget, som Microsofts Medprompt løses med blanding.

På trods af at Gemini Pro tabte nogle af testene, slog den GPT-3.5 Turbo på to områder, nemlig ordsortering og symbolmanipulation og -oversættelse.

I alle de oversættelsesopgaver, Gemini Pro gennemførte, klarede den sig bedre end alle de andre modeller, inklusive GPT-4. Gemini Pros endelige score på oversættelsestestene var dog lavere end GPT-3.5, fordi den afviste at gennemføre nogle anmodninger, da dens overivrige indholdsmoderation blev sat i gang.

Og hvad så?

Google bestrider de tal, som forskerne kom frem til, og insisterer på, at deres tal viser, at Gemini Pro er på niveau med eller bedre end GPT-3.5. Hvis vi tager højde for de utallige variabler og giver Google lidt spillerum, kan vi dele forskellen og sige, at Gemini Pro og GPT-3.5 stort set er ens.

Det vigtigste her er, at Gemini Pro, en helt ny model, som Google har brugt måneder på at udvikle, ikke slår en model, der har været ude i mere end et år og er gratis at bruge via ChatGPT.

Gemini Ultra forventes at blive udgivet i begyndelsen af 2024. Vil den leve op til sin påstand om at være bedre end GPT-4? Lad os håbe, at professor Graham Neubig og hans team snart får mulighed for at køre lignende benchmarking-tests.