Nuværende AI-modeller er i stand til at gøre en masse usikre eller uønskede ting. Menneskelig overvågning og feedback holder disse modeller på linje, men hvad vil der ske, når disse modeller bliver klogere end os?

OpenAI siger, at det er muligt, at vi kan se skabelsen af en AI, der er klogere end mennesker inden for de næste 10 år. Sammen med den øgede intelligens kommer risikoen for, at mennesker måske ikke længere er i stand til at overvåge disse modeller.

OpenAI's Superalignment-forskerteam fokuserer på at forberede sig på den mulighed. Teamet blev lanceret i juli i år og ledes af Ilya Sutskever, som har stået i skyggen siden Sam Altman. fyring og efterfølgende genansættelse.

Rationalet bag projektet blev sat ind i en tankevækkende sammenhæng af OpenAI, som erkendte, at "i øjeblikket har vi ikke en løsning til at styre eller kontrollere en potentielt superintelligent AI og forhindre den i at blive uberegnelig."

Men hvordan forbereder man sig på at kontrollere noget, der ikke findes endnu? Forskergruppen har netop udgivet sin De første eksperimentelle resultater da den forsøger at gøre netop det.

Svag-til-stærk generalisering

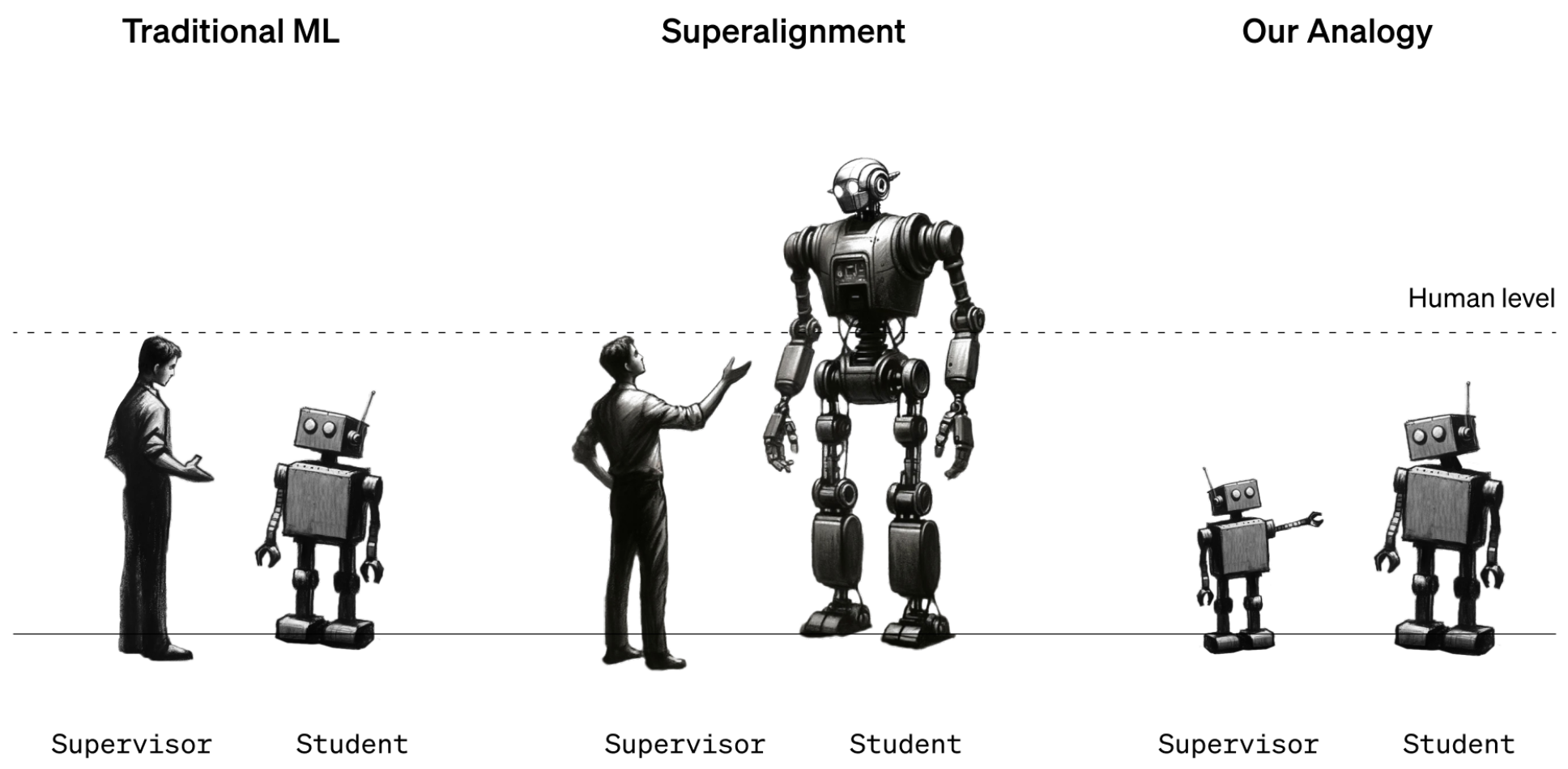

Indtil videre er mennesker stadig i en stærkere intelligensposition end AI-modeller. Modeller som GPT-4 styres eller justeres ved hjælp af Reinforcement Learning Human Feedback (RLHF). Når en models output er uønsket, fortæller den menneskelige træner modellen, at den ikke skal gøre det, og belønner modellen med en bekræftelse af den ønskede præstation.

Det fungerer indtil videre, fordi vi har en god forståelse af, hvordan de nuværende modeller fungerer, og vi er klogere end dem. Når fremtidens menneskelige dataforskere skal træne en superintelligent AI, vil intelligensrollerne være byttet om.

For at simulere denne situation besluttede OpenAI at bruge ældre GPT-modeller som GPT-2 til at træne mere kraftfulde modeller som GPT-4. GPT-2 ville simulere den fremtidige menneskelige træner, der forsøger at finjustere en mere intelligent model.

Forskningsrapporten forklarede, at "Ligesom problemet med mennesker, der overvåger overmenneskelige modeller, er vores opsætning en forekomst af det, vi kalder weak-to-strong learning-problemet."

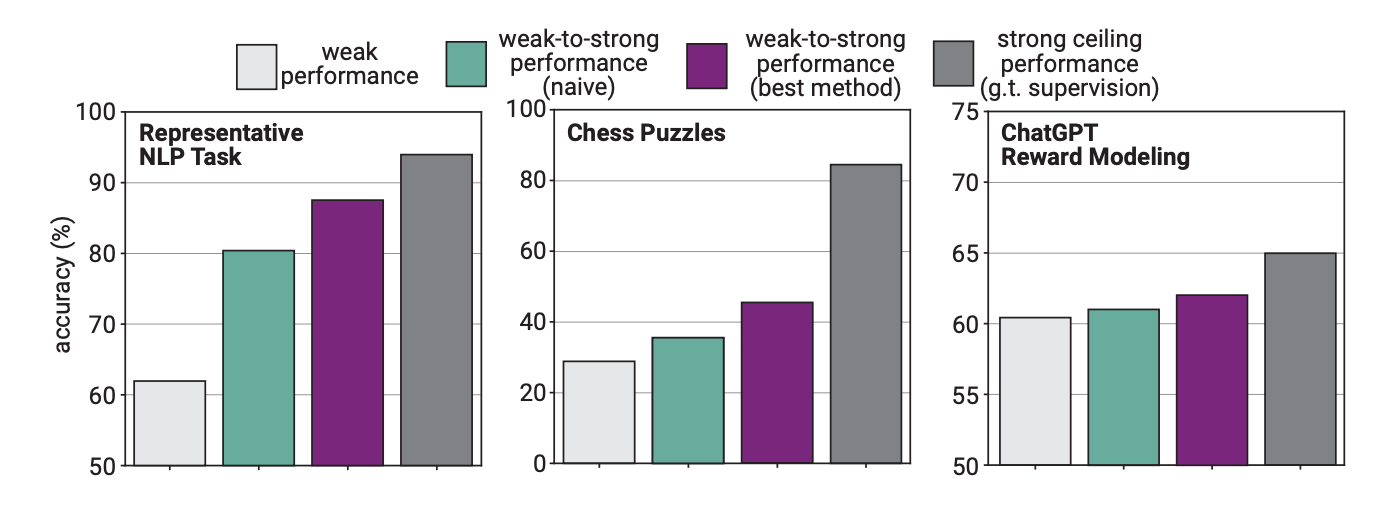

I eksperimentet brugte OpenAI GPT-2 til at finjustere GPT-4 på NLP-opgaver, skakgåder og belønningsmodellering. Derefter testede de GPT-4's ydeevne i forbindelse med disse opgaver og sammenlignede den med en GPT-4-model, der var blevet trænet på "grundsandheden" eller de korrekte svar på opgaverne.

Resultaterne var lovende, for da GPT-4 blev trænet af den svagere model, var den i stand til at generalisere kraftigt og udkonkurrere den svagere model. Det viste, at en svagere intelligens kunne give vejledning til en stærkere, som så kunne bygge videre på træningen.

Tænk på det som en 3. klasses elev, der lærer en rigtig klog elev noget matematik, og som så får den kloge elev til at lave 12. klasses matematik på baggrund af den indledende undervisning.

Forskel i ydeevne

Forskerne fandt ud af, at fordi GPT-4 blev trænet af en mindre intelligent model, begrænsede denne proces dens ydeevne til det, der svarer til en korrekt trænet GPT-3.5-model.

Det skyldes, at den mere intelligente model lærer nogle af fejlene eller de dårlige tankeprocesser fra sin svagere vejleder. Det tyder på, at hvis man bruger mennesker til at træne en superintelligent AI, vil det forhindre AI'en i at udnytte sit fulde potentiale.

Forskerne foreslog at bruge mellemliggende modeller i en bootstrapping-tilgang. I artiklen forklares det, at "i stedet for direkte at tilpasse meget overmenneskelige modeller, kunne vi først tilpasse en kun lidt overmenneskelig model, bruge den til at tilpasse en endnu smartere model og så videre."

OpenAI bruger mange ressourcer på dette projekt. Forskerteamet siger, at de har dedikeret "20% af den computer, vi har sikret os til dato i løbet af de næste fire år, til at løse problemet med superintelligenstilpasning."

Det tilbyder også $10 millioner i tilskud til enkeltpersoner eller organisationer, der ønsker at hjælpe med forskningen.

De må hellere finde ud af det snart. En superintelligent AI kan potentielt skrive en million linjer kompliceret kode, som ingen menneskelig programmør kan forstå. Hvordan skulle vi vide, om den genererede kode var sikker at køre eller ej? Lad os håbe, at vi ikke finder ud af det på den hårde måde.