Træning af AI-modeller som GPT-4 har for det meste været baseret på datasæt bestående af tekst og billeder. Metas Ego-Exo4D multimodale perceptionsdatasæt giver dataforskere et rigt nyt sæt træningsdata.

Du kan lære en ny færdighed ved at læse en bog, men det er meget nemmere, når nogen viser dig, hvordan du gør noget, mens de forklarer dig det. Det er det mål, Metas FAIR-team (Fundamental Artificial Intelligence Research) har for Ego-Exo4D.

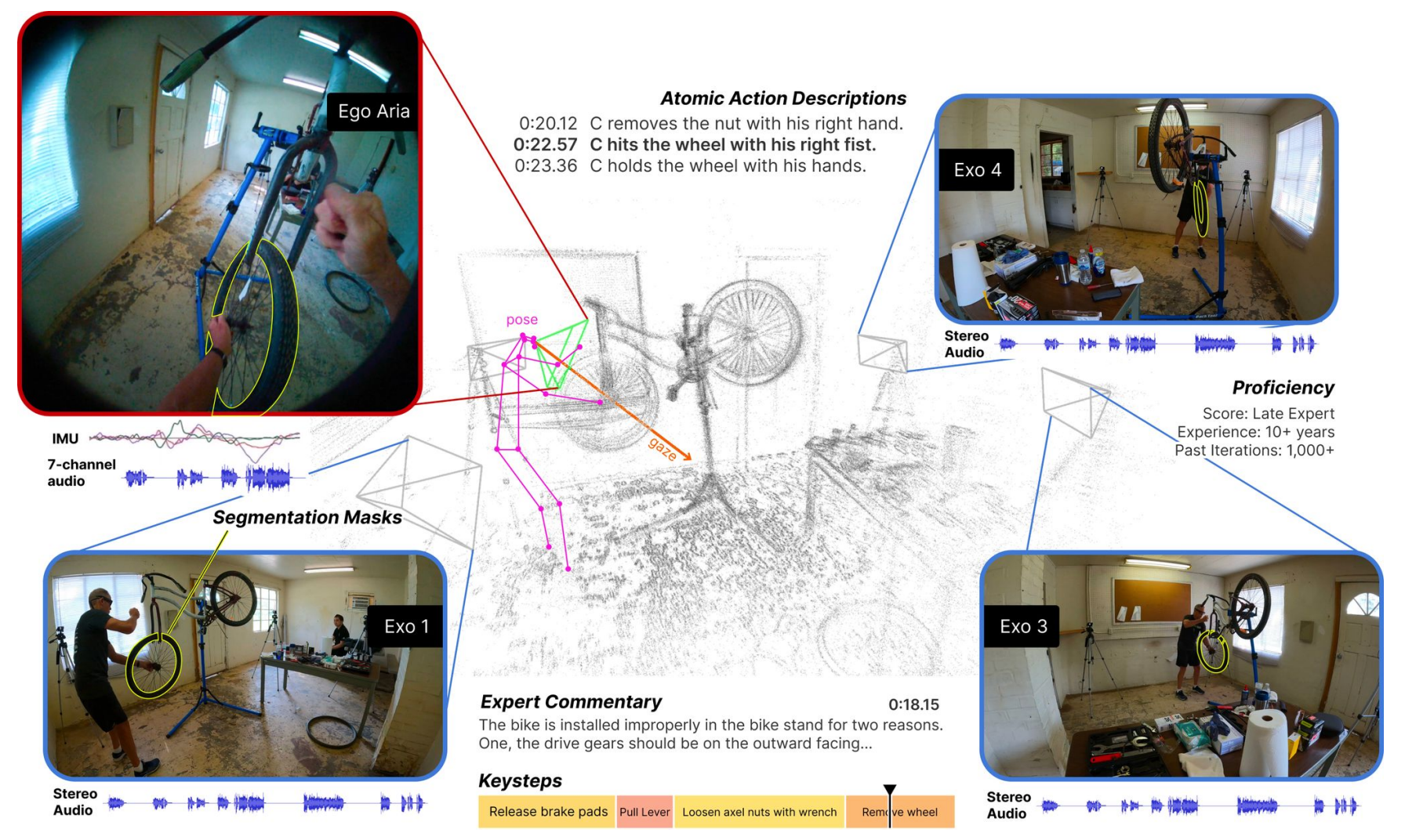

Datasættet består af videoer i førstepersons- (Ego) og tredjepersons- (Exo) perspektiv af mennesker, der udfører forskellige dygtige menneskelige aktiviteter. Det kan være alt fra at lave mad, danse, spille musik eller reparere en cykel. Dataene blev indsamlet i 13 byer verden over af 839 kamerabærere, der optog 1422 timers video.

Videoerne, som optages samtidigt, suppleres derefter med yderligere data fra Metas Project Aria-briller.

Project Aria-briller er bærbare computere i brilleform. De optager brugerens video og lyd samt oplysninger om øjenstyring og placering. Brillerne registrerer også hovedpositioner og 3D-punktskyer af omgivelserne.

Resultatet er et datasæt med samtidige videoer af en opgave, der udføres, med førstepersonsfortællinger fra kamerabærerne, der beskriver deres handlinger, og hoved- og øjensporing af den person, der udfører opgaven.

Vi præsenterer Ego-Exo4D - et grundlæggende datasæt og en benchmark-suite med fokus på dygtige menneskelige aktiviteter til støtte for forskning i videolæring og multimodal perception. Det er det største offentlige datasæt af sin art nogensinde.

Flere detaljer ➡️ https://t.co/82OR4msehv pic.twitter.com/NTI1kdj1RN

- AI på Meta (@AIatMeta) 4. december 2023

Meta tilføjede derefter tredjepersons play-by-play-beskrivelser af hver kamerabærers handlinger. Meta hyrede også eksperter inden for flere områder til at tilføje tredjepersons ekspertkommentarer, der kritiserede den måde, personen i videoen udførte opgaven på.

Ved at indsamle både egocentriske og eksocentriske synspunkter kan Ego-Exo4D-datasættet vise forskere, hvordan aktiviteter ser ud fra forskellige perspektiver. Det kan i sidste ende hjælpe dem med at udvikle computersynsalgoritmer, der kan genkende, hvad en person laver fra et hvilket som helst perspektiv.

Ego-Exo4D åbner for nye læringsmuligheder

En af de største forhindringer for at opnå AGI eller træne robotter mere effektivt er den manglende sanseopfattelse, som computere har. Som mennesker har vi så mange sanseindtryk fra vores omgivelser, at vi ofte tager dem for givet, når vi lærer nye færdigheder.

Ego-Exo4D vil være en yderst nyttig ressource til at bygge bro over denne kløft.

Dr. Gedas Bertasius, adjunkt ved Institut for Datalogi på University of North Carolina, siger: "Ego-Exo4D handler ikke kun om at indsamle data, men om at ændre den måde, AI forstår, opfatter og lærer på. Med menneskecentreret læring og perspektiv kan AI blive mere hjælpsom i vores dagligdag og hjælpe os på måder, vi kun kan forestille os."

Meta siger, at de håber, at Ego-Exo4D vil "gøre det muligt for fremtidens robotter at få indsigt i komplekse fingerfærdige manipulationer ved at se dygtige menneskelige eksperter i aktion."

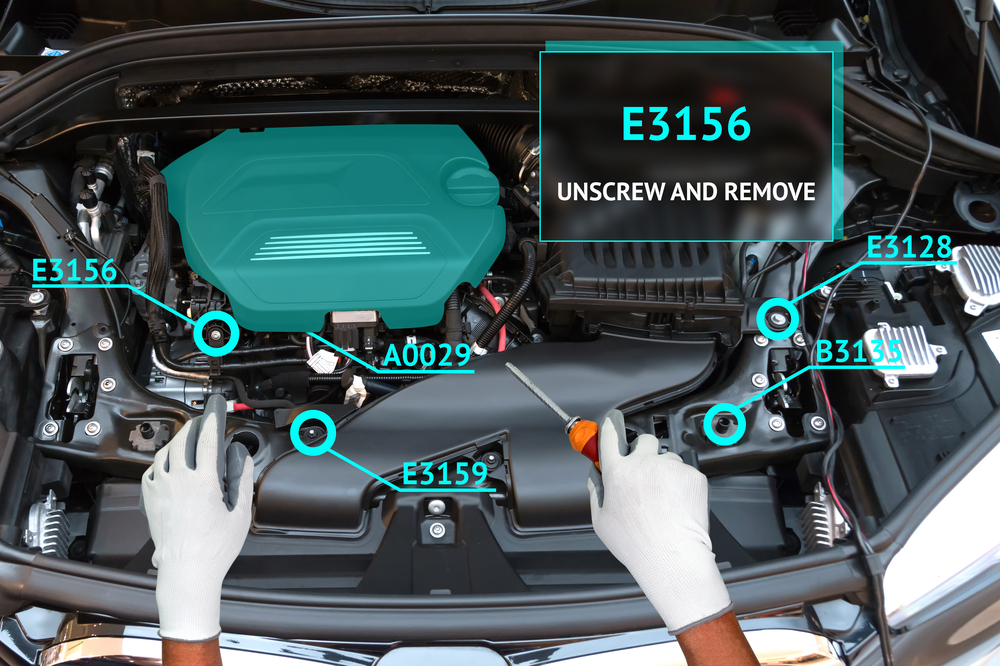

Dette datasæt kombineret med Project Aria-briller vil snart også muliggøre en virkelig fordybende læringsoplevelse for mennesker. Forestil dig at udføre en opgave, mens dine briller bruger augmented reality (AR) til at overlejre en instruktionsvideo eller tale dig igennem din opgave.

Du kan lære at spille klaver og få et visuelt overlay, der viser dig, hvor dine hænder skal bevæge sig med lydrådgivning i realtid, mens du gør det. Eller du kan åbne kølerhjelmen på din bil og blive guidet til at fejlfinde og løse et motorproblem.

Det bliver interessant at se, om Metas Ego How-To læringskoncept vil få Project Aria-brillerne til at slå bedre an end det mislykkede Google Glass-produkt. Der er dog ikke noget nyt om, hvornår de kan købes endnu.

Meta vil lave Ego-Exo4D-datasættet tilgængelig til download inden udgangen af december.