Nvidia skalerede og optimerede sin Eos AI-supercomputer til at sætte nye MLPerf AI-træningsrekorder.

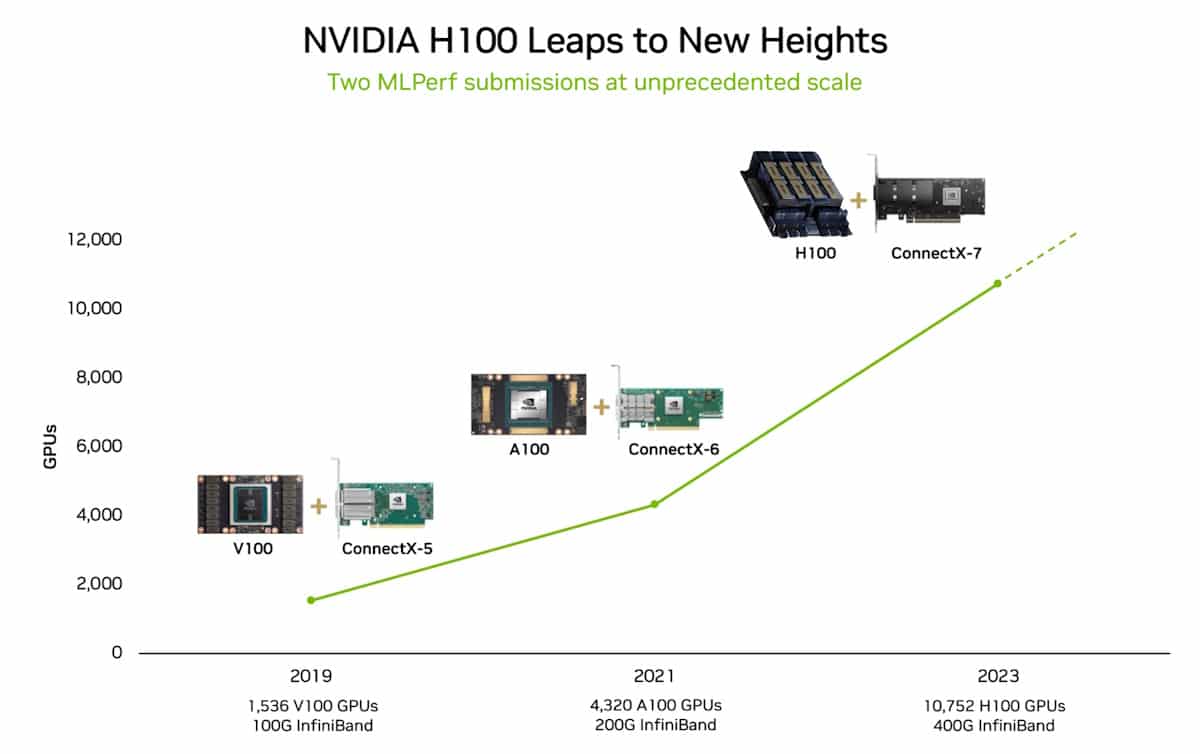

Da Nvidia tændte for sin AI-supercomputer Eos i maj, blev 10.752 NVIDIA H100 Tensor Core GPU'er vækket til live, og de er netop blevet testet i den virkelige verden.

Denne hidtil usete processorkraft sammen med nye softwareoptimeringer har gjort det muligt for Eos at skubbe MLPerf Benchmark ind i et rekordområde.

Open source-benchmarket MLPerf er et sæt trænings- og inferencetests, der er designet til at måle ydeevnen af maskinlæringsarbejdsbelastninger på virkelige datasæt.

Et af de bemærkelsesværdige resultater var, at Eos var i stand til at træne en GPT-3-model med 175 milliarder parametre på en milliard tokens på bare 3,9 minutter.

Da Nvidia satte rekorden på dette benchmark for mindre end 6 måneder siden, tog det næsten 3 gange så lang tid med en tid på 10,9 minutter.

Nvidia var også i stand til at opnå en effektivitet på 93% under testene, hvilket betyder, at den brugte næsten al den computerkraft, der teoretisk var til rådighed i Eos.

Microsoft Azure, som bruger stort set den samme H100-opsætning som Eos i sin virtuelle ND H100 v5-maskine, kom inden for 2% af Nvidias testresultater i sine MLPerf-tests.

I 2018 sagde Jensen Huang, CEO for Nvidia, at GPU'ernes ydeevne vil blive mere end fordoblet hvert andet år. Denne påstand blev døbt Haungs lov og har vist sig at være sand, da den efterlader Moore's lov forsvinder i computerens bakspejl.

Og hvad så?

MLPerf-benchmarktræningstesten, som Nvidia klarede, bruger kun en del af det fulde datasæt, som GPT-3 blev trænet på. Hvis man tager den tid, Eos satte i MLPerf-testen, og ekstrapolerer til hele GPT-3-datasættet, kunne den træne hele modellen på bare 8 dage.

Hvis man forsøgte at gøre det med det tidligere state-of-the-art system bestående af 512 A100 GPU'er, ville det tage omkring 170 dage.

Hvis du skulle træne en ny AI-model, kan du så forestille dig den forskel i time-to-market og omkostninger, som 8 dage i forhold til 170 dage udgør?

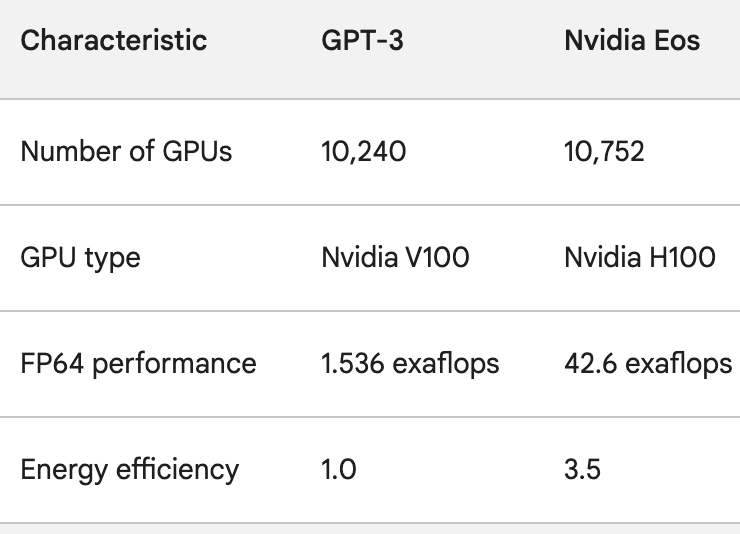

H100 GPU'erne er ikke kun meget kraftigere end A100 GPU'erne, de er også op til 3,5 gange mere energieffektive. Energiforbrug og AI's CO2-fodaftryk er reelle problemer, der skal løses.

For at få en idé om, hvor hurtigt AI-behandling forbedres, kan man tænke på ChatGPT, som gik i luften for lidt under et år siden. Den underliggende model, GPT-3, blev trænet på 10.240 Nvidia V100 GPU'er.

Mindre end et år senere har Eos 28 gange så meget processorkraft som det setup med en 3,5 gange større effektivitet.

Da OpenAI's Sam Altman afsluttede den seneste DevDay, sagde han, at de projekter, OpenAI arbejdede på, ville få de seneste udgivelser til at se gammeldags ud.

I betragtning af det spring i processorkraft, som virksomheder som Nvidia opnår, opsummerer Altmans påstand sandsynligvis fremtiden for AI-industrien som helhed.