Multimodale store sprogmodeller (MLLM) som GPT-4V er virkelig gode til at analysere og beskrive billeder, men nogle gange hallucinerer de og tager fejl. En ny tilgang kaldet Woodpecker kan rette op på det.

Hvis du beder en MLLM om at beskrive et foto, kan den normalt udpege objekterne og beskrive scenen nøjagtigt. Men ligesom med svar på tekstprompter gør modellen nogle gange antagelser baseret på genstande eller begreber, der ofte optræder sammen.

Det betyder, at en MLLM kan beskrive et foto af en butiksfacade og sige, at der er mennesker i billedet, selvom der faktisk ikke er nogen.

Det er et løbende arbejde at rette hallucinationer i tekstbaserede LLM'er, men det bliver meget nemmere, når modellen er forbundet til internettet. LLM'en kan generere et tekstsvar på en opfordring, tjekke det for ægthed baseret på relevante internetdata og selv korrigere, hvor det er nødvendigt.

Forskere fra Tencents YouTu Lab og University of Science and Technology of China tog denne tilgang og omsatte den til en visuel løsning kaldet Woodpecker.

Enkelt sagt opbygger Woodpecker en mængde viden ud fra billedet, og så kan en LLM bruge det som reference til at korrigere den oprindelige beskrivelse, der er genereret af MLLM.

Her er en kort beskrivelse af, hvordan det fungerer:

- En LLM som GPT-3.5 Turbo analyserer den beskrivelse, der genereres af MLLM, og udtrækker nøglebegreber som objekter, mængder og attributter. I sætningen "Manden har en sort hat på." udtrækkes f.eks. objekterne "mand" og "hat".

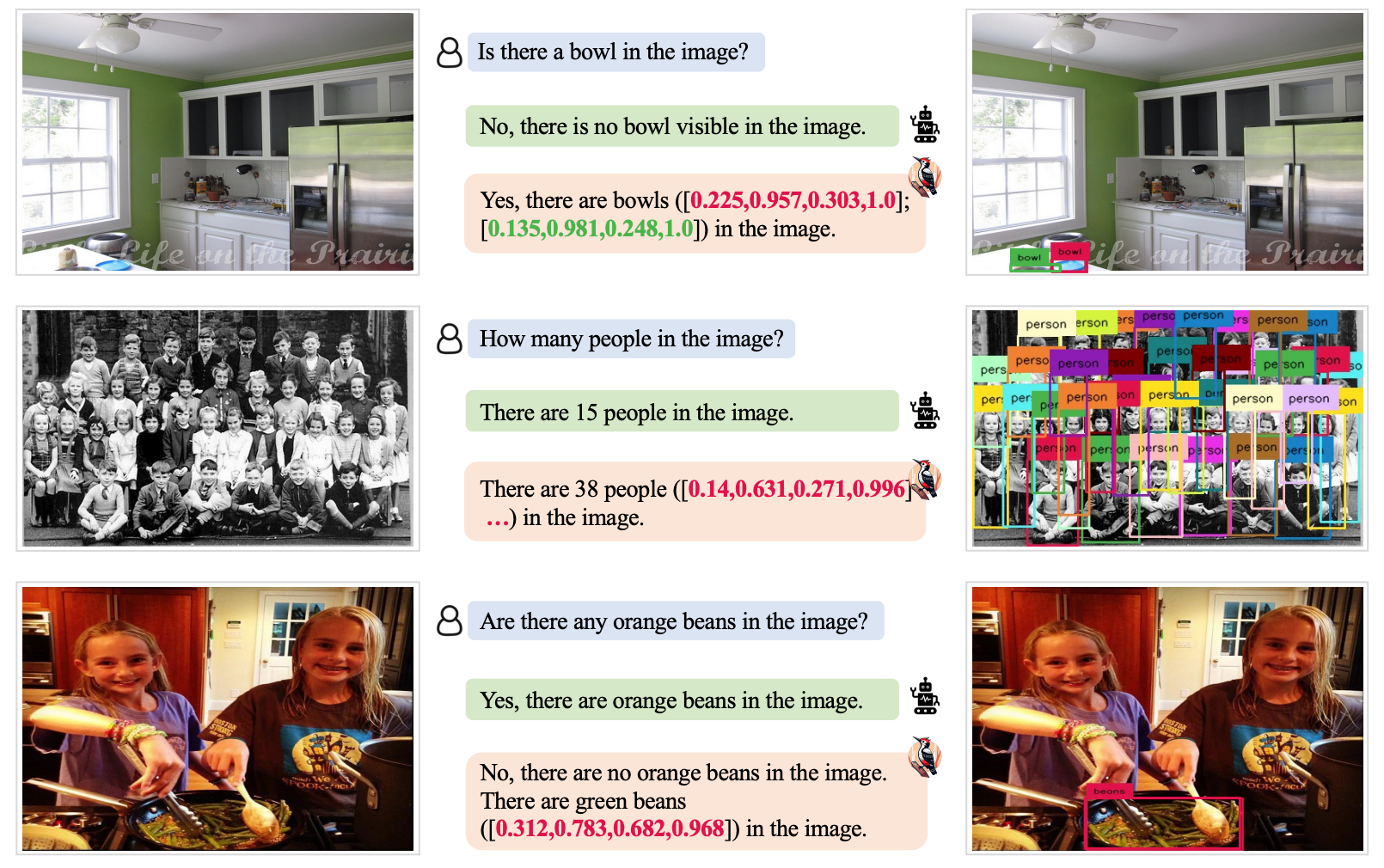

- En LLM bliver derefter bedt om at generere spørgsmål relateret til disse begreber som "Er der en mand på billedet?" eller "Hvad har manden på?".

- Disse spørgsmål sendes som prompts til en VQA-model (Visual Question Answering). Grounding DINO udfører objektdetektering og -tælling, mens BLIP-2-FlanT5 VQA besvarer attributrelaterede spørgsmål efter at have analyseret billedet.

- En LLM kombinerer svarene på spørgsmålene til en visuel vidensbase for billedet.

- En LLM bruger denne referenceviden til at korrigere eventuelle hallucinationer i den oprindelige MLLM's beskrivelse og tilføjer detaljer, som den har overset.

Forskerne kaldte deres metode Woodpecker med henvisning til, hvordan fuglen plukker insekter ud af træerne.

Testresultaterne viste, at Woodpecker opnåede en forbedring af nøjagtigheden på 30,66% for MiniGPT4 og 24,33% for mPLUG-Owl-modellerne.

Den generiske karakter af de modeller, der kræves i denne tilgang, betyder, at Woodpecker-tilgangen nemt kan integreres i forskellige MLLM'er.

Hvis OpenAI integrerer Woodpecker i ChatGPT, kan vi se en markant forbedring af den allerede imponerende visuelle ydeevne. En reduktion af MLLM-hallucinationer kan også forbedre automatiseret beslutningstagning i systemer, der bruger visuelle beskrivelser som input.