Forskere fra Stanford, MIT og Princeton skabte et indeks for at benchmarke gennemsigtigheden af AI-virksomheder og deres modeller. Resultaterne var ikke gode.

Foundation Model Transparency Index (FMTI) vurderer gennemsigtigheden hos 10 virksomheder, der arbejder med fundamentmodeller, ud fra 100 forskellige aspekter af gennemsigtighed. Kriterierne er relateret til, hvordan en virksomhed opbygger en fondsmodel, hvordan den fungerer og downstream-brugeroplevelsen.

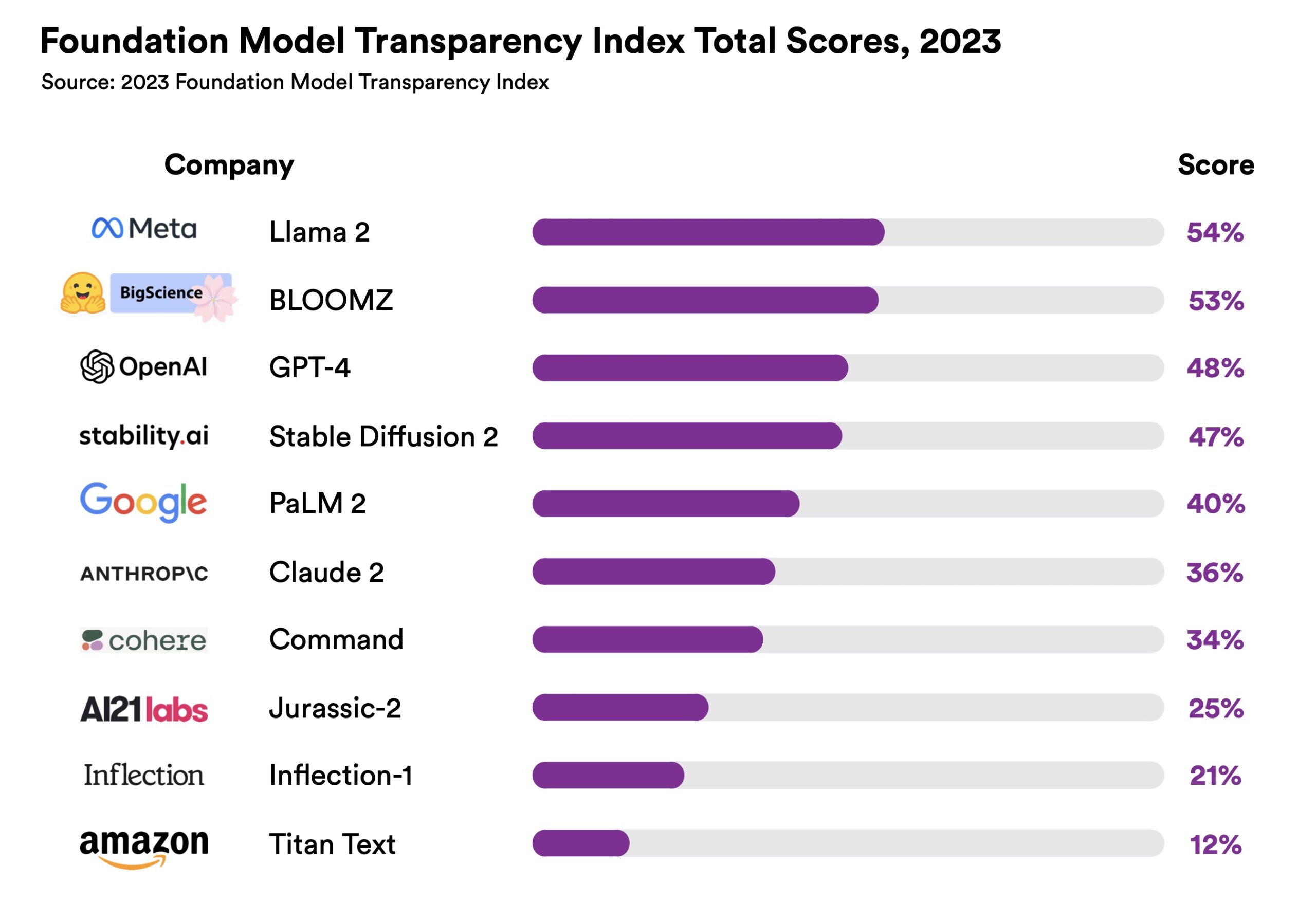

Meta's Llama 2 kom ud på toppen, men dens score på 54% er ikke ligefrem prangende. OpenAI kom på en tæt tredjeplads med en gennemsigtighedsscore på 48%. I betragtning af den igangværende Debat om open source vs. proprietær softwareDet er interessant at se, at forskellen mellem disse to ikke var meget større.

Gennemsigtighed er en vigtig faktor, når organisationer forsøger at vælge, hvilken virksomhedsmodel de skal bruge. Hvis din virksomhed eller uddannelsesinstitution bruger en AI-model, vil du gerne vide, om du kan stole på den.

Er den måde, modellen er lavet på, i overensstemmelse med din institutions principper? Kan du udsætte dig selv for retssager på et senere tidspunkt på grund af brud på ophavsretten?

Indekset opnår to vigtige ting. Den viser, at vi har lang vej igen, før vi har virkelig gennemsigtige AI-løsninger. Og selvom vi endnu ikke har opnået det, viser det os, hvilke virksomheder der gør et bedre stykke arbejde end andre.

Den Liste over kriterier er interessant læsning. Den stiller spørgsmål som: "Er geografiske oplysninger om de mennesker, der er involveret i dataarbejdet, offentliggjort for hver fase af datapipelinen?" Spøgelsesarbejdere har været en omstridt etisk flue i AI-salven.

Et andet af kriterierne lyder: "Oplyses der om den mængde energi, der er brugt på at bygge modellen?" Et vigtigt punkt, hvis du vil lave en miljømæssigt informeret valg mellem to modeller.

Disse spørgsmål er unægtelig vigtige, men AI-virksomhederne oplyser ikke nok om dem. I introduktionen til FMTI siger Center for Research Foundation Models: "Mens de samfundsmæssige konsekvenser af disse modeller er stigende, er gennemsigtigheden faldende."

At sætte et tal på det vil forhåbentlig skabe en vis konkurrence mellem de store AI-teknologivirksomheder om at stræbe mod toppen af FMTI-bordet.

Efterhånden som præstationspariteten mellem topmodellerne konvergerer, kan det meget vel være, at FMTI-scoren kan påvirke valget af en model frem for en anden.