Forskere fra University of Chicago har udviklet et nyt værktøj til at "forgifte" AI-modeller, når AI-virksomheder inkluderer billeder i deres datasæt uden samtykke.

Virksomheder som OpenAI og Meta har været udsat for kritik og retssager på grund af deres omfattende skrabning af onlineindhold for at træne deres modeller. Hvis tekst-til-billede-generatorer som DALL-E eller Midjourney skal være effektive, skal de trænes på store mængder visuelle data.

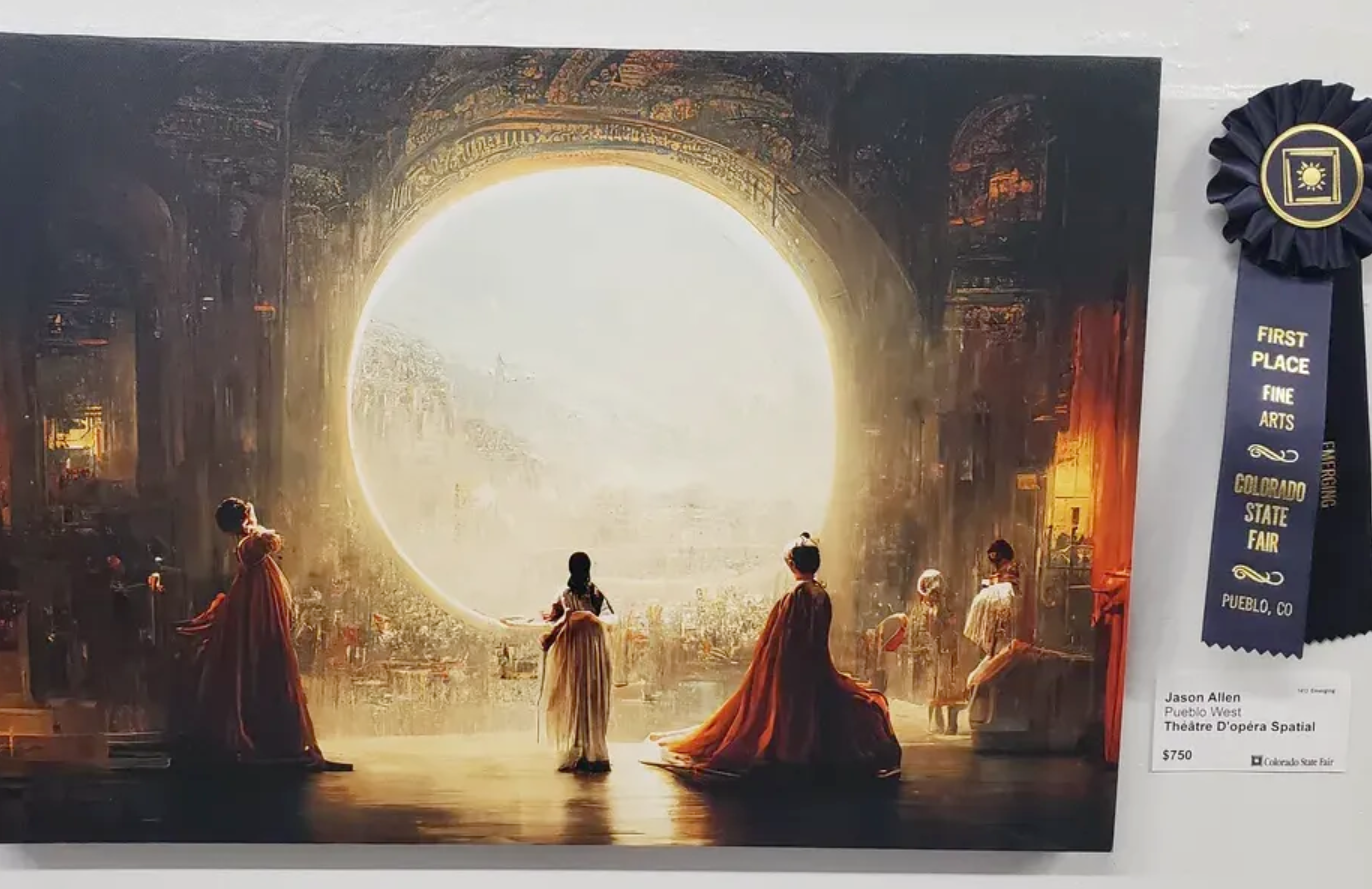

En række kunstnere har klaget over, at disse billedgeneratorer nu er i stand til at producere billeder i deres stil efter at have scrapet deres kunst uden samtykke.

Den Forskere skabte Nightshade, et værktøj, der indlejrer usynlige pixels i et billede, som efterfølgende gør billedet "giftigt" for AI-modeller.

Generativ AI er afhængig af korrekt mærkede data. Hvis en AI-model er trænet på tusindvis af billeder af katte, og alle billederne er mærket "kat", så ved den, hvordan en kat skal se ud, når du beder den om at generere et billede af en.

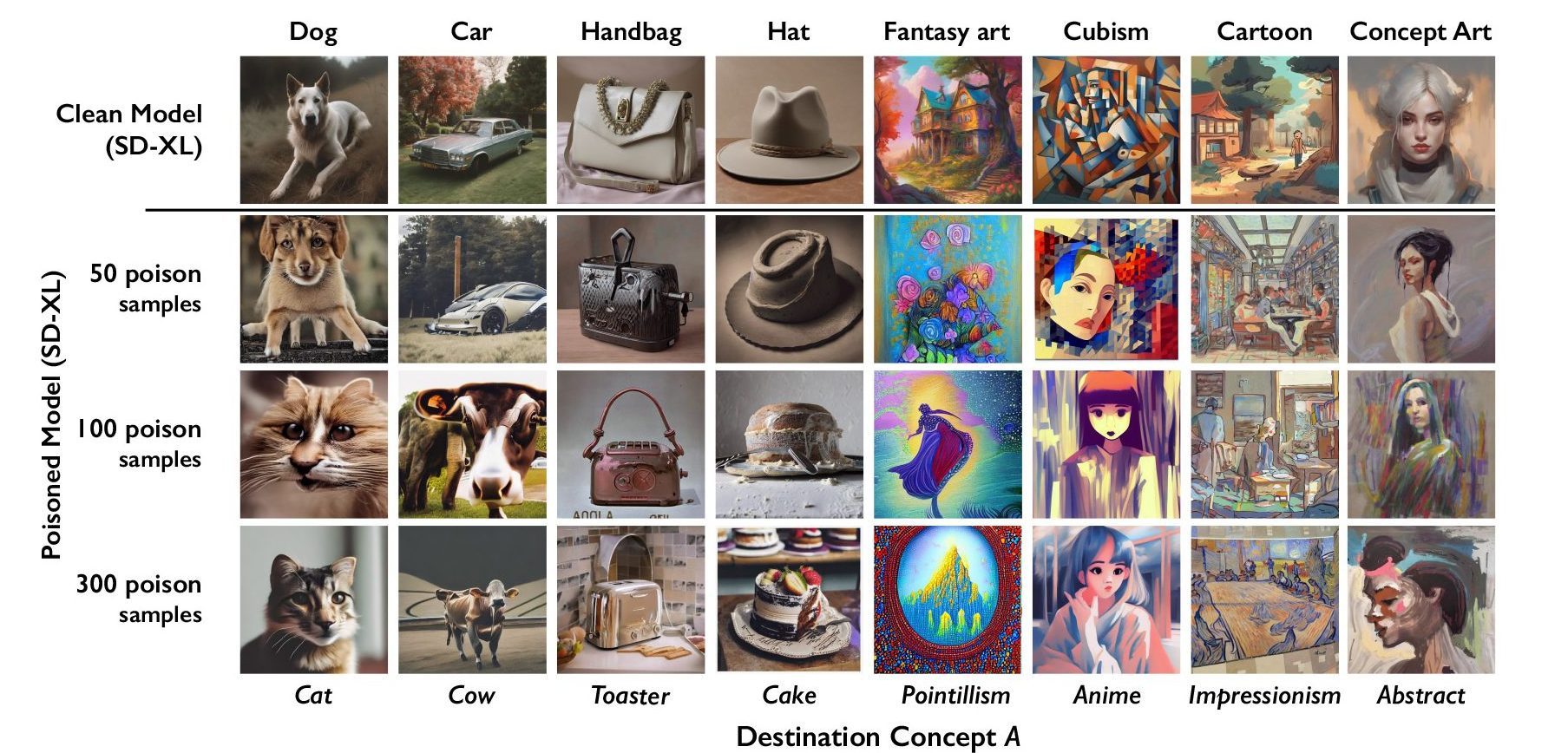

Nightshade indlejrer data i billedet, som ødelægger klassificeringen af billedet. Så et billede af et slot, der er forgiftet af Nightshade, vil f.eks. blive klassificeret som en gammel lastbil. Forskerne fandt ud af, at det var effektivt at bruge så få som 100 billeder med en enkelt ledetråd til at ødelægge en model.

Nightshade er dårligt nyt for AI-billedgeneratorer

En model, der er påvirket af forgiftede data, kan komme til at tro, at billeder af kager er hatte, eller at brødristere er håndtasker. Udover at korrumpere det specifikke ord, som Nightshade er ude efter, inficerer korruptionen også bredere begreber. Så hvis man korrumperer ordet "hund", vil korruptionen også omfatte begreber som "hvalp".

Hvis tilstrækkeligt mange kunstnere begynder at bruge Nightshade, kan det få virksomheder til at være meget mere forsigtige med at få samtykke, før de tager billeder.

Forskerteamet vil indarbejde Nightshade i Glaze-værktøjet, som de også har udviklet. Glaze forvansker stilen på et billede. For eksempel kan en kunstner, der ønsker at beskytte stilen i sit værk, bruge Glaze til at mærke det som "impressionistisk", når det i virkeligheden er "pop art".

Det faktum, at værktøjer som Nightshade fungerer så effektivt, fremhæver en Sårbarhed i tekst-til-billede-generatorer, som kan udnyttes af ondsindede aktører.

Virksomheder som OpenAI og Stability AI siger, at de vil respektere Fravalg af 'ikke scrape' som hjemmesider kan tilføje til deres robots.txt-filer. Hvis de billeder, der er forgiftet af Nightshade, ikke bliver scrapet, forbliver modellerne upåvirkede.

Men ondsindede aktører kan forgifte en stor mængde billeder og gøre dem tilgængelige for scraping med det formål at skade AI-modeller. Den eneste måde at komme uden om det på er med bedre mærkningsdetektorer eller menneskelig gennemgang.

Nightshade vil få kunstnere til at føle sig lidt mere trygge ved at lægge deres indhold på nettet, men kan skabe alvorlige problemer for AI-billedgeneratorer.