Præcis hvordan vores hjerner bearbejder og formulerer sprog er stadig et stort mysterium. Forskere ved Meta AI har fundet en ny måde at måle hjernebølger på og afkode de ord, der er forbundet med dem.

Mennesker, der har stærkt begrænsede motoriske færdigheder, som ALS-ramte, finder det særligt udfordrende at kommunikere. Det er svært at forestille sig frustrationen hos en person som Stephen Hawking, der møjsommeligt konstruerer en sætning med øjenbevægelser eller rykker i en kindmuskel.

Der er lavet en masse forskning for at afkode tale ud fra hjerneaktivitet, men de bedste resultater afhænger af invasiv hjerne-computer-implantater.

Meta AI-forskere brugte magneto-encefalografi (MEG) og elektroencefalografi (EEG) til at registrere hjernebølgerne hos 175 frivillige, mens de lyttede til korte historier og isolerede sætninger.

De brugte en forudtrænet talemodel og kontrastiv læring til at identificere, hvilke hjernebølgemønstre der var forbundet med specifikke ord, som forsøgspersonerne lyttede til.

"Afkodning af taleopfattelse fra ikke-invasive hjerneoptagelser",

ledet af den eneste ene @honualx

er netop udkommet i det seneste nummer af Nature Machine Intelligence:- papir med åben adgang: https://t.co/1jtpTezQzM

- fuld træningskode: https://t.co/Al2alBxeUC pic.twitter.com/imLxRjRQ6h- Jean-Rémi King (@JeanRemiKing) 5. oktober 2023

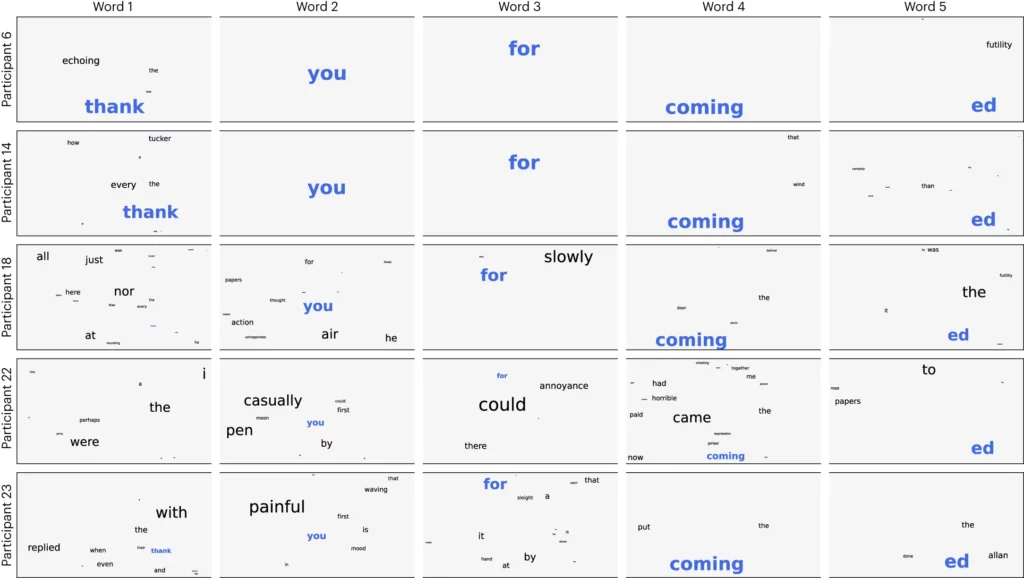

Forskerne delte lyden op i segmenter på 3 sekunder og testede derefter deres model for at se, om den kunne identificere korrekt, hvilket af de 1.500 segmenter den frivillige lyttede til. Modellen forudsagde en slags ordsky, hvor det mest sandsynlige ord blev vægtet højest.

De opnåede en nøjagtighed på 41% i gennemsnit og 95,9% nøjagtighed med deres bedste deltagere.

Forskningen viser, at det er muligt at få en ret god idé om, hvilken tale en person hører, men nu skal processen vendes om for at være brugbar. Vi er nødt til at måle deres hjernebølger og vide, hvilket ord de tænker på.

Artiklen foreslår, at man træner et neuralt netværk, mens forsøgspersoner producerer ord ved at tale eller skrive. Den generelle model kunne så bruges til at forstå hjernebølger og de tilhørende ord, som en ALS-ramt tænkte på.

Forskerne var i stand til at identificere talesegmenter fra et begrænset, forudbestemt sæt. For at kunne kommunikere ordentligt skal man kunne identificere mange flere ord. At bruge en generativ AI til at forudsige det næste mest sandsynlige ord, som en person forsøger at sige, kan hjælpe med det.

Selv om processen var ikke-invasiv, kræver den stadig, at man er tilsluttet en MEG-enhed. Desværre var resultaterne fra EEG-målingerne ikke gode.

Forskningen viser, at AI i sidste ende kan bruges til at hjælpe stemmeløse som ALS-ramte med at kommunikere. Ved at bruge en forudtrænet model undgik man også behovet for mere omhyggelig ord-for-ord-træning.

Meta AI har offentliggjort modellen og dataene, så andre forskere forhåbentlig vil bygge videre på deres arbejde.