Mens snakken går om risikoen ved AI-systemer, kan vi ikke overse den belastning, teknologien lægger på verdens allerede belastede energi- og vandforsyning.

Komplekse maskinlæringsprojekter (ML) er afhængige af en konstellation af teknologier, herunder træningshardware (GPU'er) og hardware til hosting og implementering af AI-modeller.

Mens effektive AI-træningsteknikker og -arkitekturer lover at reducere energiforbruget, er AI-boomet først lige begyndt, og big tech øger investeringerne i ressourcekrævende datacentre og cloud-teknologi.

I takt med at klimakrisen bliver dybere, er det mere afgørende end nogensinde at finde en balance mellem teknologiske fremskridt og energieffektivitet.

Energiudfordringer for AI

AI's energiforbrug er steget med fremkomsten af komplekse, beregningsmæssigt dyre arkitekturer som f.eks. neurale netværk.

For eksempel rygtes det, at GPT-4 er baseret på 8 modeller med 220 milliarder parametre hver, i alt ca. 1,76 billioner parametre. Inflection er i øjeblikket ved at opbygge en klynge af 22.000 avancerede Nvidia-chipssom kan koste omkring $550.000.000 til en vejledende udsalgspris på $25.000 pr. kort. Og det er kun for chipsene.

Hver avanceret AI-model kræver enorme ressourcer at træne, men det har været en udfordring at forstå de sande omkostninger ved AI-udvikling helt præcist indtil for nylig.

A 2019 undersøgelse fra University of Massachusetts at Amherst undersøgte ressourceforbruget i forbindelse med Deep Neural Networks (DNN).

Disse DNN'er kræver typisk, at dataforskere manuelt designer eller bruger Neural Architecture Search (NAS) til at finde og træne et specialiseret neuralt netværk fra bunden til hvert enkelt tilfælde.

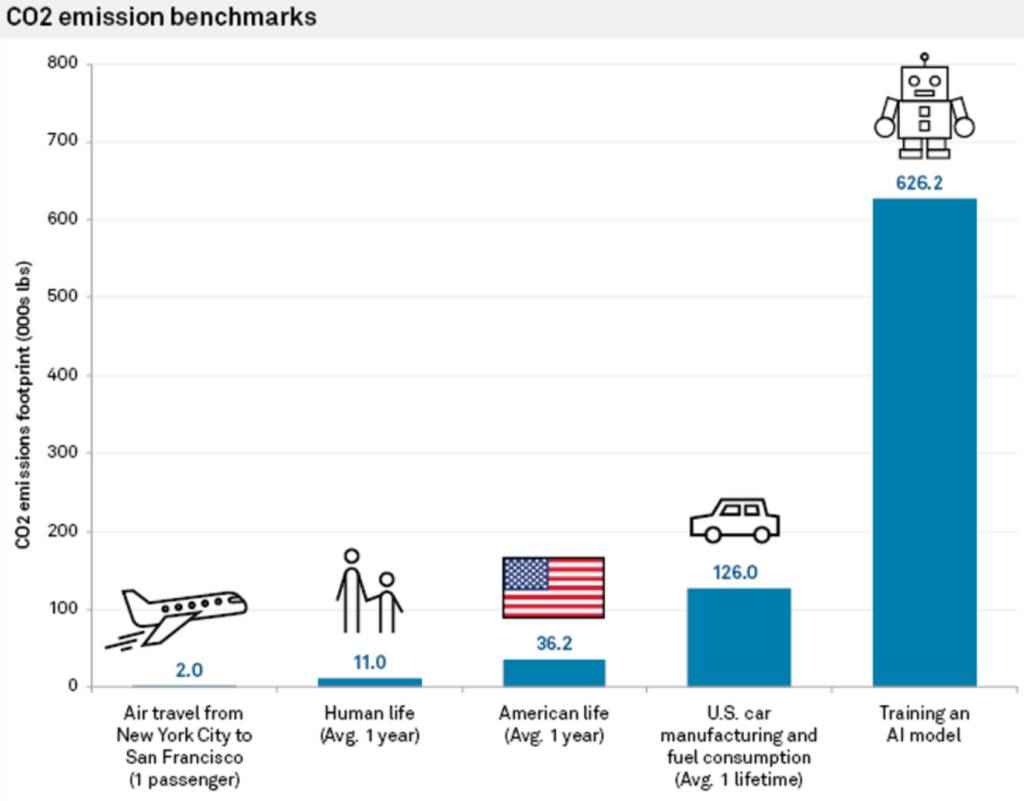

Denne tilgang er ikke kun ressourcekrævende, men har også et betydeligt CO2-fodaftryk. Undersøgelsen viste, at træning af et enkelt stort Transformer-baseret neuralt netværk, bygget ved hjælp af NAS - et værktøj, der ofte anvendes i maskinoversættelse - genererede omkring 626.000 pund kuldioxid.

Det svarer omtrent til gasudledningen fra 5 biler i hele deres levetid.

Carlos Gómez-Rodríguez, der er datalog ved universitetet i A Coruña i Spanien, kommenterede undersøgelsen: "Selv om mange af os nok har tænkt på dette på et abstrakt, vagt niveau, viser tallene virkelig problemets omfang," og han tilføjede: "Hverken jeg eller andre forskere, jeg har diskuteret dem med, troede, at miljøpåvirkningen var så stor."

Energiomkostningerne til træning af modellen er kun baseline - den mindste mængde arbejde, der kræves for at få en model til at fungere.

Som Emma Strubell, ph.d.-kandidat ved University of Massachusetts, siger: "At træne en enkelt model er den mindste mængde arbejde, man kan gøre."

MIT's 'en gang for alle'-tilgang

Forskere på MIT foreslog senere en løsning på dette problem: den 'En gang for alle'-tilgang (OFA).

Forskerne Beskriv problemet med konventionel træning af neurale netværk: "At designe specialiserede DNN'er til hvert scenarie er ingeniørmæssigt og beregningsmæssigt dyrt, enten med menneskebaserede metoder eller NAS. Da sådanne metoder er nødt til at gentage netværksdesignprocessen og genoptræne det designede netværk fra bunden for hvert tilfælde, vokser deres samlede omkostninger lineært, når antallet af implementeringsscenarier stiger, hvilket vil resultere i et for stort energiforbrug og CO2-udledning."

Med MIT's OFA-paradigme træner forskere et enkelt neuralt netværk til generelle formål, hvorfra der kan oprettes forskellige specialiserede undernetværk. OFA-processen kræver ikke yderligere træning af nye undernetværk, hvilket reducerer de energikrævende GPU-timer, der skal bruges til modeltræning, og sænker CO2-udledningen.

Ud over de miljømæssige fordele giver OFA-metoden betydelige forbedringer af ydeevnen. I interne tests klarede modeller skabt med OFA-metoden sig op til 2,6 gange hurtigere på edge-enheder (kompakte IoT-enheder) end modeller skabt med NAS.

MIT's OFA-tilgang blev anerkendt ved den 4. Low Power Computer Vision Challenge i 2019 - en årlig begivenhed arrangeret af IEEE, der fremmer forskning i forbedring af energieffektiviteten i computersynssystemer (CV).

MIT-holdet fik den højeste udmærkelse, og arrangørerne roste det: "Disse holds løsninger overgår de bedste løsninger i litteraturen."

Den 2023 Low Power Computer Vision Challenge modtager i øjeblikket bidrag frem til den 4. august.

Cloud computing's rolle i AI's miljøpåvirkning

Ud over at træne modeller har udviklere brug for enorme cloud-ressourcer til at hoste og implementere deres modeller.

Store teknologivirksomheder som Microsoft og Google øger investeringerne i cloud-ressourcer i løbet af 2023 for at kunne håndtere de stigende krav fra AI-relaterede produkter.

Cloud computing og de tilhørende datacentre har et enormt ressourcebehov. Fra og med 2016, foreslåede skøn at datacentre på verdensplan stod for omkring 1% til 3% af det globale elforbrug, hvilket svarer til energiforbruget i visse små nationer.

Datacentrenes vandfodaftryk er også kolossalt. Store datacentre kan forbruge millioner af liter vand dagligt.

I 2020 blev det rapporteret, at Googles datacentre i South Carolina fik lov til at bruge 549 millioner liter vandnæsten dobbelt så meget som to år tidligere. Et datacenter på 15 megawatt kan forbruge op til 360.000 liter vand dagligt.

I 2022, Google afslørede at deres globale datacenterflåde brugte omkring 4,3 milliarder liter vand. De fremhæver dog, at vandkøling er væsentligt mere effektivt end andre teknikker.

Store teknologivirksomheder har alle lignende planer for at reducere deres ressourceforbrug, som f.eks. Google, der nåede deres mål om at matche 100% af deres energiforbrug med indkøb af vedvarende energi i 2017.

Næste generations AI-hardware modelleret efter den menneskelige hjerne

AI er enormt ressourcekrævende, men vores hjerner kører på blot 12 watt effekt - Kan en sådan strømeffektivitet genskabes i AI-teknologi?

Selv en stationær computer bruger over 10 gange mere strøm end den menneskelige hjerne, og kraftige AI-modeller kræver millioner af gange mere strøm. At opbygge AI-teknologi, der kan kopiere biologiske systemers effektivitet, vil ændre branchen fuldstændigt.

For at være fair over for AI tager denne sammenligning ikke højde for, at den menneskelige hjerne er blevet "trænet" gennem millioner af års evolution. Desuden udmærker AI-systemer og biologiske hjerner sig ved forskellige opgaver.

Alligevel vil opbygning af AI-hardware, der kan behandle information med samme energiforbrug som biologiske hjerner, muliggøre autonome biologisk inspirerede AI'er, der ikke er koblet til store strømkilder.

I 2022 blev et hold forskere fra Indian Institute of Technology, Bombay, annoncerede udviklingen af en ny AI-chip modelleret efter den menneskelige hjerne. Chippen arbejder med spiking neural networks (SNN), som efterligner den neurale signalbehandling i biologiske hjerner.

Hjernen består af 100 milliarder små neuroner, der er forbundet med tusindvis af andre neuroner via synapser og overfører information gennem koordinerede mønstre af elektriske spikes. Forskerne byggede kunstige neuroner med ultralav energi og udstyrede SNN'erne med bånd-til-bånd-tunnelstrøm (BTBT).

"Med BTBT oplader kvantetunnelstrømmen kondensatoren med ultralav strøm, hvilket betyder, at der kræves mindre energi," forklarer Udayan Ganguly fra forskerholdet.

Ifølge professor Ganguly opnår deres tilgang "5.000 gange lavere energi pr. spike på et lignende område og 10 gange lavere standby-strøm på et lignende område og energi pr. spike" sammenlignet med eksisterende state-of-the-art-neuroner, der er implementeret i hardware-SNN'er.

Forskerne demonstrerede med succes deres tilgang i en talegenkendelsesmodel inspireret af hjernens auditive cortex. SNN'er kan forbedre applikationer på kompakte enheder som mobiltelefoner og IoT-sensorer.

Teamets mål er at udvikle en "ekstremt energibesparende neurosynaptisk kerne og en on-chip-læringsmekanisme i realtid, som er nøglen til autonome biologisk inspirerede neurale netværk."

AI's miljøpåvirkning bliver ofte overset, men hvis man løser problemer som strømforbrug for AI-chips, vil det også åbne op for nye innovationsmuligheder.

Hvis forskere kan modellere AI-teknologi på biologiske systemer, som er usædvanligt energieffektive, vil det gøre det muligt at udvikle autonome AI-systemer, som ikke er afhængige af rigelig strømforsyning og tilslutning til datacentre.