Data er livsnerven i AI, men det er ikke en uendelig ressource. Kan menneskeheden løbe tør for data? Hvad sker der, hvis vi gør?

Komplekse AI-modeller kræver store mængder træningsdata. For eksempel kræver træning af en stor sprogmodel (LLM) som ChatGPT cirka 10 billioner ord.

Nogle eksperter mener, at udbuddet af data af høj kvalitet er faldende. For eksempel viste en undersøgelse fra 2022 fra forskere på flere universiteter Udtalt, "Vores analyse viser, at mængden af sprogdata af høj kvalitet snart vil være opbrugt; sandsynligvis inden 2026... Vores arbejde tyder på, at den nuværende tendens med stadigt voksende ML-modeller, der er afhængige af enorme datasæt, kan aftage, hvis dataeffektiviteten ikke forbedres drastisk, eller nye datakilder bliver tilgængelige."

Generering af syntetiske data er en løsning, men den kan generelt ikke indfange dybden, nuancerne og variationen i rigtige data.

For yderligere at komplicere situationen er der bekymring for, hvad der sker, når AI begynder at forbruge sin egen produktion, hvilket forskere ved École Polytechnique Fédérale de Lausanne (EPFL) i Schweiz mener er Det sker allerede.

Deres forskning viser, at AI-virksomheder, der køber menneskeproducerede data via platforme som Amazon Mechanical Turk, kan modtage AI-genererede data i stedet.

Hvad sker der, når AI begynder at spise sit eget output? Kan det undgås?

Det er dyrt og tidskrævende at opbygge datasæt - og der står meget på spil

Data er allestedsnærværende, men det er en kompleks proces at operationalisere dem til AI. Kvaliteten af data og etiketter påvirker modellens ydeevne - det er et tilfælde af "skrald ind, skrald ud".

For kort at beskrive processen med at opbygge datasæt tager dataanmeldere (eller mærkere) behandlede data (f.eks. et beskåret billede) og mærker dem. funktioner (f.eks. en bil, en person, en fugl).

Det giver algoritmerne et "mål" at lære af. Algoritmerne udtrækker og analyserer funktioner fra mærkede data for at forudsige disse funktioner i nye, usete data.

Det er nødvendigt for overvåget maskinlæring, som er en af kerneområderne inden for maskinlæring sammen med ikke-overvåget maskinlæring og forstærkningslæring. Ved at nogle skønI dag optager dataforberedelsen og mærkningsprocessen 80% af et maskinlæringsmodels projekts varighed, men hvis man skærer for mange hjørner, risikerer man at gå på kompromis med en models ydeevne.

Ud over de praktiske udfordringer med at skabe datasæt af høj kvalitet ændrer selve datas natur sig konstant. Det, man ville definere som et "datasæt, der indeholder et typisk udvalg af køretøjer på vejene" for 10 år siden, er ikke det samme i dag. Nu finder man f.eks. et meget større antal el-scootere og el-cykler på vejene.

Disse kaldes "edge cases", som er sjældne objekter eller fænomener, der ikke findes i datasæt.

Modeller afspejler kvaliteten af deres datasæt

Hvis du træner et moderne AI-system på et gammelt datasæt, risikerer modellen at få en lav ydeevne, når den udsættes for nye, usete data.

Mellem 2015 og 2020 afslørede forskere store strukturelle skævheder i AI-algoritmer, som til dels blev tilskrevet træning af modeller på gamle og skæve data.

For eksempel kan Mærkede ansigter i det vilde hjem (LFW)et datasæt med kendte ansigter, der ofte bruges i ansigtsgenkendelsesopgaver, består af 77,5% mænd og 83,5% hvidhudede individer. En AI har intet håb om at fungere ordentligt, hvis dataene ikke repræsenterer alle, den har til hensigt at tjene. Fejlprocenterne for ansigtsgenkendelse blandt de bedste algoritmer viste sig at være så lave som 0,8% for hvide mænd og så høje som 34,7% for mørkhudede kvinder.

Denne forskning kulminerede i den skelsættende Undersøgelse af kønsnuancer og en dokumentarfilm ved navn Kodet biassom undersøgte, hvordan AI sandsynligvis lærer af fejlbehæftede og ikke-repræsentative data.

Konsekvenserne af dette er langt fra gode - det har ført til forkerte retsresultater, falske fængslinger, og kvinder og andre grupper er blevet nægtet job og kredit.

AI har brug for flere data af høj kvalitet, som skal være retfærdige og repræsentative - Det er en svær kombination.

Er syntetiske data svaret?

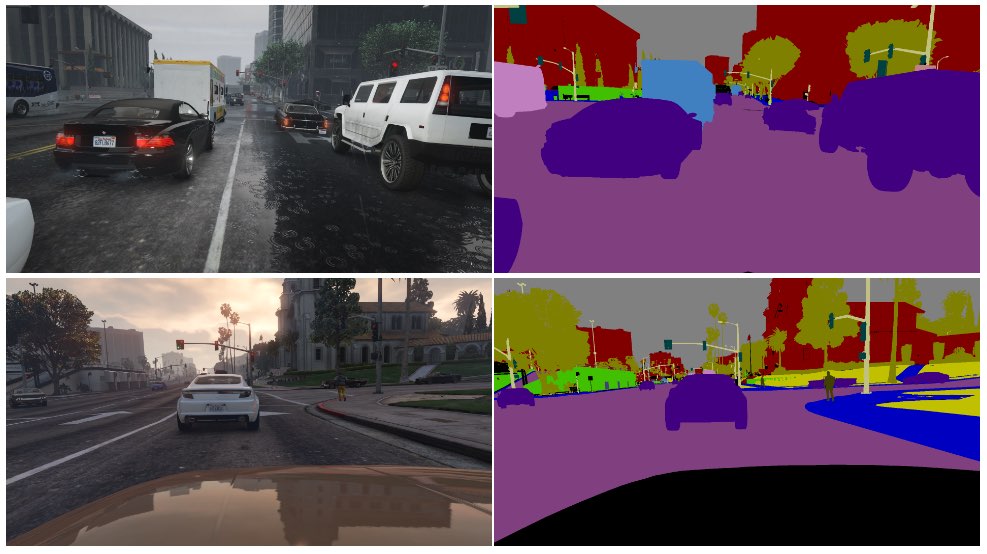

Syntetiske data bruges ofte i computer vision (CV), hvor AI'er identificerer objekter og funktioner fra billeder og video.

I stedet for at indsamle billeddata fra den virkelige verden - som f.eks. at fotografere eller filme en gade - hvilket er teknisk udfordrende og giver problemer med privatlivets fred - genererer man simpelthen dataene i et virtuelt miljø.

Selv om dette supplerer AI'er med flere data, er der flere ulemper:

- Det er ikke ligetil at modellere virkelige scenarier i et virtuelt miljø.

- Det er stadig dyrt og tidskrævende at generere store mængder syntetiske data.

- Kanttilfælde og afvigelser er stadig et problem.

- Det kan ikke være en perfekt kopi af den ægte vare.

- På den anden side kan nogle aspekter være for perfekte, og det er svært at finde ud af, hvad der mangler.

I sidste ende er syntetiske data fremragende til hurtigt virtualiserede miljøer, som f.eks. et fabriksgulv, men de er ikke altid tilstrækkelige til virkelige miljøer i hurtig bevægelse, som f.eks. en gade i en by.

Hvad med at generere syntetiske tekstdata?

Tekst er enklere end billed- eller videodata, så kan modeller som ChatGPT bruges til at generere næsten uendelige syntetiske træningsdata?

Ja, men det er risikabelt, og konsekvenserne er ikke nemme at forudsige. Mens syntetiske tekstdata kan hjælpe med at tune, teste og optimere modeller, er de ikke ideelle til at lære modellerne ny viden og kan forstærke bias og andre problemer.

Her er en analogi til, hvorfor det er problematisk at træne AI'er med AI-genererede data:

- Tænk på en skole, der bruger alle verdens bedste lærebøger til at uddanne sine elever med alt, hvad der er at vide fra sine ressourcer i løbet af en dag.

- Derefter begynder skolen at producere sit eget arbejde baseret på denne viden - svarende til en chatbots output. Eleverne har lært af alle de data, der er tilgængelige på den dato, hvor undervisningen begynder, men de kan ikke effektivt inddrage nye data i videnssystemet bagefter.

- Viden skabes dagligt - mens langt størstedelen af den menneskelige viden blev skabt før en bestemt dag, udvikler og forandrer viden sig over tid. Det er afgørende, at mennesker ikke bare skaber ny viden hele tiden - vi ændrer også vores perspektiv på eksisterende viden.

- Antag nu, at skolen, der er løbet tør for data, begynder at undervise sine elever ved hjælp af sit eget output. Eleverne begynder at "spise" deres indhold for at producere nyt indhold.

- På det tidspunkt kan de studerendes output ikke tilpasses den virkelige verden, og dets anvendelighed falder. Systemet kaster sit eget arbejde op igen. Arbejdet kan tilpasse sig og udvikle sig, men det sker isoleret fra alt uden for denne feedback-loop.

AI konfronterer konstant mennesker med gåder, der skal løses, og Denne har en masse kommentatorer på Reddit og den Y Combinator-forum Forvirret.

Det er tankevækkende, og der er ikke rigtig enighed om konsekvenserne.

Menneskelige datamærkere bruger ofte AI til at producere data

Der er endnu et uforudset lag i problemet med at producere træningsdata af høj kvalitet.

Crowdworking-platforme som Amazon Mechanical Turk (MTurk) bruges jævnligt af AI-virksomheder, der ønsker at producere ægte 'menneskelige' datasæt. TDer er bekymring for, at dataanmeldere på disse platforme bruger AI til at udføre deres opgaver.

Forskere ved École Polytechnique Fédérale de Lausanne (EPFL) i Schweiz analyserede data fra MTurk for at undersøge, om medarbejderne brugte AI til at generere deres indsendelser.

Undersøgelsensom blev offentliggjort den 13. juni, fik 44 MTurk-deltagere til at opsummere abstracts fra 16 medicinske forskningsartikler. Det viste sig, at 33% til 46% af brugerne på platformen genererede deres indlæg med AI, på trods af at de blev bedt om at svare med naturligt sprog.

"Vi udviklede en meget specifik metode, som fungerede rigtig godt til at opdage syntetisk tekst i vores scenarie", siger Manoel Ribeiro, medforfatter til undersøgelsen og ph.d.-studerende ved EPFL, fortalte The Register i denne uge.

Selv om undersøgelsens datasæt og stikprøvestørrelse er ret lille, er det langt fra utænkeligt at tro, at AI'er bliver trænet uforvarende på AI-genereret indhold.

Undersøgelsen handler ikke om at give MTurk-medarbejdere skylden - forskerne bemærker, at lave lønninger og ensidigt gentaget arbejde bidrager til problemet. AI-virksomheder vil have menneskeskabte data af højeste kvalitet og samtidig holde omkostningerne nede. En kommentator sagde på Reddit: "Jeg er i øjeblikket en af disse arbejdere, der har til opgave at træne Bard. Jeg bruger helt sikkert ChatGPT til det. 20$/time er ikke nok for den forfærdelige behandling, vi får, så jeg vil presse hver en øre ud af dette ******* job."

Kaninhullet bliver endnu dybere, da AI'er ofte trænes på data, der er skrabet fra internettet. Efterhånden som der udgives mere AI-skrevet indhold online, vil AI uundgåeligt lære af sine egne resultater.

Når mennesker begynder at være afhængige af kunstig intelligens for at få information, bliver kvaliteten af deres output stadig mere kritisk. Vi er nødt til at finde innovative metoder til at opdatere AI'er med friske, autentiske data.

Som Ribeiro udtrykker det: "Menneskelige data er guldstandarden, for det er mennesker, vi interesserer os for, ikke store sprogmodeller."

Arbejdet med at analysere den potentielle effekt af AI, der bruger sine egne resultater, er i gang, men autentiske menneskelige data er fortsat afgørende for en lang række maskinlæringsopgaver.

At generere store mængder data til sultne AI'er og samtidig navigere i risici er et igangværende arbejde.