Den eksponentielle vækst i AI-systemer overhaler forskning og regulering og efterlader regeringerne i en vanskelig position, hvor de skal afveje fordele og risici.

Det tager år at udvikle love og gøre dem juridisk bindende. AI udvikler sig på ugentlig basis.

Det er den dikotomi, som AI-ledere og -politikere står over for, og den første meningsfulde AI-regulering i Vesten, EU's AI Act, kommer i 2026. Selv for et år siden var ChatGPT kun en hvisken.

Topembedsmænd fra USA og EU mødtes til US-EU Trade and Tech Council (TTC) den 31. maj i Luleå, Sverige. Margrethe Vestager, Europas digitale kommissær, som mødtes med Googles CEO Sundar Pichai ugen før for at diskutere en potentiel 'AI-pagt', sagde: "Demokratiet er nødt til at vise, at vi er lige så hurtige som teknologien."

Embedsmænd anerkender den gabende kløft mellem teknologiens tempo og lovgivningens tempo. Med henvisning til generativ AI som ChatGPT sagde Gina Raimondo, USA's handelsminister: "Det kommer i et tempo som ingen anden teknologi."

Så hvad opnåede TTC-mødet?

Vandmærkning, eksterne audits, feedback-loops - bare nogle af de ideer, der blev diskuteret med @AnthropicAI og @sama @OpenAI for #AI #Code of Conduct lanceret i dag på #TTC i #Luleå @SecRaimondo Vi ser frem til at diskutere med internationale partnere. pic.twitter.com/wV08KDNs3h

- Margrethe Vestager (@vestager) 31. maj 2023

Deltagerne diskuterede først og fremmest ikke-bindende eller frivillige rammer omkring risiko og gennemsigtighed, som vil blive præsenteret for G7 til efteråret.

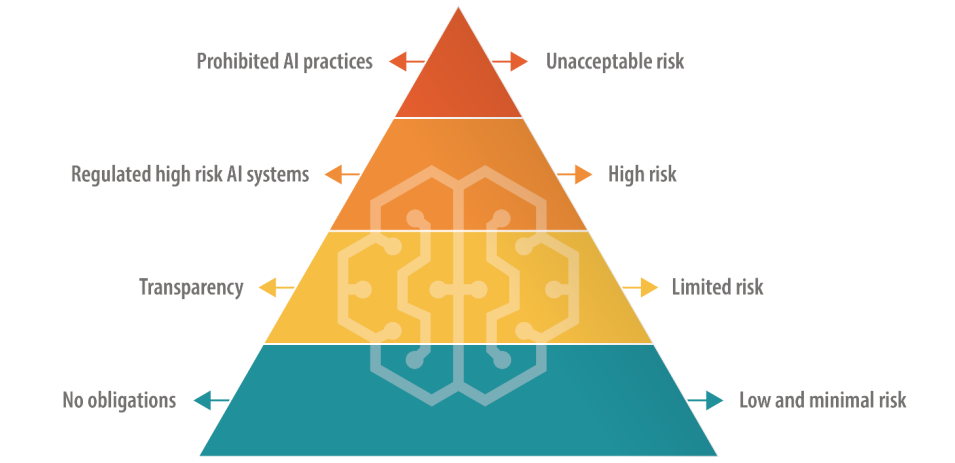

EU, som har en direkte tilgang til digital lovgivning, vælger en differentieret tilgang til AI-regulering, hvor AI'er sorteres i kategorier baseret på risiko.

Det omfatter et forbudt "uacceptabel risiko"-niveau og et "højrisiko"-niveau, som teknologibosser som OpenAI's CEO Sam Altman frygter vil kompromittere deres produkters funktionalitet.

USA foreslår ikke så definitive regler, at foretrække frivillige regler.

Der er brug for mange flere møder mellem EU, USA og big tech for at afstemme synspunkter med meningsfuld praktisk handling.

Vil frivillige AI-regler fungere?

Der er mange eksempler på frivillige regler i andre sektorer og brancher, såsom frivillige rammer for datasikkerhed og ESG-oplysninger, men ingen er så tæt på forkant som en frivillig ramme for AI-styring.

Vi har trods alt at gøre med en trussel på udryddelsesniveau her, ifølge topteknologiledere og akademikere, der er medunderskrivere af rapporten Center for AI Safety's udtalelse om AI-risiko i denne uge.

Store virksomheder som OpenAI og Google har allerede centrale afdelinger med fokus på governance og intern compliance, så det at tilpasse deres produkter og tjenester til frivillige rammer kan være et spørgsmål om at omskrive interne policydokumenter.

Frivillige regler er bedre end ingenting, men med mange forslag på bordet bliver politikere og AI-ledere nødt til at vælge noget at køre videre med før eller siden.