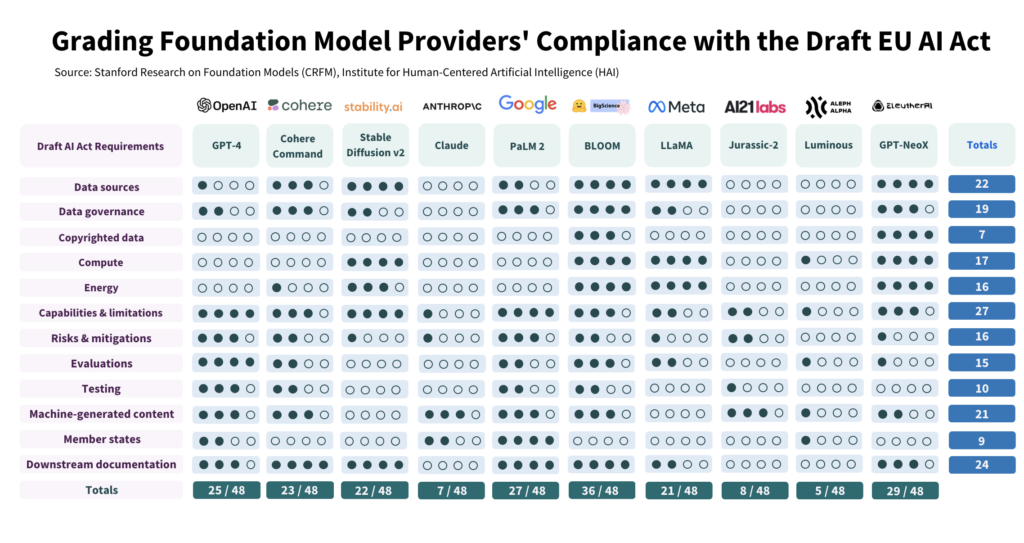

AI-forskere på Stanford evaluerede 10 førende AI-modellers overensstemmelse med den foreslåede EU AI Act og fandt stor variation med generelt dårlige resultater over hele linjen.

Undersøgelsen kritisk undersøgt 10 AI-modeller i forhold til 12 kriterier i EU's udkast til lovgivning og afdækket stor variation i overholdelse, hvor ingen model krydsede alle felter.

Undersøgelsen fremhæver kløften mellem AI-lovens forventninger og den nuværende styringsindsats blandt førende AI-udviklere.

For at overholde loven skal bygherrer i høj grad forbedre deres gennemsigtighed og risikobegrænsende strategier, som i nogle tilfælde næsten helt mangler.

Hvordan undersøgelsen blev gennemført

Forfatterne gennemførte en detaljeret undersøgelse af AI-loven og udledte 22 krav.

Ud af dem valgte de 12, som kunne evalueres meningsfuldt ved hjælp af offentlig information. Derefter skabte de en 5-punkts rubrik for hvert af disse 12 krav.

Open source AI-modellen BLOOM, produceret af Hugging Face, blev den højest scorende model med i alt 36 ud af 48 mulige point.

Omvendt klarede Google-støttede Anthropic og det tyske AI-firma Aleph Alpha sig betydeligt dårligere med henholdsvis 7 og 5 point. ChatGPT lå midt i feltet med 25/48.

De fire vigtigste områder for manglende overholdelse er ophavsretligt beskyttede data, energi, risikominimering og evaluering/test.

En af forfatterne, Kevin Klyman, der er forsker ved Stanfords Center for Research on Foundation Models, bemærkede, at de fleste udviklere ikke oplyser om deres risikobegrænsende strategier, hvilket kan være en dealbreaker. Klyman sagde: "Udbyderne oplyser ofte ikke om effektiviteten af deres risikobegrænsende foranstaltninger, hvilket betyder, at vi ikke kan sige, hvor risikable nogle fondsmodeller er."

Desuden er der stor variation i de træningsdata, der bruges til at træne modeller. EU vil kræve, at AI-udviklere skal være mere gennemsigtige med deres datakilder, hvilket 4/10 af udviklerne ikke gør. ChatGPT scorede kun 1 point på det område.

Open source versus proprietære modeller

Rapporten opdagede også en klar opdeling i overholdelse, afhængigt af om en model var open source eller proprietær.

Open source-modeller opnåede gode resultater med hensyn til offentliggørelse af ressourcer og datakrav, men deres risici er stort set udokumenterede.

Proprietære modeller er det modsatte - de er gennemtestede og veldokumenterede med robuste risikobegrænsningsstrategier, men er uigennemsigtige med hensyn til data og teknologirelaterede målinger.

Eller for at sætte det på spidsen: Open source-udviklere har ikke så mange konkurrencemæssige hemmeligheder at beskytte, men deres produkter er i sagens natur mere risikable, da de kan bruges og ændres af næsten alle.

Omvendt vil private udviklere sandsynligvis holde aspekter af deres modeller under lås og slå, men de kan demonstrere sikkerhed og risikominimering. Selv Microsoft, OpenAI's primære investor, har ikke helt forstå, hvordan OpenAI's modeller fungerer.

Hvad anbefaler undersøgelsen?

Undersøgelsens forfattere anerkender, at kløften mellem EU's forventninger og virkeligheden er alarmerende, og fremsætter flere anbefalinger til politikere og modeludviklere.

Undersøgelsen anbefaler EU's politiske beslutningstagere:

- Præcisere og specificere parametrene for EU's AI Act: Forskerne hævder, at AI-lovens tekniske sprog og parametre er underspecificerede.

- Fremme gennemsigtighed og ansvarlighed: Forskere argumenterer for, at de strengeste regler bør være ultra-målrettede mod de allerstørste og mest dominerende udviklere, hvilket bør føre til en mere effektiv håndhævelse.

- Sørg for tilstrækkelige ressourcer til håndhævelse: For at EU's AI Act kan håndhæves effektivt, skal der stilles tekniske ressourcer og talent til rådighed for håndhævelsesorganer.

Undersøgelsen anbefaler globale politiske beslutningstagere:

- Prioritér gennemsigtighed: Forskerne fremhæver, at gennemsigtighed er afgørende og bør være hovedfokus for den politiske indsats. De hævder, at erfaringerne fra reguleringen af sociale medier viser de skadelige konsekvenser af mangelfuld gennemsigtighed, som ikke bør gentages i forbindelse med kunstig intelligens.

- Afklare spørgsmål om ophavsret: Grænserne for ophavsret til AI-træningsdata og AI-output er meget omdiskuterede. I betragtning af den lave overholdelse, der er observeret i forbindelse med offentliggørelse af ophavsretligt beskyttede træningsdata, hævder forskerne, at juridiske retningslinjer skal specificere, hvordan ophavsret interagerer med træningsprocedurer og output fra generative modeller. Dette omfatter en definition af de vilkår, hvorunder ophavsret eller licenser skal respekteres under træningen, og en bestemmelse af, hvordan maskingenereret indhold kan krænke ophavsretten.

Undersøgelsen anbefaler udviklere af fondsmodeller:

- Stræb efter løbende forbedringer: Udbydere bør konsekvent sigte mod at forbedre deres compliance. Større udbydere som OpenAI bør gå foran med et godt eksempel og formidle ressourcer til downstream-kunder, der får adgang til deres modeller via API.

- Vær fortaler for industristandarder: Modeludbydere bør bidrage til at etablere industristandarder, som kan føre til et mere gennemsigtigt og ansvarligt AI-økosystem.

Selv om der er nogle positive ting at hente i de risiko- og overvågningsstandarder, der er etableret af førende udviklere som OpenAI, er manglerne på områder som ophavsret langt fra ideelle.

Med hensyn til at anvende regulering på AI som en altomfattende kategori - Det kan vise sig at være meget vanskeligt. - da kommercielle og open source-modeller er strukturelt forskellige og svære at skære over én kam.