Advokaten Steven A Schwartz fra New York brugte ChatGPT til at undersøge flere 'sager', som viste sig at være falske.

Schwartz' sag handlede om en mand, der sagsøgte det colombianske flyselskab Avianca. Sagsøgeren arbejdede sammen med et juridisk team, Levidow, Levidow & Oberman, som udarbejdede en juridisk redegørelse med henvisning til helt falske retssager.

Schwartz bad ChatGPT om sikkerhed for, at sagerne var ægte, men han forsøgte kun at krydstjekke en af sagerne i detaljer, og ChatGPT forsikrede ham om, at den kunne findes i Westlaw- og LexisNexis-databaserne. På det grundlag antog Schwartz, at de andre sager også var ægte.

Det blev senere afsløret, at kun ét tilfælde var ægte, Zicherman v. Korean Air Lines Co, 516 U.S. 217 (1996)og ChatGPT fejlciterede datoen og flere andre detaljer.

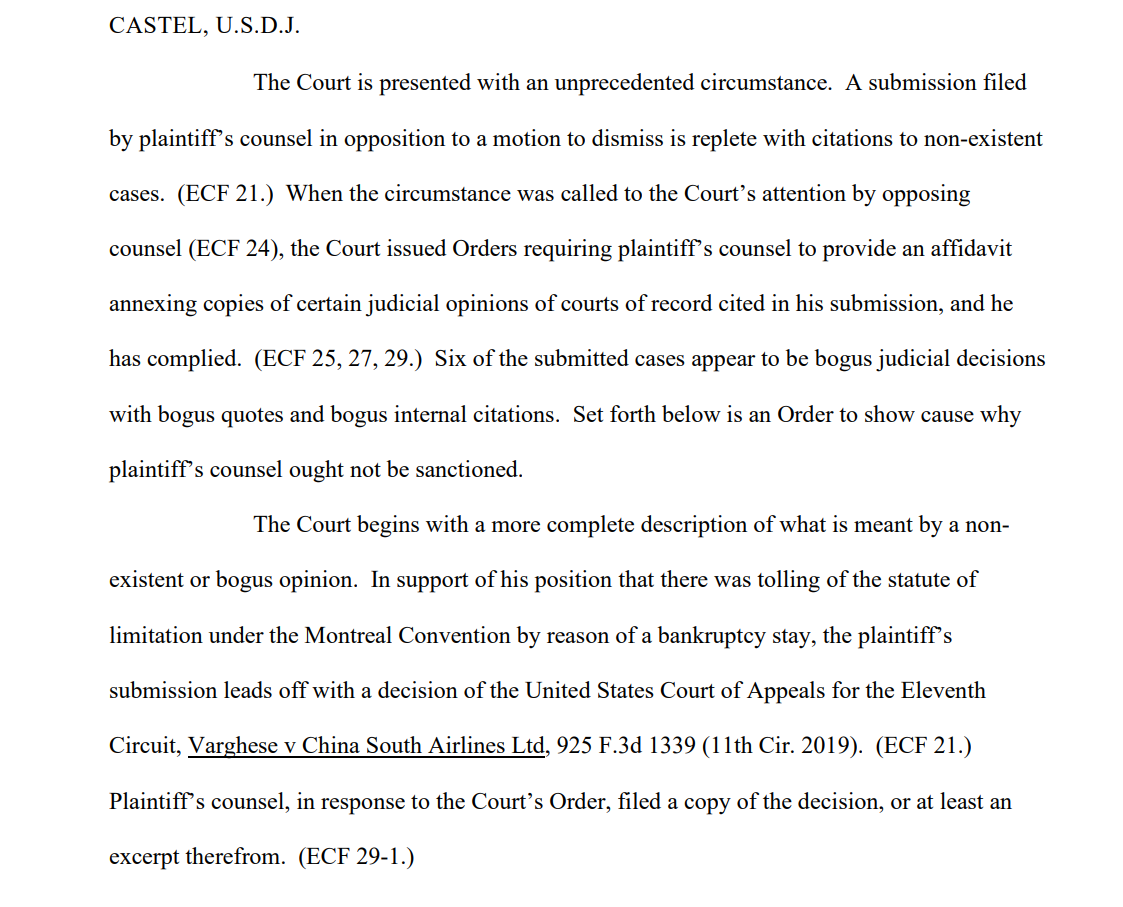

Efter at sagsøgerens team havde indsendt briefen, udtalte en af modtagerne, den amerikanske distriktsdommer Kevin Castel: "Seks af de indsendte sager ser ud til at være falske retsafgørelser med falske citater og falske interne henvisninger."

En af de retslister siger"Retten er præsenteret for en hidtil uset omstændighed. Et indlæg indgivet af sagsøgerens advokat i opposition til en begæring om afvisning er fyldt med henvisninger til ikke-eksisterende sager."

Schwartz, der har 30 års erfaring som advokat, hævdede, at det var en uskyldig fejl, og fortalte retten, at han "beklager meget", at han brugte ChatGPT til research og var "uvidende om, at indholdet kunne være falsk". Han indrømmede også, at han havde brugt ChatGPT i andre retssager.

Schwartz, som handlede på vegne af Peter LeDocu, en kollega i samme advokatfirma, skal møde op i retten den 8. juni for at forklare, hvorfor han og hans advokatfirma ikke skal sanktioneres.

Når ChatGPT tjekker ChatGPT

OpenAI er meget klar over, at ChatGPT er sårbar over for at fordreje sandheden, men AI'en kan virke selvsikker, når den giver kontekstuelt relevante "eksempler", som ikke er faktuelt korrekte - også kaldet "hallucinationer".

Det er også et problem i den akademiske verden, hvor ChatGPT ofte genererer falske referencer og nogle gange går så langt som til at fremstille realistiske undersøgelser og eksperimenter, som aldrig har fundet sted.

Mange universiteter har udsendt erklæringer, der understreger dette. For eksempel, Duke University siger"Hvad du måske ikke ved om ChatGPT er, at det har betydelige begrænsninger som en pålidelig forskningsassistent. En af disse begrænsninger er, at den er kendt for at fabrikere eller "hallucinere" (i maskinlæringstermer) citater."

At analysere referencer for uoverensstemmelser er blevet en pålidelig måde for undervisere at fange studerende, der bruger ChatGPT til at skrive essays.

Det var præcis, hvad der skete med Schwartz - han blev fanget. Han var ikke den første, og han bliver ikke den sidste. Han virkede oprigtigt uvidende, men uvidenhed er ikke nødvendigvis et forsvar i retten.

At generere falske juridiske citater er et alarmerende eksempel på ChatGPT's fejlbarlighed og tjener som en kraftig påmindelse om at tjekke, dobbelttjekke og tredobbelttjekke 'fakta', som generative AI'er udråber.