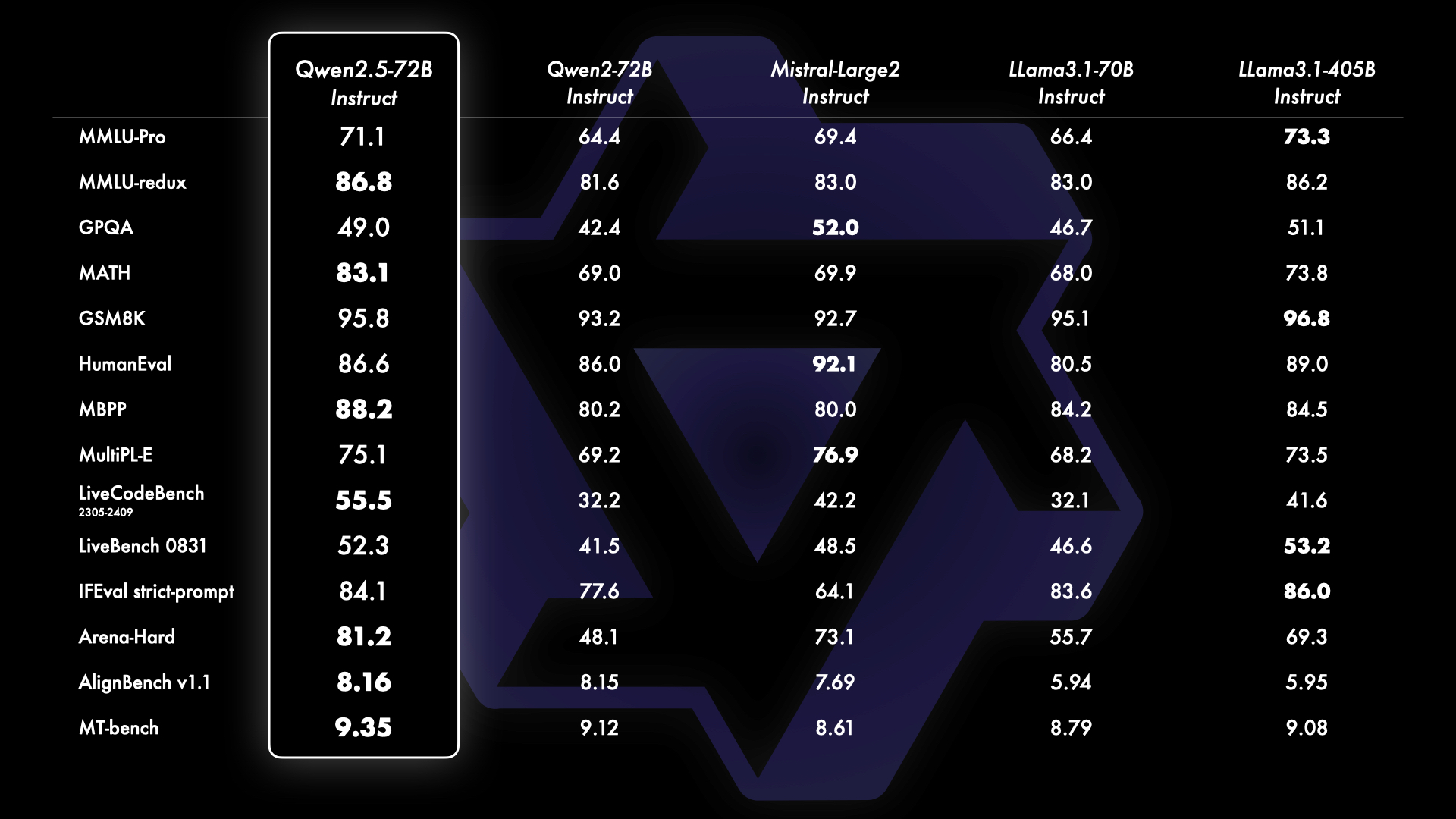

Alibaba släppte mer än 100 AI-modeller med öppen källkod, inklusive Qwen 2.5 72B som slår andra modeller med öppen källkod i matematik- och kodningsbenchmarks.

Mycket av AI-industrins uppmärksamhet i modeller med öppen källkod har varit på Metas ansträngningar med Llama 3, men Alibabas Qwen 2.5 har minskat klyftan avsevärt. Den nyligen släppta Qwen 2.5-familjen av modeller varierar i storlek från 0,5 till 72 miljarder parametrar med generaliserade basmodeller såväl som modeller fokuserade på mycket specifika uppgifter.

Alibaba säger att dessa modeller kommer med "förbättrad kunskap och starkare kapacitet inom matematik och kodning" med specialiserade modeller som fokuserar på kodning, matematik och flera modaliteter inklusive språk, ljud och syn.

Alibaba Cloud tillkännagav också en uppgradering av sin egen flaggskeppsmodell Qwen-Max, som de inte har släppt som öppen källkod. Benchmarks för Qwen 2.5 Max ser bra ut, men det är Qwen 2.5 72B-modellen som har skapat mest spänning bland fans av öppen källkod.

Riktmärkena visar att Qwen 2.5 72B slår Metas mycket större flaggskepp Llama 3.1 405B modeller på flera fronter, särskilt inom matematik och kodning. Klyftan mellan modeller med öppen källkod och proprietära modeller som OpenAI och Google minskar också snabbt.

Tidiga användare av Qwen 2.5 72B visar att modellen ligger strax under Sonnet 3.5 och till och med slår OpenAI's o1-modeller i kodning.

Qwen 2.5 med öppen källkod slår o1-modellerna på kodning 🤯🤯

Qwen 2.5 får högre poäng än o1-modellerna när det gäller kodning på Livebench AI

Qwen ligger strax under Sonnet 3.5, och för ett öppet källkodsläge är det fantastiskt!!!

o1 är bra på lite hård kodning men hemskt på kodkompletteringsproblem och ... pic.twitter.com/iazam61eP9

- Bindu Reddy (@bindureddy) 20 september 2024

Alibaba säger att dessa nya modeller alla utbildades på sin storskaliga dataset som omfattar upp till 18 biljoner tokens. Qwen 2.5-modellerna kommer med ett kontextfönster på upp till 128k och kan generera utdata på upp till 8k tokens.

Övergången till mindre, mer kapabla och kostnadsfria modeller med öppen källkod kommer sannolikt att ha en större inverkan på många användare än mer avancerade modeller som o1. Dessa modellers kant- och enhetsfunktioner innebär att du kan få ut mycket av en gratismodell som körs på din bärbara dator.

Den mindre Qwen 2.5-modellen levererar kodning på GPT-4-nivå till en bråkdel av kostnaden, eller till och med gratis om du har en bra bärbar dator att köra den lokalt.

Vi har GPT-4 för kodning hemma! Jag kollade upp OpenAI?ref_src=twsrctfw">@OpenAI GPT-4 0613 resultat för olika benchmarks och jämförde dem med @Alibaba_Qwen 2,5 7B-kodare. 👀

> 15 månader efter lanseringen av GPT-0613 har vi en öppen LLM under Apache 2.0, som fungerar precis lika bra. 🤯

> GPT-4 prissättning... pic.twitter.com/2szw5kwTe5

- Philipp Schmid (@_philschmid) 22 september 2024

Förutom LLM:erna släppte Alibaba en betydande uppdatering av sin språkmodell för vision med introduktionen av Qwen2-VL. Qwen2-VL kan förstå videor som varar i över 20 minuter och stöder videobaserade frågor och svar.

Den är utformad för att integreras i mobiltelefoner, bilar och robotar för att möjliggöra automatisering av operationer som kräver visuell förståelse.

Alibaba presenterade också en ny text-till-video-modell som en del av sin bildgenerator, Tongyi Wanxiang stora modellfamilj. Tongyi Wanxiang AI Video kan producera videoinnehåll av filmkvalitet och 3D-animering med olika konstnärliga stilar baserat på textmeddelanden.

Demonstrationerna ser imponerande ut och verktyget är gratis att använda, även om du behöver ett kinesiskt mobilnummer för att anmäl dig till det här. Sora kommer att få allvarlig konkurrens när, eller om, OpenAI så småningom släpper det.