Tävlingen om kraftfullare och effektivare AI-hårdvara tog fart i veckan när Intel och Google tillkännagav nya chip som ska hjälpa dem att bli mindre beroende av NVIDIA-teknik.

Det verkar som om nya AI-modeller släpps varje vecka. Bakom varje lansering ligger veckor av träning i datacenter för molnbaserad databehandling, varav de flesta drivs av NVIDIA GPU:er.

Intel och Google presenterade båda nya interna AI-chip som kan träna och distribuera stora AI-modeller snabbare samtidigt som de använder mindre ström.

Intels AI-acceleratorchip Gaudi 3

Intel är förmodligen mer känt för de chip som driver din dator, men på tisdagen meddelade bolaget meddelade sitt nya AI-chip kallat Gaudi 3.

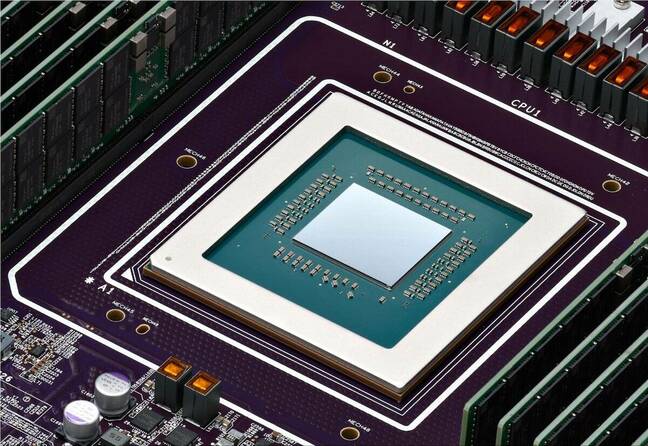

NVIDIA:s H100 GPU:er har utgjort huvuddelen av AI-datacenter, men Intel säger att Gaudi 3 levererar "50% i genomsnitt bättre inferens och 40% i genomsnitt bättre energieffektivitet än Nvidia H100 - till en bråkdel av kostnaden."

En stor bidragande orsak till Gaudi 3:s energieffektivitet är att Intel använde Taiwan Semiconductor Manufacturing Co:s 5nm-process för att tillverka chipen.

Intel gav ingen prisinformation men på frågan om hur den står sig i jämförelse med NVIDIA:s produkter sa Das Kamhout, VP för Xeon-programvara på Intel: "Vi förväntar oss att den kommer att vara mycket konkurrenskraftig."

Dell Technologies, Hewlett Packard Enterprise, Lenovo och Supermicro blir de första att använda Gaudi 3 i sina AI-datacenter.

Intels VD Pat Gelsinger sammanfattade företagets AI-ambitioner med orden "Intel tar med sig AI överallt i hela företaget, från datorn till datacentret till edge".

Den #IntelGaudi 3 #AI accelerator är ett mycket konkurrenskraftigt alternativ till NVIDIAs H100 med högre prestanda, ökad skalbarhet och PyTorch-integration. Utforska fler viktiga produktfördelar. https://t.co/sXdQKjYFw0 pic.twitter.com/iJSndBQkvT

- Intel AI (@IntelAI) 9 april 2024

Googles uppgraderingar av Arm och TPU

På tisdagen tillkännagav Google sin första anpassade Arm-baserade processorer som företaget planerar att använda för att driva sina datacenter. Det nya chipet, som kallas Axion, är en direkt konkurrent till Intels och AMD:s processorer.

Google hävdar att Axion levererar "30% bättre prestanda än de snabbaste Arm-baserade instanserna för allmänt bruk som finns i molnet idag, upp till 50% bättre prestanda och upp till 60% bättre energieffektivitet än jämförbara x86-baserade instanser av nuvarande generation."

Google har flyttat flera av sina tjänster, som YouTube och Google Earth, till sin nuvarande generation Arm-baserade servrar som snart kommer att uppgraderas med Axion-chip.

Med ett kraftfullt Arm-baserat alternativ blir det enklare för kunderna att migrera sina CPU-baserade AI-tränings-, konferens- och andra applikationer till Googles molnplattform utan att behöva designa om dem.

För storskalig modellträning har Google till stor del förlitat sig på sina TPU-chip som ett alternativ till NVIDIA:s hårdvara. Dessa kommer också att uppgraderas med en enda ny TPU v5p som nu innehåller mer än dubbelt så många chip som i den nuvarande TPU v4-podden.

TPU v5p, vår mest kraftfulla och skalbara TPU, är nu allmänt tillgänglig! #GoogleCloudNästa pic.twitter.com/mmfWlzHeqs

- Google Cloud Tech (@GoogleCloudTech) 9 april 2024

Google är inte ute efter att sälja vare sig sina nya Arm-chip eller TPU:er. Företaget vill driva sina cloud computing-tjänster snarare än att bli en direkt hårdvarukonkurrent till NVIDIA.

De uppgraderade TPU:erna kommer att ge en skjuts till Googles AI-hyperdator vilket möjliggör storskalig träning av AI-modeller. AI Hypercomputer använder också NVIDIA H100 GPU:er som enligt Google snart kommer att ersättas med NVIDIA:s nya Blackwell GPU:er.

Efterfrågan på AI-chip kommer sannolikt inte att avta inom den närmaste framtiden, och det ser inte ut som om NVIDIA är den enda vinnaren i detta lopp.