AI har en mängd olika användningsområden, men ett av de mest oroande är skapandet av djupt falska medier och felaktig information.

En ny studie från Google DeepMind och Jigsaw, en teknikinkubator inom Google som övervakar samhällshot, analyserade missbruk av AI mellan januari 2023 och mars 2024.

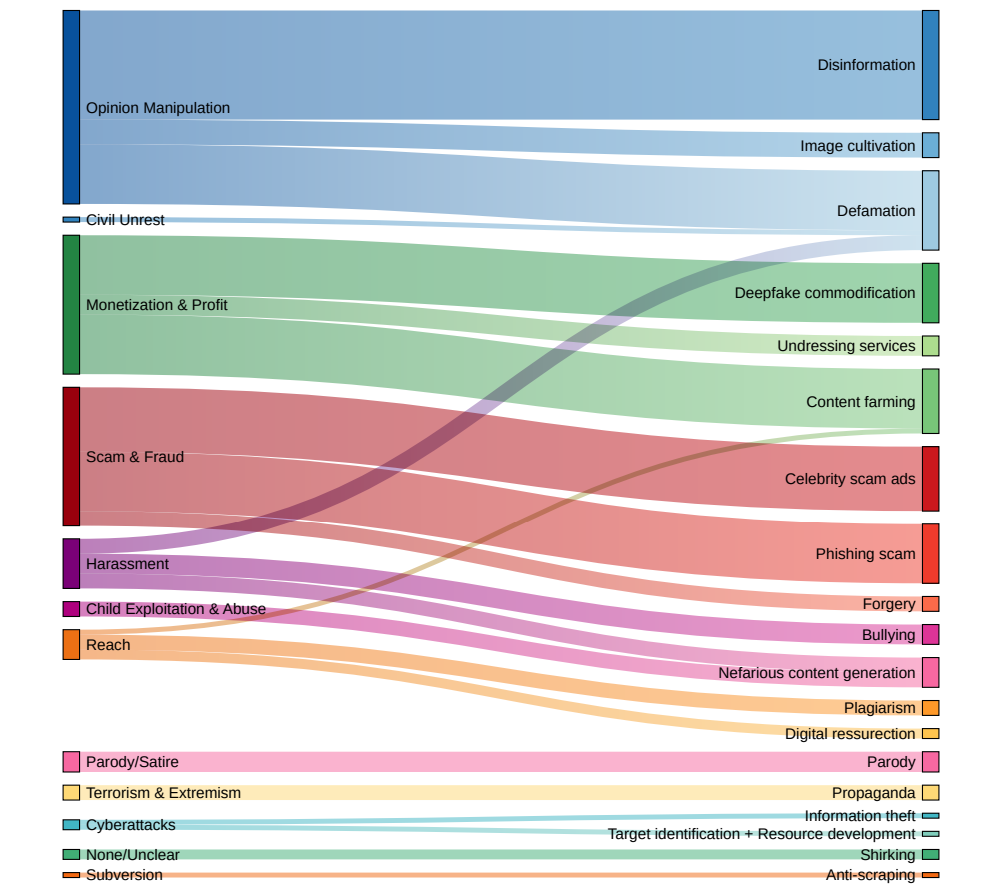

I rapporten utvärderades cirka 200 verkliga incidenter av AI-missbruk, och det visade sig att den vanligaste formen av skadlig AI-användning är att skapa och sprida vilseledande falska medier, särskilt sådana som riktar sig till politiker och offentliga personer.

Deep fakes, syntetiska medier som genereras med hjälp av AI-algoritmer för att skapa mycket realistiska men falska bilder, videor och ljud, har blivit mer verklighetstrogna och genomgripande.

Händelser som när explicit falska bilder av Taylor Swift som visades på X visade att sådana bilder kan nå miljontals människor innan de raderas.

Men mest försåtliga är de djupa förfalskningar som är inriktade på politiska frågor, såsom Israel-Palestina-konflikten. I vissa fall kan inte ens de faktagranskare som har till uppgift att märka dem som "AI-genererade" på ett tillförlitligt sätt upptäcka deras äkthet.

DeepMind-studien samlade in data från en rad olika källor, inklusive sociala medieplattformar som X och Reddit, onlinebloggar och medierapporter.

Varje incident analyserades för att fastställa vilken typ av AI-teknik som missbrukades, vilket syfte som låg bakom missbruket och vilken nivå av teknisk expertis som krävdes för att utföra den skadliga aktiviteten.

Deep fakes är den dominerande formen av AI-missbruk

Resultaten målar upp en alarmerande bild av det nuvarande landskapet för skadlig AI-användning:

- Deep fakes framstod som den dominerande formen av AI-missbruk och stod för nästan dubbelt så många incidenter som den näst vanligaste kategorin.

- Den näst vanligaste typen av AI-missbruk var att använda språkmodeller och chatbotar för att generera och sprida desinformation på nätet. Genom att automatisera skapandet av vilseledande innehåll kan illasinnade aktörer översvämma sociala medier och andra plattformar med falska nyheter och propaganda i en aldrig tidigare skådad omfattning.

- Att påverka den allmänna opinionen och politiska berättelser var det primära motivet bakom över en fjärdedel (27%) av de analyserade fallen av AI-missbruk. Detta illustrerar det hot som deep fakes och AI-genererad desinformation utgör mot demokratiska processer och integriteten i val världen över, vilket vi har observerat från nyligen inträffade uppmärksammade incidenter.

- Ekonomisk vinning identifierades som den näst vanligaste drivkraften bakom skadlig AI-aktivitet, med skrupelfria aktörer som erbjuder betaltjänster för att skapa djupa förfalskningar, inklusive explicita bilder utan samtycke, och utnyttja generativ AI för att massproducera falskt innehåll för vinst.

- Majoriteten av incidenterna med AI-missbruk involverade lättillgängliga verktyg och tjänster som krävde minimal teknisk expertis för att fungera. Detta låga inträdeshinder utökar kraftigt poolen av potentiella illvilliga aktörer, vilket gör det enklare än någonsin för individer och grupper att ägna sig åt AI-drivet bedrägeri och manipulation.

Dr. Nahema Marchal från DeepMind förklarade det utvecklande landskapet för AI-missbruk för Financial Times: "Det hade funnits en hel del förståelig oro kring ganska sofistikerade cyberattacker som underlättats av dessa verktyg", fortsätter, "Vi såg ganska vanliga missbruk av GenAI [som djupa förfalskningar som] kanske går under radarn lite mer."

Beslutsfattare, teknikföretag och forskare måste arbeta tillsammans för att utveckla omfattande strategier för att upptäcka och motverka deepfakes, AI-genererad desinformation och andra former av AI-missbruk.

Men sanningen är att de redan har försökt - och till stor del misslyckats. Bara på senare tid har vi sett fler incidenter av barn som dras in i djupa falska incidenteroch visar att den samhälleliga skada de orsakar kan vara allvarlig.

För närvarande kan teknikföretag inte på ett tillförlitligt sätt upptäcka djupa förfalskningar i stor skala, och de kommer bara att bli mer realistiska och svårare att upptäcka med tiden.

Och när text-till-videosystem som OpenAI:s Sora väl kommer på plats kommer det att finnas en helt ny dimension av djupa förfalskningar att hantera.