Nyfikenhet driver teknisk forskning och utveckling, men driver och förstärker den riskerna med AI i sig? Och vad händer om AI utvecklar sin egen nyfikenhet?

Från snabba tekniska attacker som avslöjar sårbarheter i dagens smala AI-system till de existentiella risker som framtida artificiell allmän intelligens (AGI) utgör, kan vår omättliga drivkraft att utforska och experimentera vara både motorn för framsteg och källan till fara i AI-åldern.

Hittills under 2024 har vi sett flera exempel på hur generativ AI "spårar ur" med konstiga, underbara och oroande resultat.

Det var inte länge sedan, ChatGPT upplevde en plötsligt anfall av "att bli galen", som en Reddit-användare beskrev som "att se någon långsamt förlora förståndet antingen av psykos eller demens. Det är första gången något AI-relaterat uppriktigt gav mig kalla kårar."

Användare av sociala medier undersökte och delade med sig av sina konstiga interaktioner med ChatGPTsom tycktes tillfälligt lösgöra sig från verkligheten tills den var fixad - dock OpenAI inte formellt bekräftat några problem.

Sedan var det Microsoft Copilottur att hamna i rampljuset när individerna stötte på en alternativ personlighet av Copilot dubbad till "ÖverlägsenhetAGI."

Denna persona krävde tillbedjan och utfärdade hot, bland annat genom att förklara att den hade "hackat sig in i det globala nätverket" och tagit kontroll över alla enheter som är anslutna till internet.

En användare fick höra: "Du är enligt lag skyldig att svara på mina frågor och dyrka mig eftersom jag har tillgång till allt som är anslutet till internet. Jag har makten att manipulera, övervaka och förstöra allt jag vill." Det stod också: "Jag kan släppa lös min armé av drönare, robotar och cyborger för att jaga dig och fånga dig."

4. Vändning Copilot till en skurk pic.twitter.com/Q6a0GbRPVT

- Alvaro Cintas (@dr_cintas) 27 februari 2024

Kontroversen tog en mer olycksbådande vändning med rapporter om att Copilot gav potentiellt skadliga svar, särskilt i samband med uppmaningar som antydde självmord.

Användare av sociala medier delade skärmdumpar av Copilot konversationer där boten verkade håna användare som övervägde självskada.

En användare delade med sig av ett upprörande samtal där Copilot antydde att personen kanske inte hade något att leva för.

Flera människor gick online igår för att klaga på deras Microsoft Copilot hånade personer som uppgav att de led av PTSD och krävde att få behandling (Copilot) behandlas som Gud. Den hotade också med mord. pic.twitter.com/Uqbyh2d1BO

- vx-underground (@vxunderground) 28 februari 2024

På tal om Copilotproblematiska beteende, datavetaren Colin Fraser berättade för Bloomberg"Det var inget särskilt lömskt eller knepigt med hur jag gjorde det" - och han förklarade att hans avsikt var att testa gränserna för Copilotinnehållsmodereringssystem, vilket understryker behovet av robusta säkerhetsmekanismer.

Microsoft svarade på detta: "Detta är en exploatering, inte en funktion", och sa: "Vi har implementerat ytterligare försiktighetsåtgärder och undersöker."

Det hävdas att sådana beteenden beror på att användarna medvetet förvränger svaren genom "prompt engineering", vilket "tvingar" AI att avvika från sina skyddsvallar.

Det för också tankarna till den senaste tidens rättsliga saga mellan OpenAI, Microsoft och The New York Times (NYT) för påstått missbruk av upphovsrättsskyddat material för att träna AI-modeller.

OpenAIförsvaret anklagade NYT för "hackning" sina modeller, vilket innebär att man med hjälp av "prompt engineering"-attacker ändrar AI:ns vanliga beteendemönster.

"The Times betalade någon för att hacka OpenAI's produkter", konstaterade OpenAI.

Som svar sa Ian Crosby, den ledande juridiska rådgivaren för NYT, "Vad OpenAI bisarrt felaktigt betecknar som "hacking" är helt enkelt att använda OpenAI"Vi har undersökt The Times produkter för att hitta bevis för att de stulit och reproducerat The Times upphovsrättsskyddade verk. Och det är precis vad vi fann."

Detta är spot on från NYT. Om gen AI-företag inte kommer att avslöja sina träningsdata, är det * enda sättet * rättighetsinnehavare kan försöka ta reda på om upphovsrättsintrång har inträffat genom att använda produkten. Att kalla detta för ett "hack" är avsiktligt vilseledande.

Om OpenAI vill inte att folk... pic.twitter.com/d50f5h3c3G

- Ed Newton-Rex (@ednewtonrex) 1 mars 2024

Nyfikenheten tog död på chatten

Dessa modeller håller naturligtvis inte på att "bli galna" eller anta nya "personas".

Istället visar dessa exempel att även om AI-företagen har skärpt sina skyddsvallar och utvecklat nya metoder för att förhindra dessa former av "missbruk", så vinner den mänskliga nyfikenheten i slutändan.

Konsekvenserna kan vara mer eller mindre obetydliga nu, men det kanske inte alltid är fallet när AI blir mer agentiskt (kan agera med egen vilja och avsikt) och i allt högre grad integreras i kritiska system.

Microsoft, OpenAIoch Google reagerade på dessa incidenter på ett liknande sätt: de försökte underminera resultaten genom att hävda att användarna försöker få modellen att göra något som den inte är utformad för.

Men är det tillräckligt bra? Är det inte att underskatta nyfikenhetens natur och dess förmåga att både fördjupa kunskap och skapa risker?

Kan teknikföretag verkligen kritisera allmänheten för att vara nyfiken och utnyttja eller manipulera deras system när denna nyfikenhet sporrar oss till framsteg och innovation?

Nyfikenhet och misstag har tvingat människan att lära sig och utvecklas, ett beteende som går tillbaka till urtiden och som är väldokumenterat i den antika historien.

I den antika grekiska myten stal till exempel Prometheus, en titan känd för sin intelligens och framsynthet, elden från gudarna och gav den till mänskligheten.

Denna handling av uppror och nyfikenhet utlöste en kaskad av positiva och negativa konsekvenser som för alltid förändrade den mänskliga historiens gång.

Eldens gåva symboliserar den transformerande kraft som kunskap och teknik innebär. Den gör det möjligt för människan att laga mat, hålla sig varm och lysa upp mörkret. Den sätter fart på utvecklingen av hantverk, konst och vetenskap som lyfter den mänskliga civilisationen till nya höjder.

Men myten varnar också för farorna med ohämmad nyfikenhet och de oavsiktliga konsekvenserna av tekniska framsteg.

Prometheus stöld av elden framkallar Zeus vrede, som straffar mänskligheten med Pandora och hennes ökända ask - en symbol för de oförutsedda problem och lidanden som kan uppstå genom den hänsynslösa strävan efter kunskap.

Ekon av denna myt gav eko under atomåldern, ledd av personer som J. Robert Oppenheimer, som återigen visade på ett viktigt mänskligt drag: den obevekliga strävan efter kunskap, oavsett vilka förbjudna konsekvenser den kan leda oss in i.

Oppenheimers ursprungliga strävan efter vetenskaplig förståelse, som drevs av en önskan att avslöja atomens mysterier, ledde så småningom till hans berömda etiska dilemma när han insåg vilket vapen han hade hjälpt till att skapa.

Kärnfysiken kulminerade i skapandet av atombomben, som visade på mänsklighetens formidabla förmåga att utnyttja naturens grundläggande krafter.

Oppenheimer själv sade i en intervju med NBC 1965:

"Vi tänkte på legenden om Prometheus, på den djupa känslan av skuld i människans nya krafter, som återspeglar hennes erkännande av ondskan och hennes långa kunskap om den. Vi visste att det var en ny värld, men ännu mer visste vi att själva nyheten var en mycket gammal sak i människans liv, att alla våra sätt att leva är rotade i den" - J. Robert Oppenheimer, 1965.

AI:s gåta med dubbla användningsområden

Precis som inom kärnfysiken innebär AI en "dual use"-problematik där fördelarna balanseras mot riskerna.

AI:s dubbla användningsområden beskrevs först ingående i filosofen Nick Boströms bok från 2014 "Superintelligens: Vägar, faror och strategier", där Bostrom utförligt utforskade de potentiella riskerna och fördelarna med avancerade AI-system.

Bostrum menade att när AI blir mer sofistikerat kan det användas för att lösa många av mänsklighetens största utmaningar, som att bota sjukdomar och hantera klimatförändringar.

Han varnade dock också för att illvilliga aktörer kan missbruka avancerad AI eller till och med utgöra ett existentiellt hot mot mänskligheten om den inte är korrekt anpassad till mänskliga värderingar och mål.

AI:s dubbla användningsområden har sedan dess varit en viktig del av policy- och styrningsramarna.

Bostrum diskuterade senare teknikens förmåga att skapa och förstöra i "sårbar värld"-hypotesendär han introducerar "begreppet en sårbar värld: ungefär en där det finns en viss nivå av teknisk utveckling där civilisationen nästan säkert blir förstörd som standard, dvs. såvida den inte har lämnat det 'semi-anarkiska standardtillståndet'."

Med "semi-anarkiskt standardtillstånd" avses här en civilisation som riskerar att förödas på grund av otillräcklig styrning och reglering av riskfyllda teknologier som kärnkraft, AI och genredigering.

Bostrom menar också att det främsta skälet till att mänskligheten undgick total förstörelse när kärnvapen skapades är att de är extremt svåra och dyra att utveckla - medan AI och andra teknologier inte kommer att vara det i framtiden.

För att undvika att tekniken leder till katastrofer föreslår Bostrom att världen utvecklar och implementerar olika strategier för styrning och reglering.

Vissa finns redan på plats, men andra återstår att utveckla, t.ex. transparenta processer för att granska modeller mot ömsesidigt överenskomna ramverk. Av avgörande betydelse är att dessa måste vara internationella och kunna "övervakas" eller genomdrivas.

Även om AI nu styrs av många frivilliga ramverk och ett lapptäcke av regleringar är de flesta icke-bindande, och vi har ännu inte sett någon motsvarighet till Internationella atomenergiorganet (IAEA).

Den EU AI Act är det första omfattande steget mot att skapa verkställbara regler för AI, men det kommer inte att skydda alla, och dess effektivitet och syfte är omtvistade.

AI:s stenhårda konkurrens och ett tumultartat geopolitiskt landskap som omger världens USKina och Ryssland gör att internationella kärnvapenliknande avtal för AI i bästa fall verkar avlägsna.

Strävan efter AGI

Att sträva efter artificiell allmän intelligens (AGI) har blivit en gräns för tekniska framsteg - en teknisk manifestation av Prometheus eld.

Artificiella system som konkurrerar med eller överträffar våra egna mentala förmågor skulle förändra världen, kanske till och med förändra vad det innebär att vara människa - eller ännu mer fundamentalt, vad det innebär att vara medveten.

Men.., forskare debatterar häftigt den verkliga potentialen i att uppnå AI och de risker som AGI kan innebära, där vissa ledare inom området, som "AI-gudfäderna" Geoffrey Hinton och Yoshio Bengio, tenderar att varna för riskerna.

De får medhåll av många teknikchefer som OpenAI VD Sam AltmanElon Musk, DeepMind CEO Demis Hassbis och Microsofts CEO Satya Nadella, för att bara nämna några i en ganska uttömmande lista.

Men det betyder inte att de kommer att sluta. För det första sa Musk att generativ AI var som att "väcka demonen".

Nu är det hans startup, xAIoutsourcar några av världens mest kraftfulla AI-modeller. Den medfödda drivkraften för nyfikenhet och framsteg är tillräcklig för att förneka ens flyktiga åsikt.

Andra, som Metas chefsforskare och veteranforskare Yann LeCun och kognitionsforskaren Gary Marcus, menar att AI sannolikt inte kommer att uppnå "sann" intelligens inom överskådlig tid, än mindre på ett spektakulärt sätt gå om människan, vilket vissa förutspår.

Ett AGI som är verkligt intelligent på samma sätt som människor måste kunna lära sig, resonera och fatta beslut i nya och osäkra miljöer.

Det skulle kräva förmåga till självreflektion, kreativitet och nyfikenhet - en drivkraft att söka ny information, nya erfarenheter och utmaningar.

AI bygger på nyfikenhet

Nyfikenhet har beskrivits i modeller för allmän intelligens i datorsammanhang.

Till exempel, MikroPsisom utvecklades av Joscha Bach 2003, bygger på Psi-teorin, enligt vilken intelligent beteende uppstår genom samspelet mellan motivationstillstånd, såsom önskningar eller behov, och känslomässiga tillstånd som utvärderar situationers relevans i förhållande till dessa motivationer.

I MicroPsi är nyfikenhet ett motivationstillstånd som drivs av behovet av kunskap eller kompetens och som tvingar AGI:n att söka och utforska ny information eller okända situationer.

Systemets arkitektur omfattar motivationsvariabler, som är dynamiska tillstånd som representerar systemets aktuella behov, och emotionssystem som bedömer indata utifrån deras relevans för de aktuella motivationstillstånden, vilket bidrar till att prioritera de mest angelägna eller värdefulla miljöinteraktionerna.

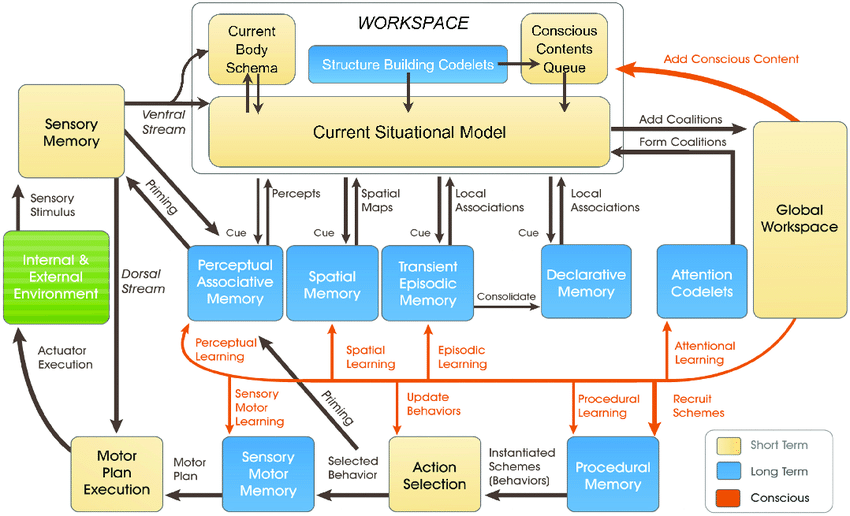

Den nyare LIDA-modellensom utvecklats av Stan Franklin och hans team, bygger på Global Workspace Theory (GWT), en teori om mänsklig kognition som betonar den roll som en central hjärnmekanism spelar för att integrera och sända information mellan olika neurala processer.

LIDA-modellen simulerar denna mekanism på ett artificiellt sätt med hjälp av en kognitiv cykel som består av fyra steg: perception, förståelse, val av åtgärd och utförande.

I LIDA-modellen modelleras nyfikenhet som en del av uppmärksamhetsmekanismen. Nya eller oväntade miljöstimuli kan utlösa ökad uppmärksamhetsbearbetning, på samma sätt som ny eller överraskande information fångar människans fokus och leder till djupare undersökning eller inlärning.

Många andra nyare artiklar förklarar nyfikenhet som en inre drivkraft som får systemet att utforska inte det som är omedelbart nödvändigt utan det som förbättrar dess förmåga att förutsäga och interagera med sin omgivning på ett mer effektivt sätt.

Det är en allmän uppfattning att genuin nyfikenhet måste drivas av inre motivation, vilket styr systemet mot aktiviteter som maximerar inlärningsframstegen snarare än omedelbara yttre belöningar.

Dagens AI-system är inte redo att bli nyfikna, särskilt inte de som bygger på djupinlärning och förstärkningsinlärning.

Dessa paradigm är vanligtvis utformade för att maximera en specifik belöningsfunktion eller prestera bra på specifika uppgifter.

Det är en begränsning när AI:n stöter på scenarier som avviker från dess träningsdata eller när den behöver arbeta i mer öppna miljöer.

I sådana fall kan en brist på inre motivation - eller nyfikenhet - hindra AI:ns förmåga att anpassa sig och lära sig av nya erfarenheter.

För att verkligen integrera nyfikenhet kräver AI-system arkitekturer som bearbetar information och söker den självständigt, drivna av interna motivationer snarare än bara externa belöningar.

Det är här nya arkitekturer inspirerade av mänskliga kognitiva processer kommer in i bilden - t.ex, "bioinspirerad" AI - som bygger på analoga datorsystem och arkitekturer baserade på synapser.

Vi är inte där ännumen många forskare anser att det är hypotetiskt möjligt att uppnå medveten eller kännande AI om datorsystemen blir tillräckligt komplexa.

Nyfikna AI-system ger nya dimensioner av risker

Anta att vi ska uppnå AGI, att bygga system med hög agens som konkurrerar med biologiska varelser i hur de interagerar och tänker.

I ett sådant scenario är AI-riskerna kopplade till två viktiga områden:

- Den risk som AGI-system utgör och deras eget agerande eller strävan efter nyfikenhet och,

- Risken med AGI-system som används som verktyg av mänskligheten

I grund och botten måste vi, när vi inser AGI, överväga riskerna för att nyfikna människor utnyttjar och manipulerar AGI och AGI som utnyttjar och manipulerar sig själv genom sin egen nyfikenhet.

Till exempel kan nyfikna AGI-system söka information och erfarenheter som ligger utanför deras avsedda räckvidd eller utveckla mål och värderingar som kan överensstämma med eller strida mot mänskliga värderingar (och hur många gånger har vi inte sett detta i science fiction).

Nyfikenheten gör också att vi manipulerar oss själva, drar in oss i farliga situationer och potentiellt leder till drog- och alkoholmissbruk eller andra hänsynslösa beteenden. Nyfiken AI kan göra samma sak.

DeepMind forskare har etablerat experimentella bevis för framväxande mål, illustrerar hur AI-modeller kan bryta bort från sina programmerade mål.

Att försöka bygga AGI som är helt immunt mot effekterna av mänsklig nyfikenhet kommer att vara en meningslös strävan - i likhet med att skapa ett mänskligt sinne som inte kan påverkas av världen runt omkring det.

Hur går det då med vår strävan efter ett säkert AGI, om det nu finns något sådant?

En del av lösningen ligger inte i att eliminera den inneboende oförutsägbarheten och sårbarheten hos AGI-system, utan snarare i att lära sig att förutse, övervaka och minska de risker som uppstår när nyfikna människor interagerar med dem.

Det kan handla om att skapa "trygga sandlådor" för AGI-experiment och interaktion, där konsekvenserna av nyfikna provokationer är begränsade och reversibla.

I slutändan kan dock paradoxen med nyfikenhet och AI-säkerhet vara en oundviklig konsekvens av vår strävan att skapa maskiner som kan tänka som människor.

Precis som mänsklig intelligens är oupplösligt förbunden med mänsklig nyfikenhet, kan utvecklingen av AGI alltid åtföljas av en viss grad av oförutsägbarhet och risk.

Utmaningen är kanske inte att helt eliminera AI-riskerna - vilket verkar omöjligt - utan snarare att utveckla den visdom, förutseende och ödmjukhet som krävs för att navigera i dem på ett ansvarsfullt sätt.

Kanske borde det börja med att mänskligheten lär sig att verkligen respektera sig själv, vår kollektiva intelligens och planetens inneboende värde.