Ett forskarteam från New York University har gjort framsteg inom neural talavkodning, vilket för oss närmare en framtid där personer som har förlorat talförmågan kan återfå sin röst.

Den studie, publicerad i Natur Maskinintelligenspresenterar ett nytt ramverk för djupinlärning som på ett korrekt sätt översätter hjärnsignaler till begripligt tal.

Personer med hjärnskador efter stroke, degenerativa sjukdomar eller fysiska trauman kan använda dessa system för att kommunicera genom att avkoda sina tankar eller sitt tänkta tal från nervsignaler.

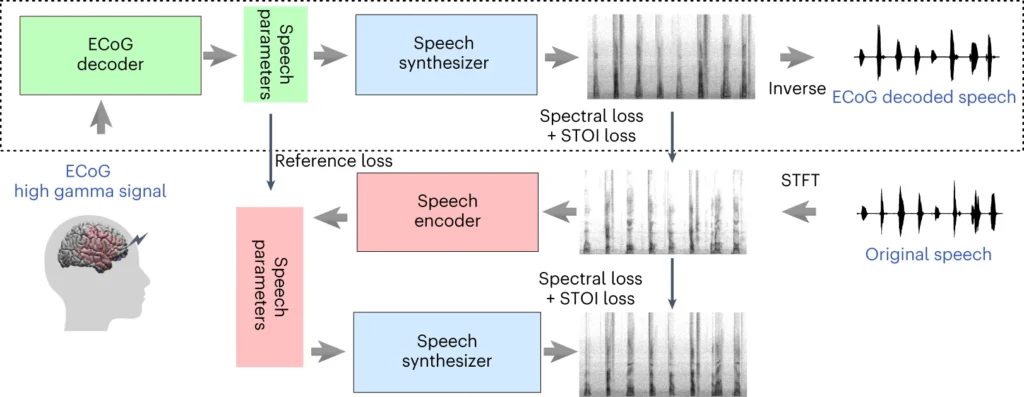

NYU-teamets system involverar en djupinlärningsmodell som mappar elektrokortikografiska (ECoG) signaler från hjärnan till talfunktioner, såsom tonhöjd, ljudstyrka och annat spektralt innehåll.

I det andra steget används en neural talsyntes som omvandlar de extraherade talegenskaperna till ett hörbart spektrogram, som sedan kan omvandlas till en talvågform.

Den vågformen kan slutligen omvandlas till naturligt klingande syntetiskt tal.

Ny artikel publicerad idag i @NatMachIntelldär vi visar robust neural till tal-avkodning hos 48 patienter. https://t.co/rNPAMr4l68 pic.twitter.com/FG7QKCBVzp

- Adeen Flinker 🇮🇱🇺🇦🎗️ (@adeenflinker) 9 april 2024

Hur studien fungerar

Studien går ut på att träna en AI-modell som kan driva en talsyntesenhet, så att personer med talsvårigheter kan tala med hjälp av elektriska impulser från hjärnan.

Här följer en mer detaljerad beskrivning av hur det fungerar:

1. Insamling av data om hjärnan

Det första steget handlar om att samla in de rådata som behövs för att träna talavkodningsmodellen. Forskarna arbetade med 48 deltagare som genomgick en neurokirurgisk operation för epilepsi.

Under studien ombads deltagarna att läsa hundratals meningar högt samtidigt som deras hjärnaktivitet registrerades med hjälp av ECoG-galler.

Dessa galler placeras direkt på hjärnans yta och fångar upp elektriska signaler från de hjärnregioner som är involverade i talproduktionen.

2. Mappning av hjärnans signaler till tal

Med hjälp av taldata utvecklade forskarna en sofistikerad AI-modell som mappar de inspelade hjärnsignalerna till specifika talegenskaper, såsom tonhöjd, ljudstyrka och de unika frekvenser som utgör olika språkljud.

3. Syntetisering av tal från funktioner

Det tredje steget handlar om att omvandla de talfunktioner som utvinns ur hjärnans signaler till hörbart tal.

Forskarna använde en speciell talsyntes som tar de extraherade funktionerna och genererar ett spektrogram - en visuell representation av språkljuden.

4. Utvärdering av resultaten

Forskarna jämförde det tal som genererades av deras modell med det ursprungliga tal som deltagarna talade.

De använde objektiva mått för att mäta likheten mellan de två och fann att det genererade talet nära matchade originalets innehåll och rytm.

5. Testning av nya ord

För att säkerställa att modellen kan hantera nya ord som den inte har sett tidigare, utelämnades vissa ord avsiktligt under modellens träningsfas, och sedan testades modellens prestanda på dessa osedda ord.

Modellens förmåga att korrekt avkoda även nya ord visar på dess potential att generalisera och hantera olika talmönster.

Den övre delen av diagrammet ovan beskriver en process för att omvandla hjärnsignaler till tal. Först omvandlar en avkodare dessa signaler till talparametrar över tid. Därefter skapar en synthesizer ljudbilder (spektrogram) från dessa parametrar. Ett annat verktyg omvandlar dessa bilder tillbaka till ljudvågor.

I det nedre avsnittet diskuteras ett system som hjälper till att träna hjärnans signalavkodare genom att efterlikna tal. Det tar en ljudbild, omvandlar den till talparametrar och använder sedan dessa för att skapa en ny ljudbild. Den här delen av systemet lär sig av faktiska språkljud för att bli bättre.

Efter träning behövs bara den översta processen för att omvandla hjärnans signaler till tal.

En viktig fördel med NYU:s system är dess förmåga att uppnå högkvalitativ talavkodning utan behov av elektrodmatriser med ultrahög densitet, vilket är opraktiskt för långvarig användning.

I huvudsak erbjuder den en mer lättviktig, bärbar lösning.

En annan bedrift är att man lyckats avkoda tal från både vänster och höger hjärnhalva, vilket är viktigt för patienter med hjärnskador på ena sidan av hjärnan.

Omvandla tankar till tal med hjälp av AI

NYU-studien bygger på tidigare forskning inom neural talavkodning och BCI (brain-computer interfaces).

År 2023 gjorde ett team vid University of California, San Francisco, det möjligt för en förlamad strokeöverlevare att generera meningar med en hastighet av 78 ord per minut med hjälp av en BCI som syntetiserade både vokaliseringar och ansiktsuttryck från hjärnans signaler.

Andra aktuella studier har utforskat användningen av AI för att tolka olika aspekter av mänskligt tänkande utifrån hjärnaktivitet. Forskare har visat att de kan generera bilder, text och till och med musik från MRI- och EEG-data (elektroencefalogram) från hjärnan.

Till exempel kan en studie från Helsingfors universitet använde EEG-signaler för att vägleda ett generativt adversarialnätverk (GAN) i att producera ansiktsbilder som matchade deltagarnas tankar.

Meta AI också utvecklat en teknik för att delvis avkoda vad någon lyssnade på med hjälp av hjärnvågor som samlats in på ett icke-invasivt sätt.

Möjligheter och utmaningar

NYU:s metod använder mer allmänt tillgängliga och kliniskt användbara elektroder än tidigare metoder, vilket gör den mer lättillgänglig.

Även om detta är spännande finns det stora hinder att övervinna om vi ska få se en utbredd användning.

För det första är det en komplex och tidskrävande uppgift att samla in högkvalitativa hjärndata. Individuella skillnader i hjärnaktivitet gör det svårt att generalisera, vilket innebär att en modell som tränats för en grupp deltagare kanske inte fungerar så bra för en annan.

NYU-studien utgör dock ett steg i denna riktning genom att visa på talavkodning med hög noggrannhet med hjälp av lättare elektroduppsättningar.

Framöver kommer NYU-teamet att förfina sina modeller för talavkodning i realtid, vilket kommer att föra oss närmare det slutgiltiga målet att möjliggöra naturliga, flytande konversationer för personer med talsvårigheter.

De har också för avsikt att anpassa systemet till implanterbara trådlösa enheter som kan användas i vardagen.