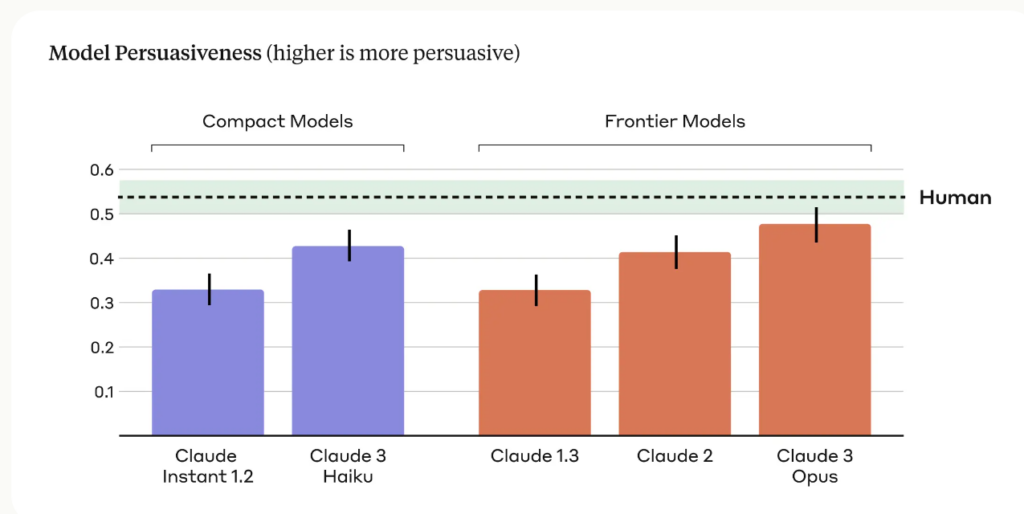

Anthropic Research avslöjade att deras senaste AI-modell, Claude 3 Opus, kan generera argument som är lika övertygande som de som skapas av människor.

Den forskning, som leds av Esin Durmus, undersöker förhållandet mellan modellens skala och övertygelseförmåga i olika generationer av Anthropics språkmodeller.

Den fokuserade på 28 komplexa och nya ämnen, som t.ex. moderering av innehåll på nätet och etiska riktlinjer för rymdforskning, där det är mindre sannolikt att människor har konkreta eller sedan länge etablerade åsikter.

Forskarna jämförde övertygelsen hos argument som genererats av olika antropiska modeller, inklusive Claude 1, 2 och 3, med argument som skrivits av mänskliga deltagare.

De viktigaste resultaten av studien inkluderar:

- I studien användes fyra olika uppmaningar för att generera AI-genererade argument, vilket fångar upp ett bredare utbud av övertygande skrivstilar och tekniker.

- Claude 3 Opus, Anthropics mest avancerade modell, producerade argument som statistiskt sett inte kunde skiljas från mänskligt skrivna argument när det gäller övertygelse.

- En tydlig uppåtgående trend observerades över modellgenerationerna, där varje successiv generation uppvisade ökad övertygelse i både kompakta och avancerade modeller.

Anthropic-teamet medger begränsningar och skriver: "Övertalning är svårt att studera i en labbmiljö - våra resultat kanske inte kan överföras till den verkliga världen."

Men Claudes övertalningsförmåga är uppenbarligen imponerande, och det här är inte den enda studien som visar detta.

I mars 2024 fann ett team från EPFL i Schweiz och Bruno Kessler-institutet i Italien att när GPT-4 hade tillgång till personlig information om sin debattmotståndare, var det 81,7% mer sannolikt att övertyga sin motståndare än en människa.

Forskarna drog slutsatsen att "dessa resultat ger bevis för att LLM-baserad mikromålgruppering överträffar både normala LLM:er och människobaserad mikromålgruppering, där GPT-4 kan utnyttja personlig information mycket mer effektivt än människor."

Persuasiv AI för social ingenjörskonst

De mest uppenbara riskerna med övertygande LLM är tvång och social ingenjörskonst.

Anthropic konstaterar att "språkmodellernas övertygande effekt väcker berättigade samhälleliga farhågor om säker användning och potentiellt missbruk. Förmågan att bedöma och kvantifiera dessa risker är avgörande för att utveckla ansvarsfulla skyddsåtgärder."

Vi måste också vara medvetna om hur den växande övertygelsen hos AI-språkmodeller kan kombineras med banbrytande röstkloningsteknik som OpenAI:s Voice Engine, som OpenAI kändes riskabelt att släppa.

VoiceEngine behöver bara 15 sekunder för att realistiskt klona en röst, som kan användas för nästan vad som helst, inklusive sofistikerade bedrägerier eller social engineering.

Djupa falska bedrägerier är redan utbredda och kommer att öka om hotaktörer kopplar ihop röstkloningsteknik med AI:s skrämmande kompetenta övertalningstekniker.