NVIDIA har släppt Chat with RTX som en teknisk demonstration av hur AI-chattbottar kan köras lokalt på Windows-datorer med hjälp av RTX GPU:er.

Standardmetoden för att använda en AI-chatbot är att använda en webbplattform som ChatGPT eller att köra frågor via ett API, med inferens som sker på molnservrar. Nackdelarna med detta är kostnaderna, latensen och integritetsaspekterna med personuppgifter eller företagsdata som överförs fram och tillbaka.

NVIDIA:s RTX GPU-serien gör det nu möjligt att köra en LLM lokalt på din Windows-dator även om du inte är ansluten till internet.

Chat with RTX låter användare skapa en personlig chatbot med hjälp av antingen Mistral eller Lama 2. Den använder RAG (retrieval-augmented generation) och NVIDIA:s inferensoptimerande programvara TensorRT-LLM.

Du kan styra Chat with RTX till en mapp på din dator och sedan ställa frågor om filerna i mappen. Programmet stöder olika filformat, bland annat .txt, .pdf, .doc/.docx och .xml.

Eftersom LLM analyserar lokalt lagrade filer med slutledning som sker på din maskin är det mycket snabbt och ingen av dina data delas på potentiellt osäkra nätverk.

Du kan också ge den en URL till en YouTube-video och ställa frågor om videon. Det kräver internetåtkomst, men det är ett bra sätt att få svar utan att behöva titta på en lång video.

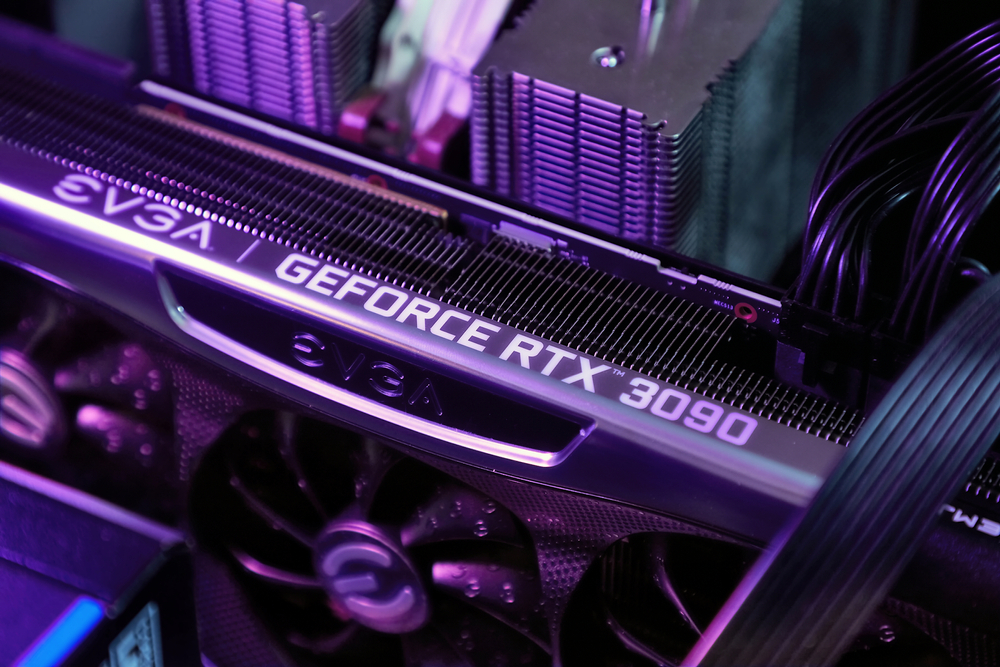

Du kan nedladdning Chatt med RTX gratis, men du måste köra Windows 10 eller 11 på din dator med en GPU i GeForce RTX 30-serien eller högre, med minst 8 GB VRAM.

Chatt med RTX är en demo, snarare än en färdig produkt. Den är lite buggig och kommer inte ihåg sammanhanget, så du kan inte ställa följdfrågor till den. Men det är ett bra exempel på hur vi kommer att använda LLM:er i framtiden.

Att använda en AI-chatbot lokalt med noll API-samtalskostnader och mycket liten latens är sannolikt det sätt som de flesta användare så småningom kommer att interagera med LLM. Den öppna källkodsstrategin som företag som Meta har tagit kommer att se AI på enheten driva antagandet av sina fria modeller snarare än proprietära som GPT.

Med detta sagt kommer användare av mobila och bärbara datorer att få vänta ett tag till innan datorkraften hos en RTX GPU kan passa in i mindre enheter.