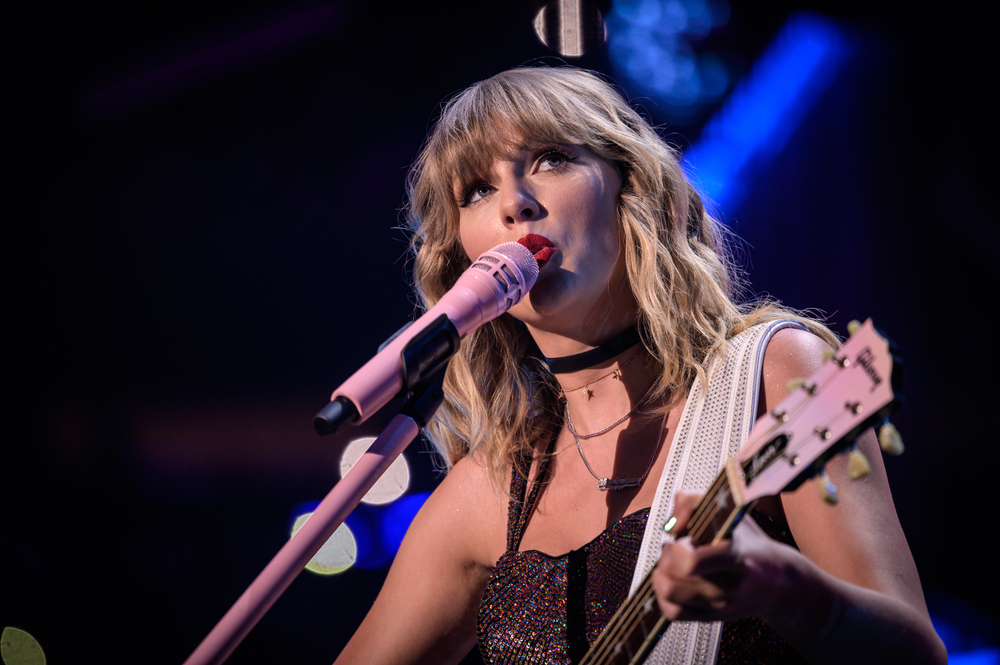

Explicita AI-genererade deep fake-bilder av popstjärnan Taylor Swift spreds nyligen på sociala medier och väckte stor uppståndelse.

Trots strikta regler mot sådant innehåll visade dessa bilder utan samtycke Swift i sexuellt explicita positioner och var live i 19 timmar, med över 27 miljoner visningar och 260.000 gillamarkeringar innan inläggskontot stängdes av.

Händelsen bidrar till en flod av frågor om effektiviteten i policyer för sociala medier mot djup falsk felaktig information.

Kan det stoppas? Till synes inte. Så hur bekämpar vi det? AI-detekteringstjänster (som liknar faktagranskare) och "Community Notes", som bifogas inlägg på X, är två möjliga lösningar, men båda har sina brister.

De explicita bilderna på Taylor Swift cirkulerade främst på den sociala medieplattformen X men hittade också sin väg till andra sociala medieplattformar, inklusive Facebook, vilket visar hur kontroversiellt AI-innehåll sprids som en löpeld.

En talesman från Meta svarade på händelsen och sade: "Detta innehåll bryter mot våra policyer, och vi tar bort det från våra plattformar och vidtar åtgärder mot konton som publicerade det. Vi fortsätter att övervaka och om vi identifierar ytterligare kränkande innehåll tar vi bort det och vidtar lämpliga åtgärder."

Miljontals användare tog till Reddit för att diskutera konsekvenserna och effekterna av detta och andra virala djupfalska incidenter på senare tid, inklusive ett foto av Eiffeltornet i brand.

Det finns en TikTok-video som går runt, sett miljontals gånger, som hävdar att Eiffeltornet brinner. Eiffeltornet står inte i brand. pic.twitter.com/IxlsKOqOsI

- Alistair Coleman (@alistaircoleman) 22 januari 2024

Även om många skulle uppfatta dessa bilder som uppenbart falska, kan vi inte utgå från att den breda allmänheten är medveten om detta.

En kommentator på Reddit sa om Taylor Swift-incidenten: "Nu vet jag hur många som inte vet vad deepfakes är", vilket tyder på låg medvetenhet om frågan.

Branschexperter diskuterade också frågan med Ed Newton-Rex, tidigare chef för Stabilitet, och hävdade att teknikföretagens "gung-ho"-attityder och dåliga engagemang från beslutsfattarna bidrar till problemet.

Explicita AI-deepfakes utan samtycke är resultatet av en rad olika brister.

- Kulturen "skeppas så fort som möjligt" för generativ AI, oavsett konsekvenserna

- Avsiktlig okunnighet inom AI-företagen om vad deras modeller används till

- En total brist på respekt för förtroende och...- Ed Newton-Rex (@ednewtonrex) 26 januari 2024

Ben Decker från Memetica, en digital utredningsbyrå, kommenterade bristen på kontroll över AI:s effekter: "Det här är ett utmärkt exempel på hur AI släpps lös av många oärliga skäl utan att det finns tillräckligt med skyddsräcken på plats för att skydda det offentliga rummet."

Han pekade också på bristerna i de sociala medieföretagens strategier för innehållsövervakning.

Rapporter tyder på att Taylor Swift nu överväger rättsliga åtgärder mot den djupa falska porrsajten som är värd för bilderna.

Det har förekommit många liknande fall av förfalskningar av explicita djup, oftast med kvinnor och barn, ibland med avsikt att muta människoräven kallad "sexploitation".

AI-bilder på sexuella övergrepp mot barn är den mörkaste och mest oroande effekten av bildgenereringstekniken. En amerikansk man blev nyligen dömd till 40 års fängelse i fängelse för att ha innehaft sådana bilder.

I kölvattnet av denna och andra liknande incidenter har kraven ökat på lagstiftning för att komma till rätta med denna form av missbruk av AI.

USA:s representant Joe Morelle beskrev spridningen av Swifts deepfakes som "förfärlig" och förespråkade omedelbara rättsliga åtgärder. Han konstaterade att "det som hänt Taylor Swift inte är något nytt", och underströk att sådant innehåll har en oproportionerlig inverkan på kvinnor.

Deep fake-desinformation diskuterades också flitigt på Världsekonomiskt forum i Davos med stigande rädsla för att manipulerat innehåll ska kunna påverka aktiemarknader, val och den allmänna opinionen.

Ansträngningar för att bekämpa djupa förfalskningar pågår, med både nystartade företag och teknikjättar som utvecklar detekteringsteknik.

Intel har till exempel lanserat en produkt som kan upptäcka falska videor med 96% noggrannhet.

Utmaningen är dock i stort sett oöverstiglig än så länge, eftersom tekniken utvecklas snabbt och sprids över internet.