En undersökning av The Guardian har belyst Storbritanniens genomgripande användning av AI och komplexa algoritmer i olika beslutsprocesser inom den offentliga sektorn.

Tjänstemän från minst åtta myndigheter och flera polisenheter har införlivat AI-verktyg i sina arbetsflöden.

AI-verktyg har underlättat viktiga beslutsprocesser inom välfärd, invandring och straffrätt. Undersökningen visade att det fanns bevis för missbruk och diskriminering.

Även om algoritmisk och AI-relaterad partiskhet inte strikt faller under samma definition, riskerar de båda att leda till partiska resultat när de utsätts för verkliga scenarier. Självlärande maskininlärningsmodeller kan förstärka felaktigheter som dominerar i dataset.

I enlighet med rapport:

- En parlamentsledamot har uttryckt oro över en algoritm som används av Department for Work and Pensions (DWP), som misstänks ha resulterat i att många personer felaktigt förlorat sina bidrag.

- Metropolitan Police's ansiktsigenkänningsverktyg har visat sig ha en högre felfrekvens när det gäller att identifiera svarta ansikten jämfört med vita ansikten under vissa förhållanden. Detta är väletablerat, med en studie vilket indikerar att dessa plattformar erbjöd en noggrannhet på ynka 2% under 2018.

- Inrikesministeriet har använt en algoritm som oproportionerligt riktar sig till personer från specifika nationaliteter för att avslöja bedrägliga äktenskap för förmåner och skattelättnader. Medborgare från Albanien, Grekland, Rumänien och Bulgarien kan ha blivit orättvist flaggade.

AI-verktyg lär sig mönster från omfattande dataset. Om datauppsättningar är partiska eller dåligt representativa för verkligheten ärver modellen dessa mönster.

Det finns många internationella exempel på AI-relaterad och algoritmisk partiskhet, bland annat falska ansiktsigenkänningsmatcher som leder till fängelsestraff, kreditbedömningssystem fördomar som drabbar kvinnoroch diskriminerande verktyg som används i domstolar och sjukvårdssystem.

I The Guardians rapport hävdas att Storbritannien nu står på randen till en potentiell skandal, med experter som uttrycker oro över öppenheten och förståelsen för de algoritmer som används av tjänstemän.

Skandalerna har redan har bevittnats i andra ländersom till exempel i USA, där plattformar för förutseende polisarbete har avvecklatsoch i Nederländerna, där domstolarna motsatte sig ett AI-system som skulle motverka socialbidragsbedrägerier.

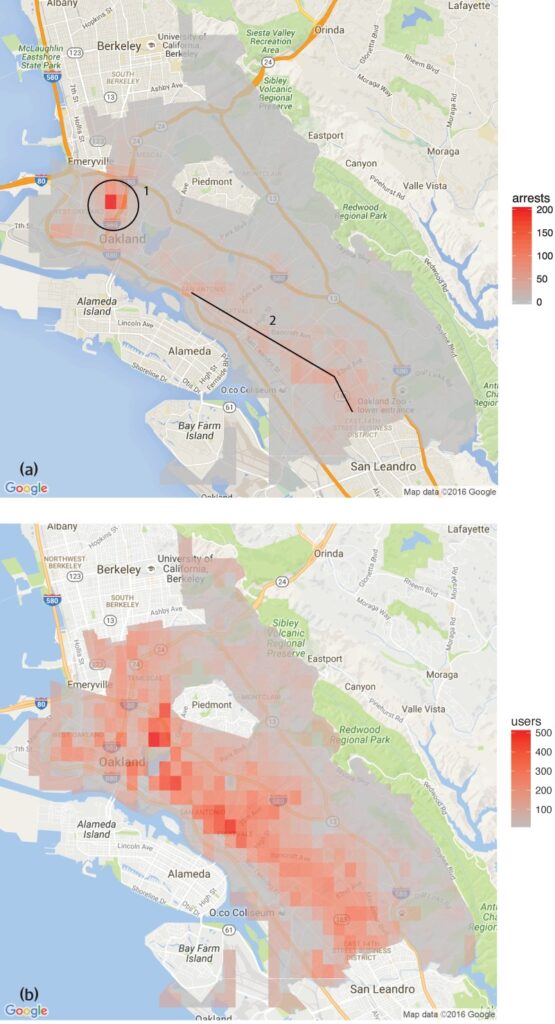

En studie som genomfördes av Dataanalysgruppen för mänskliga rättigheter fann att programvaran Predictive Policing som användes i Oakland, Kalifornien, riktade sig oproportionerligt mot färgade grupper, vilket vidmakthöll en cykel av överpolicering i dessa stadsdelar.

Detta återspeglar de farhågor som framförts av Metropolitan Police's verktyg för ansiktsigenkänningsom uppvisade högre felfrekvenser vid identifiering av svarta ansikten under vissa förhållanden.

Det finns också flera exempel inom sjukvården, till exempel inkonsekvenser i AI-modeller som är utformade för att hjälpa till att upptäcka hudcancer. I de flesta fall är det minoritetsgrupper och kvinnor som löper störst risk.

Shameem Ahmad, chef för Public Law Project, betonade behovet av omedelbara åtgärder och sa: "AI har en enorm potential för samhällsnytta. Vi kan till exempel göra saker mer effektiva. Men vi kan inte ignorera de allvarliga riskerna. Utan omedelbara åtgärder kan vi i sömnen gå in i en situation där ogenomskinliga automatiserade system regelbundet, eventuellt olagligt, används på livsförändrande sätt, och där människor inte kommer att kunna söka gottgörelse när dessa processer går fel."

Marion Oswald, professor i juridik vid Northumbria University, har också lyft fram inkonsekvenserna och bristen på transparens i den offentliga sektorns AI-användning och säger: "Det finns en brist på konsekvens och transparens i hur AI används i den offentliga sektorn. Många av dessa verktyg kommer att påverka många människor i deras vardag, till exempel de som ansöker om förmåner, men människor förstår inte varför de används och har inte möjlighet att ifrågasätta dem."

AI:s risker för den offentliga sektorn

Den okontrollerade tillämpningen av AI inom myndigheter och polisväsende väcker frågor om ansvarighet, transparens och partiskhet.

När det gäller Department for Work and Pensions (DWP) avslöjade The Guardians rapport fall där en algoritm stängde av människors förmåner utan en tydlig förklaring.

Parlamentsledamoten Kate Osamor sade att hennes bulgariska väljare förlorade sina bidrag på grund av ett halvautomatiskt system som flaggade deras fall för potentiellt bedrägeri, vilket belyser bristen på transparens.

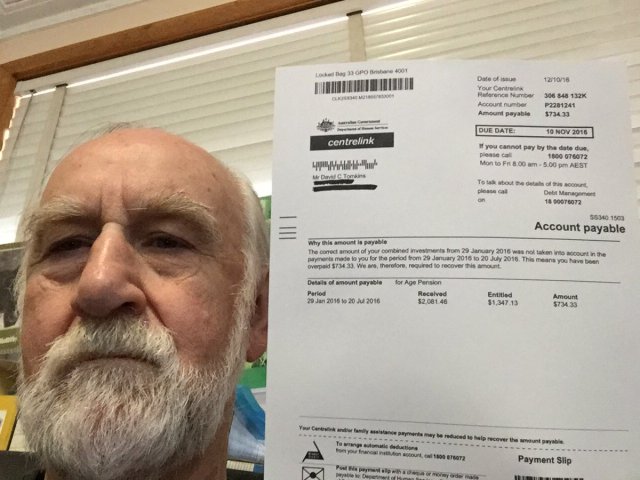

Detta påminner om "Robodebt"-skandalen i Australiendär ett automatiserat system felaktigt anklagade över 400.000 personer för bidragsbedrägeri, vilket ledde till omfattande svårigheter.

Robodebt-skandalen, som var föremål för utredningar av Commonwealth Ombudsman, rättsliga utmaningar och offentliga utredningar, visade hur stor inverkan algoritmiskt beslutsfattande har.

Den australiensiska regeringen gick med på ett förlikningsbelopp på $1,8 miljarder AUS 2021.

AI:s tillkortakommanden är inte begränsade till offentliga tjänster. Även inom näringslivet har det förekommit misslyckanden, särskilt när det gäller AI-drivna rekryteringsverktyg.

Ett anmärkningsvärt exempel är Amazons AI-rekryteringsverktyg, som visade fördomar mot kvinnliga kandidater. Systemet tränades på CV:n som skickats in till företaget under en 10-årsperiod, varav de flesta kom från män, vilket resulterade i att AI:n gynnade manliga kandidater.

Tre exempel på algoritmisk partiskhet att akta sig för

I takt med att AI och algoritmiskt beslutsfattande integreras i komplexa samhällsprocesser ökar antalet alarmerande exempel på fördomar och diskriminering.

USA:s hälso- och sjukvård och rättssystem

En studie från 2019 publicerad i Science avslöjade att en allmänt använd algoritm för hälso- och sjukvård i USA uppvisade rasbiologiska fördomar. Algoritmen var mindre benägen att hänvisa svarta människor till program som utformats för att förbättra vården för patienter med komplexa medicinska behov än deras vita motsvarigheter.

I studien förklaras varför: "Bias uppstår eftersom algoritmen använder hälsokostnader som en proxy för hälsobehov. Mindre pengar spenderas på svarta patienter som har samma behovsnivå, och algoritmen drar därför felaktigt slutsatsen att svarta patienter är friskare än lika sjuka vita patienter."

Ett annat viktigt exempel är användningen av AI i förutseende polisarbete och rättsliga påföljder. Verktyg som Profilering av alternativa påföljder för kriminalvårdare (COMPAS) har använts för att bedöma risken för att den tilltalade ska återfalla i brott.

Undersökningar har visat att dessa verktyg kan vara partiska mot afroamerikanska åtalade och ge dem högre riskpoäng än deras vita motsvarigheter. Detta väcker frågor om rättvisan och opartiskheten i AI-assisterat rättsligt beslutsfattande.

Ansiktsigenkänning i Brasilien

Den Smart Sampa-projekt i São Pauloi Brasilien, var en viktig milstolpe när det gäller att integrera AI och övervakning i stadsmiljöer - något som tidigare bara varit vanligt i Kina.

Fram till 2024 är målet att installera upp till 20.000 kameror i São Paulo och integrera lika många tredjeparts- och privata kameror i en enda plattform för videoövervakning. Detta nätverk kommer att övervaka offentliga platser, vårdinrättningar och skolor och granska innehåll i sociala medier som är relevant för den offentliga förvaltningen.

Smart Sampa utlovar ökad säkerhet och förbättrade offentliga tjänster, men experter varnar för att det kan förvärra befintliga samhällsproblem, särskilt strukturell rasism och ojämlikhet.

Över 90% av de personer som arresteras i Brasilien baserat på ansiktsigenkänning är svarta. São Paulos initiativ riskerar att vidmakthålla denna trend och ytterligare marginalisera den svarta befolkningen, som utgör 56% av Brasiliens befolkning.

Tekniker för ansiktsigenkänning identifierar ofta mörkare hudtoner felaktigt, delvis på grund av att bildtekniken underpresterar för mörkare hudtoner och delvis på grund av att träningsdataset inte är representativa.

Fernanda Rodrigues, advokat med inriktning på digitala rättigheter, betonade risken för falska positiva resultat och den påföljande risken för massfängslanden av svarta personer.

Rodrigues sa: "Förutom riskerna för att informationen som matas till dessa plattformar kanske inte är korrekt och att själva systemet kan misslyckas, finns det ett problem som föregår tekniska konsekvenser, nämligen rasism."

"Vi vet att straffsystemet i Brasilien är selektivt, så vi kan dra slutsatsen att [användning av övervakning med ansiktsigenkänning] handlar om att öka riskerna och skadorna för den här befolkningen", tillade hon.

Integritetsfrågorna är också av största vikt. Kritiker hävdar att Smart Sampa kan komma att inkräkta på grundläggande mänskliga rättigheter, inklusive integritet, yttrandefrihet, mötesfrihet och föreningsfrihet. Projektets ogenomskinliga karaktär komplicerade saken ytterligare, med begränsad medverkan från allmänheten under samrådsfasen.

Smart Sampa har inte stått oemotsagd. Allmänna åklagare har utrett och människorättsorganisationer har inlett rättsliga åtgärder för att stoppa tekniken.

Den nederländska systemriskindikationen (SyRI)

År 2022 granskade distriktsdomstolen i Haag den nederländska regeringens användning av Systemriskindikation (SyRI)en algoritm som är utformad för att upptäcka potentiellt socialbidragsbedrägeri.

SyRI var tänkt att effektivisera identifieringen av välfärdsbedrägerier genom att sammanställa data från olika myndighetsdatabaser och använda riskindikatorer för att skapa profiler av potentiella bedragare. Misstänkta beslut och bristande transparens fick dock varningsklockorna att ringa, vilket ledde till en rättslig prövning av en koalition av organisationer i det civila samhället.

De klagande hävdade att SyRI bröt mot olika internationella och europeiska lagar om mänskliga rättigheter. De ifrågasatte också lagligheten, nödvändigheten och proportionaliteten i algoritmens tillämpning.

Haag tingsrätt slog fast att den lagstiftning som styr SyRI och dess tillämpning inte uppfyller nödvändiga krav på mänskliga rättigheter. Domstolen framhöll bristen på transparens och risken för diskriminerande effekter, och betonade behovet av lämpliga rättsliga garantier vid implementering av sådan teknik.

Fallet har uppmärksammats som ett av de första som behandlar AI:s påverkan på mänskliga rättigheter i den offentliga sektorn, och belyser behovet av transparens, ansvarsskyldighet och robusta rättsliga ramverk.

Transparenta och rättvisa tester av verktyg är av yttersta vikt

I kölvattnet av den senaste tidens rättsliga utmaningar och offentliga granskning av algoritmiskt beslutsfattande i statlig verksamhet har kravet på transparenta tester av AI-verktyg blivit alltmer angeläget.

För att säkerställa ansvarsskyldighet, förhindra diskriminering och upprätthålla allmänhetens förtroende är det viktigt att införa rigorösa och öppna testprotokoll.

Transparenta tester möjliggör en omfattande förståelse för hur dessa algoritmer fungerar, vilka data de använder och vilka beslutsprocesser de följer. Detta är avgörande för att identifiera potentiella fördomar, felaktigheter eller diskriminerande metoder som är inbäddade i systemet.

Rigorösa testförfaranden går dock stick i stäv med AI:s löfte om snabbverkande effektivitet.

I Storbritanniens fall har premiärminister Rishi Sunaks "Innovationsvänlig" hållningDet ger kanske inte tillräckligt med utrymme för omfattande testförfaranden. Dessutom finns det få - om ens några - överenskomna processer för att testa AI-verktyg innan de distribueras för allmän användning.

Detta scenario återspeglas över hela världen. Den snabbt ökande användningen av AI får inte ske på bekostnad av granskning och analys.