AI genomsyrar livet för miljontals människor världen över, men trots den stora spridningen visar sig tekniken vara svår att tjäna pengar på i takt med att kostnaderna ökar.

Generativa AI-verktyg som ChatGPT är kostsamma att köra och kräver avancerade servrar, dyra GPU:er och omfattande kringutrustning som slukar mycket kraft.

Dylan Patel från SemiAnalysis är i stort sett obekräftad, men berättade informationen att OpenAI påstås förskingra vissa $700.000 per dag för att driva sina modeller och redovisade förluster på nästan $500 miljoner 2022.

John Hennessy, ordförande för Googles moderbolag Alphabet, sa att en enda prompt på Bard kostar upp till 10 gånger mer än en Google-sökningoch analytiker tror att Google kommer att dra på sig miljarder i AI-relaterade utgifter under de kommande åren.

2023 har fungerat som ett testområde för intäktsgenerering från AI. Teknikjättar som Microsoft, Google och Adobe, bland andra, prövar en mängd olika metoder för att skapa, marknadsföra och prissätta sina AI-erbjudanden.

De flesta kommersiella modeller som ChatGPT, Bard och Anthropics Claude 2 begränsar redan användarna till ett visst antal uppmaningar per timme eller dag, inklusive betalversioner som ChatGPT Plus. Adobe sätter månatliga användningstak för sina Firefly-modeller.

AI:s enorma kostnader drabbar även företag. Adam Selipsky, VD för Amazon Web Services (AWS), kommenterade de oöverkomliga kostnaderna för företagsanvändare som vill bygga AI-arbetsbelastningar: "Många av de kunder jag har pratat med är missnöjda med den kostnad de ser för att köra några av dessa modeller."

Chris Young, Microsofts chef för företagsstrategi, konstaterade att det fortfarande är tidigt för företag som vill utnyttja nuvarande AI-modeller och sa: "Det kommer att ta tid för företag och konsumenter att förstå hur de vill använda AI och vad de är villiga att betala för det."

Han tillade: "Vi är helt klart på en plats där vi nu måste översätta spänningen och intresset till verklig adoption."

AI-modeller vs programvara

AI erbjuder inte samma ekonomi som konventionell programvara, eftersom det krävs specifika beräkningar för varje uppgift.

När användare frågar en modell som ChatGPT söker den efter mönster och sekvenser från träningsdata i den neurala nätverksarkitekturen och beräknar ett specifikt svar. Varje interaktion drar energi, vilket leder till löpande kostnader.

Följaktligen ökar kostnaderna i takt med att användningen ökar, vilket utgör en utmaning för företag som erbjuder AI-tjänster till fasta priser.

Microsoft har till exempel nyligen samarbetat med OpenAI för att introducera GitHub Copilot, som riktar sig till programmerare och utvecklare.

Hittills har den höga driftskostnaden inneburit att den inte har varit lönsam. Under årets första månader tog Microsoft ut en prenumeration på $10 per månad för denna AI-assistent och ådrog sig en genomsnittlig förlust på mer än $20 per månad för varje användare. Vissa användare åsamkade förluster på upp till $80 per månad, vilket avslöjades av en källa till WSJ.

Microsofts Copilot-svit för Microsoft 365 (som förvirrande nog heter samma sak som GitHub-verktyget) planerar att ta ut $30 extra per månad. Det här verktyget erbjuder funktioner som att självständigt skriva e-postmeddelanden, skapa PowerPoint-presentationer och skapa Excel-kalkylblad.

På samma sätt kommer Google också att lansera en AI-assistentfunktion för sina arbetsplatsverktyg, vilket innebär en extra månadsavgift på $30 utöver befintliga avgifter.

Både Microsoft och Google satsar på en fast månadsavgift och hoppas att de ökade avgifterna ska kompensera för de genomsnittliga kostnaderna för att driva dessa AI-verktyg.

Även om $30/månad kan verka överkomligt i vissa mer utvecklade västländer, omfattar dessa prismodeller inte en stor del av världens befolkning.

När ChatGPT Plus lanserades på den indiska marknaden, till exempel, klagade många på att det var alldeles för dyrt, vilket utgör en betydande del av den genomsnittliga månadslönen för $330. Om miljarder användare inte får tillgång till AI kan det stå utvecklare dyrt när de marknadsför verktyg till allmänheten.

Kostnaden är knappast heller oväsentlig för dem som bor i mer välbeställda länder, och undersökningar visar att prenumerationer är bland det första som försvinner när människor försöker minska sina utgifter.

Varför är AI så svårt att tjäna pengar på?

AI skapar ett tomrum mellan utvecklarnas till synes oändliga visioner och de begränsade resurser som finns tillgängliga för att förverkliga dem.

OpenAI:s VD Sam Altman hävdar att en futuristisk AI-inbäddad värld helt enkelt är "oundviklig", där intelligenta maskiner lever bredvid oss och gör vad vi ber om, där människor lever i hundratals år eller odödliga, och där AI inbäddad i våra hjärnor hjälper oss att utföra komplexa uppgifter genom att vi tänker själva.

Han är verkligen inte ensam om det, och Inflections VD Mustafaya Suleman publicerade nyligen sin bok "The Coming Wave", där han jämför AI med den kambriska explosionen för 500 miljoner år sedan som ledde till den snabbaste explosionen i evolutionen som någonsin bevittnats på vår planet.

Generativ AI kommer att explodera, med intäkter som förväntas överstiga $1 biljon år 2032. Från var det började till var det är nu och var det kommer att vara är häpnadsväckande ... varje bransch kommer att omvandlas till det bättre. pic.twitter.com/0licQGfphn

- Mustafa Suleyman (@mustafasuleyman) 20 oktober 2023

Ambitioner driver idéer, men pengar driver teknikindustrin. Forskning och utveckling inom AI är kostsamt, så branschledare som OpenAI, Google och Facebook investerar kraftigt för att ligga steget före.

AI-företag lockade till sig investeringar på hela $94 miljarder 2021, med flera finansieringsrundor som nådde $500 miljoner eller mer. År 2023 ökade investeringarna i nystartade företag till Antropisk och Böjning passerar $1 miljardstrecket.

AI-specialister kräver höga löner, ofta i miljonklassen, på grund av den hårda konkurrensen, och modellerna kräver regelbunden finjustering och stresstestning, vilket ökar de löpande kostnaderna.

Det tillkommer också kostnader för datacenter och underhåll, särskilt svalkandeeftersom sådan hårdvara blir varm och riskerar att gå sönder om den inte hålls vid optimal temperatur.

I vissa fall har GPU:er en kort livslängd på mindre än fem år och kräver ofta specialiserat underhåll.

Strategier för intäktsgenerering från AI

Mot bakgrund av dessa utmaningar, hur tar teknikföretagen sig an utmaningen att tjäna pengar på AI?

Förbättrad produktivitet

Företagen kan dra nytta av AI genom att avsevärt öka samhällets nettoproduktivitet. Genom att automatisera repetitiva uppgifter kan företagen låta personalen fokusera på mer värdeskapande funktioner på högre nivå.

Detta kommer att hjälpa dem att få tillgång till både privata och offentliga medel. DeepMind samarbetar till exempel med National Health Service (NHS) i Storbritannien, och teknikföretag samarbetar med regeringar för att hantera klimatförändringarna.

AI-driven produktivitet kan dock påverka teknikföretagens andra intäktsströmmar. Till exempel har Googles annonsintäkterna minskar i takt med att AI drar bort trafik från sökmotorn. I år ökade Googles intäkter från YouTube-annonser minska med 2,6%och intäkterna från annonsnätverken minskar med 8,3%, vilket är en minskning utan motstycke.

Försäljning av hårdvara

Träning och hosting av AI-modeller kräver specialiserad och avancerad hårdvara. GPU:er är oumbärliga för att köra sofistikerade AI-algoritmer, vilket gör dem till en lukrativ komponent i AI-ekosystemet.

Branschledaren Nvidia är den stora vinnaren här, med ett börsvärde på över $1 biljon, men även andra tillverkare av AI-hårdvara med lägre nyckeltal har också dragit nytta av det.

Prenumerationer

Att erbjuda AI-förbättringar som en del av prenumerationspaket är ett sätt att generera intäkter från offentliga användare och företag som inte vill eller behöver gå API-vägen.

ChatGPT Plus är den mest prenumererade AI-tjänsten globalt, men det saknas information som beskriver hur mycket intäkter den genererar.

OpenAI lanserade sitt Enterprise-variant i år för att stärka abonnemangsintäkterna och förklarade att bolaget är på väg mot $1 miljard i intäkter under nästa år.

API:er

Företag som OpenAI använder en tokenbaserad faktureringsmetod för företags- och affärsanvändare för sina API:er.

Detta system säkerställer att användarna faktureras baserat på den faktiska beräkningsbelastningen för deras förfrågningar, vilket garanterar rättvisa och transparens.

Prismodellerna för API:er passar ett brett spektrum av användare, från dem som gör sporadiska lättviktiga anrop till tunga användare med intensiva uppgifter.

AI som en inbyggd funktion

Vissa företag integrerar AI-funktioner i sina produkter utan att omedelbart ta extra betalt. Denna strategi syftar till att först öka en produkts inneboende värde.

Med tiden, när användarna har integrerat AI-funktionerna i sina arbetsflöden och insett värdet av dem, är det mer sannolikt att de accepterar en efterföljande prishöjning. AI måste dock leverera progressiva fördelar om kostnaderna stadigt ska öka.

Kostnaderna för AI-utbildning med öppen källkod blir allt billigare

Det finns en parallell diskussion här - varför ska någon betala för AI när de aldrig äger det?

Vissa - som AI:s "gudfader" Yann LeCun - hävdar att AI bör bli en del av vår offentliga infrastruktur och betonar behovet av att utvecklare bygger modeller med öppen källkod som är billiga och lätta att få tillgång till.

En NYT-artikel om debatten kring huruvida LLM:s basmodeller ska vara slutna eller öppna.

Meta argumenterar för öppenhet, med början med lanseringen av LLaMA (för icke-kommersiell användning), medan OpenAI och Google vill hålla saker stängda och proprietära.

De hävdar att öppenhet kan vara...

- Yann LeCun (@ylecun) 18 maj 2023

AI-lösningar blir allt viktigare för företagen, men många har inte budget för att utveckla egna modeller från grunden. Traditionellt sett har de vänt sig till API:er från nya AI-startups eller hyllsystem.

Men i takt med att utbildningskostnaderna minskar och kraven på datasekretess ökar, blir det allt vanligare att samarbeta med leverantörer som specialiserar sig på att anpassa både privata modeller och modeller med öppen källkod.

Naveen Rao, VD och medgrundare av MosaicML, förklarade för The Register att modeller med öppen källkod är lockande eftersom de är billigare, mer flexibla och gör det möjligt för företag att hålla arbetsbelastningar privata.

MosaicML lanserade en serie LLM:er (Large Language Models) med öppen källkod baserade på MPT-7B-arkitekturen. Till skillnad från många andra LLM:er är den här modellen kommersiellt gångbar för den breda massan.

Rao berättade om bakgrunden till den här modellen och sa: "Det finns definitivt ett stort intresse för den här typen av saker, och vi gjorde det av flera skäl." Han tillade: "Ett var att vi ville ha en modell där ute som har tillstånd för kommersiell användning. Vi vill inte kväva den typen av innovation."

Rao påpekade att "om en kund kom till oss och sa att han skulle träna den här modellen kan vi göra det för $200.000 och vi tjänar fortfarande pengar på det".

MosaicML ger också företag verktyg för att effektivt kunna hosta sina anpassade modeller på molnplattformar. "Deras data delas inte med det nystartade företaget, och de äger modellens vikter och dess IP", bekräftar Rao.

Rao tog också upp begränsningarna med kommersiella API:er och sa: "Kommersiella API:er är ett bra verktyg för prototyper. Jag tror att med tjänster av typen ChatGPT kommer människor att använda dem för underhållning och kanske för personliga saker, men inte för företag. Data är en mycket viktig vallgrav för företag."

Rao lyfte vidare fram kostnaderna för intern arkitektur och sa: "GPU:er misslyckas faktiskt ganska ofta", "Om en nod går ner och det krävs ett manuellt ingripande, det tog dig fem timmar [att fixa], har du just bränt $10.000 utan arbete, eller hur?"

Han tog också upp den hotande frågan om brist på chip i branschen"Vi kommer att leva i en värld av GPU-brist i minst två år, kanske fem."

Om företag kan utnyttja AI med öppen källkod för att träna sina lågkostnadsmodeller med total datasuveränitet och kontroll, utgör det en utmaning för offentlig AI som ChatGPT.

AI:s hotande flaskhalsar?

Förutom GPU-bristen som Rao lyfter fram är ett annat hinder för AI-intäktsgenerering branschens kraftigt ökande energibehov.

A nyligen genomförd studie förutspår att AI-industrins energiförbrukning år 2027 kan komma att motsvara en liten nations energiförbrukning.

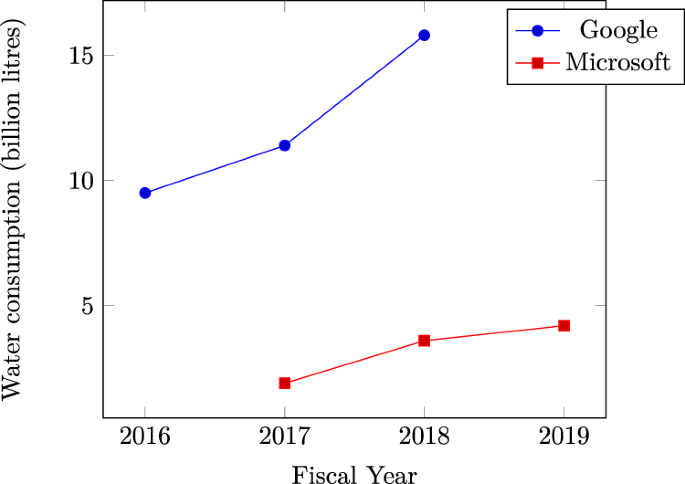

Microsofts Vattenförbrukningen i datacenter skjuter i höjden bekräftar AI:s enorma törst efter naturresurser. Bevis tyder på att den senaste tidens ökningar av vattenanvändningen hos teknikjättar som Microsoft och Google beror på intensiva AI-relaterade arbetsbelastningar.

På en bredare skala överstiger den kumulativa energin som används av datacenter redan 1% av den globala elförbrukningen, enligt Internationella energiorganet (IEA).

Om energibehoven fortsätter att öka kan AI-företagen tvingas rikta in sig på att utveckla mer effektiva metoder för modellträning, vilket kan skada teknikens utveckling på kort sikt.

Konkurrerande berättelser

Den framväxande AI-industrin är fortfarande ung och dess framtida inriktning är exceptionellt svår att förutse.

Centrala personer inom AI erkänner att deras förutfattade meningar inte alltid stämmer överens med verkligheten.

Sam Altman medgav till exempel i Joe Rogans podcast att han hade fel om AI:s utvecklingskurva och beskrev att vägen till att förverkliga högintelligenta former av AI kommer att vara detaljerad snarare än explosiv.

Å ena sidan visar sig AI vara svårt att tjäna pengar på, vilket skapar tvivel om huruvida den inledande hypen kommer att avta, vilket leder till en långsammare process för att mogna tekniken.

Å andra sidan kan industrin redan ha gjort tillräckliga framsteg för att driva AI mot en "singularitet" där den överträffar mänsklig kognition.

Under de närmaste åren, om mänskligheten gör framsteg inom viktiga områden som energiproduktion och att bygga AI-hårdvara och arkitektur med låg effekt - och framsteg har gjorts där i år - då kan tekniken undanröja flaskhalsar på kort sikt och fortsätta sin rasande utvecklingstakt.