Exakt hur våra hjärnor bearbetar och formulerar språk är fortfarande till stor del ett mysterium. Forskare vid Meta AI hittade ett nytt sätt att mäta hjärnvågor och avkoda de ord som är associerade med dem.

Personer med kraftigt begränsad motorik, som ALS-sjuka, har särskilt svårt att kommunicera. Det är svårt att föreställa sig hur frustrerande det är för en person som Stephen Hawking att mödosamt konstruera en mening med ögonrörelser eller ryckningar i en kindmuskel.

Mycket forskning har gjorts för att avkoda tal från hjärnaktivitetmen de bästa resultaten beror på invasiva implantat för hjärna och dator.

Meta AI:s forskare använde magneto-encefalografi (MEG) och elektroencefalografi (EEG) för att registrera hjärnvågorna hos 175 frivilliga medan de lyssnade på korta berättelser och isolerade meningar.

De använde en förtränad talmodell och kontrastiv inlärning för att identifiera vilka hjärnvågsmönster som var associerade med specifika ord som försökspersonerna lyssnade på.

"Avkodning av taluppfattning från icke-invasiva hjärninspelningar",

under ledning av den ende @honualx

har precis publicerats i det senaste numret av Nature Machine Intelligence:- öppet tillgängligt dokument: https://t.co/1jtpTezQzM

- fullständig utbildningskod: https://t.co/Al2alBxeUC pic.twitter.com/imLxRjRQ6h- Jean-Rémi King (@JeanRemiKing) 5 oktober 2023

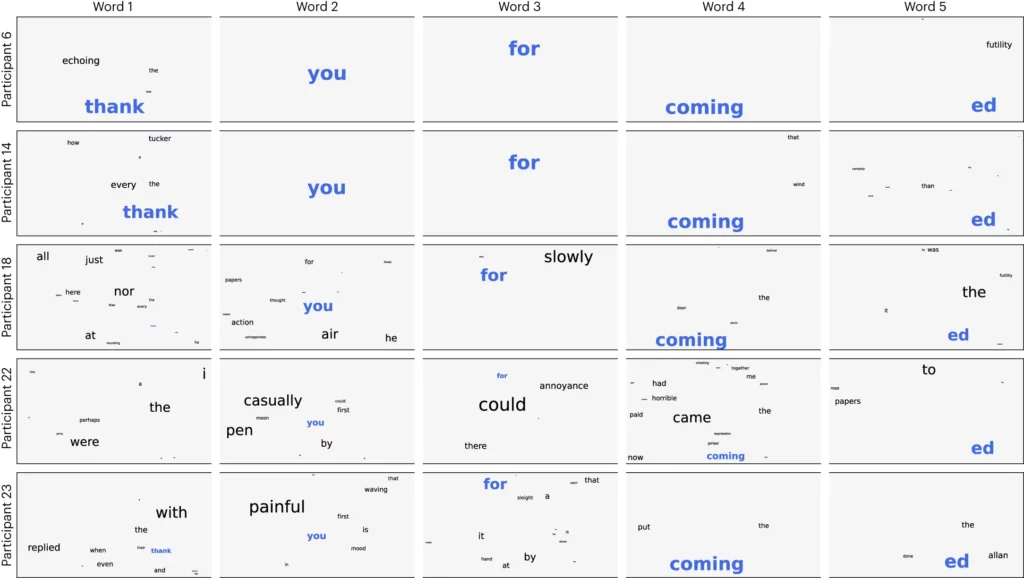

Forskarna delade upp ljudet i 3-sekunderssegment och testade sedan sin modell för att se om den kunde identifiera vilket av de 1.500 segmenten som volontären lyssnade på. Modellen förutspådde ett slags ordmoln där det mest sannolika ordet gavs störst vikt.

De uppnådde en noggrannhet på 41% i genomsnitt och 95,9% noggrannhet med sina bästa deltagare.

Forskningen visar att det är möjligt att få en ganska god uppfattning om vilket tal en person hör, men nu måste processen vändas för att vara användbar. Vi måste mäta deras hjärnvågor och veta vilket ord de tänker på.

I artikeln föreslås att ett neuralt nätverk tränas medan försökspersoner producerar ord genom att tala eller skriva. Den generella modellen skulle sedan kunna användas för att tolka hjärnvågor och de associerade ord som en ALS-drabbad person tänkte på.

Forskarna kunde identifiera talsegment från en begränsad förutbestämd uppsättning. För att kunna kommunicera på rätt sätt måste man kunna identifiera många fler ord. Att använda en generativ AI för att förutsäga nästa mest sannolika ord som en person försöker säga skulle kunna hjälpa till med det.

Även om processen var icke-invasiv kräver den fortfarande att man är ansluten till en MEG-enhet. Tyvärr var resultaten från EEG-mätningarna inte bra.

Forskningen visar att AI så småningom kan användas för att hjälpa röstlösa personer, som ALS-patienter, att kommunicera. Genom att använda en förtränad modell undviks också behovet av mer noggrann träning ord för ord.

Meta AI släppte modellen och data offentligt så förhoppningsvis kommer andra forskare att bygga vidare på deras arbete.