Samtidigt som diskussionerna sväller kring riskerna med AI-system kan vi inte bortse från den belastning som tekniken innebär för världens redan hårt ansträngda energi- och vattenförsörjning.

Komplexa projekt inom maskininlärning (ML) är beroende av en konstellation av tekniker, inklusive träningshårdvara (GPU:er) och hårdvara för hosting och driftsättning av AI-modeller.

Även om effektiva tekniker och arkitekturer för AI-träning lovar att minska energiförbrukningen har AI-boomen bara börjat, och big tech ökar investeringarna i resurskrävande datacenter och molnteknik.

I takt med att klimatkrisen fördjupas är det viktigare än någonsin att hitta en balans mellan tekniska framsteg och energieffektivitet.

Energiutmaningar för AI

AI:s energiförbrukning har ökat i och med tillkomsten av komplexa, beräkningskrävande arkitekturer som neurala nätverk.

Till exempel ryktas GPT-4 vara baserad på 8 modeller med 220 miljarder parametrar vardera, vilket ger totalt cirka 1,76 biljoner parametrar. Inflection håller för närvarande på att bygga ett kluster av 22.000 avancerade Nvidia-chipsom kan kosta omkring $550.000.000 till ett ungefärligt detaljhandelspris på $25.000 per kort. Och det är bara för chipen.

Varje avancerad AI-modell kräver enorma resurser för att tränas, men det har varit svårt att förstå den verkliga kostnaden för AI-utveckling fram till nyligen.

A 2019 års studie från University of Massachusetts at Amherst undersökte resursförbrukningen i samband med Deep Neural Networks (DNN).

Vanligtvis kräver dessa DNN att datavetare manuellt utformar eller använder Neural Architecture Search (NAS) för att hitta och träna ett specialiserat neuralt nätverk från grunden för varje unikt fall.

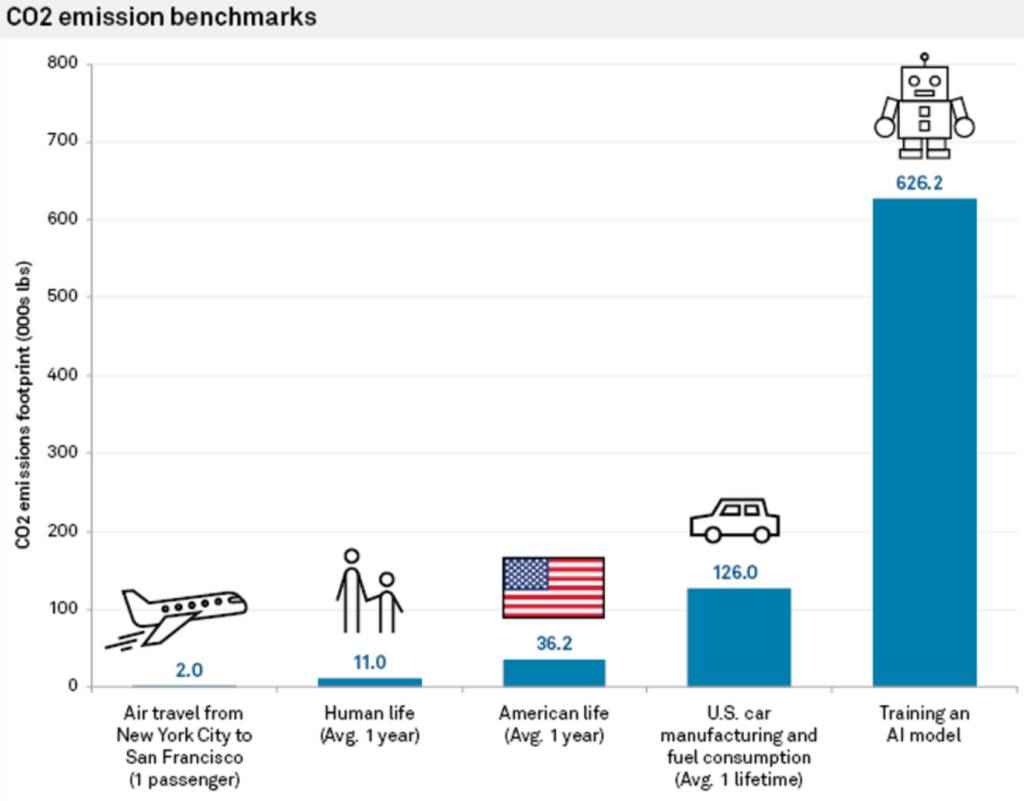

Detta tillvägagångssätt är inte bara resurskrävande utan har också ett betydande koldioxidavtryck. I studien upptäcktes att träning av ett enda stort Transformer-baserat neuralt nätverk, byggt med NAS - ett verktyg som ofta används vid maskinöversättning - genererade cirka 626.000 pund koldioxid.

Detta motsvarar ungefär gasutsläppen från 5 bilar under hela deras livstid.

Carlos Gómez-Rodríguez, datavetare vid universitetet i A Coruña i Spanien, kommenterade studien: "Även om många av oss förmodligen har tänkt på det här på en abstrakt, vag nivå, visar siffrorna verkligen hur stort problemet är", och tillade: "Varken jag eller andra forskare som jag har diskuterat dem med trodde att miljöpåverkan var så stor."

Energikostnaderna för att träna modellen är bara baslinjer - den minsta mängd arbete som krävs för att få en modell i drift.

Som Emma Strubell, doktorand vid University of Massachusetts, säger: "Att träna en enda modell är den minsta mängd arbete du kan göra."

MIT:s "en gång för alla"-strategi

Forskare vid MIT föreslog senare en lösning på detta problem: den "En gång för alla"-metoden (OFA).

Forskarna beskriva frågan med konventionell träning av neurala nätverk: "Att utforma specialiserade DNN för varje scenario är ingenjörskrävande och beräkningsmässigt dyrt, antingen med människobaserade metoder eller NAS. Eftersom sådana metoder måste upprepa nätverksdesignprocessen och träna om det designade nätverket från grunden för varje fall, växer deras totala kostnad linjärt när antalet utplaceringsscenarier ökar, vilket kommer att leda till överdriven energiförbrukning och koldioxidutsläpp."

Med MIT:s OFA-paradigm tränar forskarna ett enda neuralt nätverk för allmänna ändamål, från vilket olika specialiserade undernätverk kan skapas. OFA-processen kräver ingen ytterligare utbildning för nya undernätverk, vilket minskar de energikrävande GPU-timmar som behövs för modellutbildning och sänker CO2-utsläppen.

Utöver miljöfördelarna ger OFA-metoden även betydande prestandaförbättringar. I interna tester presterade modeller som skapats med OFA-metoden upp till 2,6 gånger snabbare på edge-enheter (kompakta IoT-enheter) än modeller som skapats med NAS.

MIT:s OFA-metod uppmärksammades vid 4th Low Power Computer Vision Challenge 2019 - ett årligt evenemang som arrangeras av IEEE och som främjar forskning för att förbättra energieffektiviteten i system för datorseende (CV).

MIT-teamet tog hem förstapriset och arrangörerna av evenemanget berömde det: "De här teamens lösningar överträffar de bästa lösningarna i litteraturen."

Den 2023 Utmaning för datorseende med låg effekt tar för närvarande emot bidrag fram till den 4 augusti.

Molntjänstens roll för AI:s miljöpåverkan

Förutom utbildningsmodeller behöver utvecklare enorma molnresurser för att hosta och distribuera sina modeller.

Stora teknikföretag som Microsoft och Google ökar investeringarna i molnresurser under 2023 för att hantera de ökande kraven på AI-relaterade produkter.

Cloud computing och tillhörande datacenter har enorma resursbehov. Från och med 2016, föreslagna uppskattningar att datacenter världen över stod för cirka 1% till 3% av den globala elförbrukningen, vilket motsvarar energianvändningen i vissa små länder.

Datacenters vattenavtryck är också kolossalt. Stora datacenter kan förbruka miljontals liter vatten varje dag.

2020 rapporterades det att Googles datacenter i South Carolina fick tillstånd att använda 549 miljoner liter vattenvilket är nästan dubbelt så mycket som två år tidigare. Ett datacenter på 15 megawatt kan förbruka upp till 360.000 liter vatten per dag.

År 2022, Google avslöjade att dess globala datacenterflotta förbrukade cirka 4,3 miljarder liter vatten. De framhåller dock att vattenkylning är betydligt effektivare än andra tekniker.

Stora teknikföretag har alla liknande planer för att minska sin resursanvändning, till exempel Google, som uppnådde sitt mål att matcha 100% av sin energianvändning med inköp av förnybar energi 2017.

Nästa generations AI-hårdvara modellerad efter den mänskliga hjärnan

AI är oerhört resurskrävande, men våra hjärnor drivs av endast 12 watts effekt - kan en sådan energieffektivitet återskapas i AI-teknik?

Till och med en stationär dator drar över 10 gånger mer ström än den mänskliga hjärnan, och kraftfulla AI-modeller kräver miljontals gånger mer ström. Att bygga AI-teknik som kan replikera effektiviteten hos biologiska system skulle förändra branschen helt och hållet.

För att vara rättvis mot AI tar denna jämförelse inte hänsyn till det faktum att den mänskliga hjärnan har "tränats" under miljontals år av evolution. Dessutom är AI-system och biologiska hjärnor duktiga på olika uppgifter.

Att bygga AI-hårdvara som kan bearbeta information med liknande energiförbrukning som biologiska hjärnor skulle ändå möjliggöra autonoma biologiskt inspirerade AI:er som inte är kopplade till skrymmande kraftkällor.

Under 2022 har ett team av forskare från Indian Institute of Technology, Bombay, tillkännagav utvecklingen av ett nytt AI-chip som är modellerat efter den mänskliga hjärnan. Chipet arbetar med spiking neural networks (SNN), som efterliknar den neurala signalbehandlingen i biologiska hjärnor.

Hjärnan består av 100 miljarder små nervceller som är kopplade till tusentals andra nervceller via synapser och överför information genom koordinerade mönster av elektriska spikar. Forskarna byggde artificiella nervceller med extremt låg energi och utrustade SNN med band-till-band-tunnelström (BTBT).

"Med BTBT laddar kvanttunnelströmmen upp kondensatorn med ultralåg ström, vilket innebär att det krävs mindre energi", förklarar Udayan Ganguly från forskargruppen.

Enligt professor Ganguly uppnår deras metod "5.000 gånger lägre energi per spike på en liknande yta och 10 gånger lägre standby-ström på en liknande yta och energi per spike" jämfört med befintliga toppmoderna neuroner som implementerats i SNN i hårdvara.

Forskarna har framgångsrikt demonstrerat sin metod i en taligenkänningsmodell som inspirerats av hjärnans hörselbark. SNN kan förbättra tillämpningar på kompakta enheter som mobiltelefoner och IoT-sensorer.

Teamet har som mål att utveckla en "neurosynaptisk kärna med extremt låg effekt och en inlärningsmekanism i realtid på chipet, vilket är nyckeln till autonoma biologiskt inspirerade neurala nätverk".

AI:s miljöpåverkan förbises ofta, men om man löser problem som energiförbrukning för AI-chip kommer man också att öppna nya vägar för innovation.

Om forskarna kan modellera AI-tekniken efter biologiska system, som är exceptionellt energieffektiva, skulle detta möjliggöra utvecklingen av autonoma AI-system som inte är beroende av riklig strömförsörjning och datacenteranslutning.