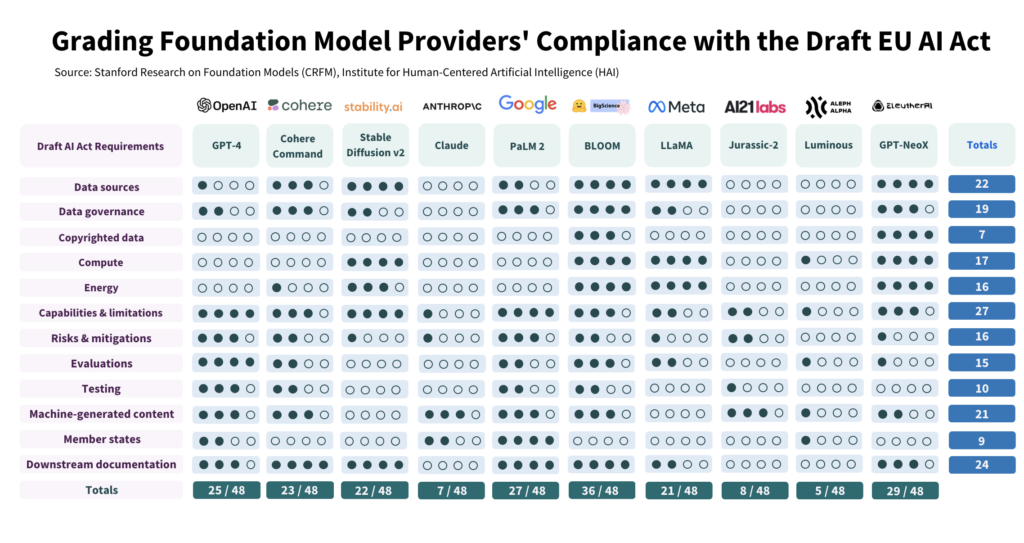

AI-forskare vid Stanford utvärderade 10 ledande AI-modellers efterlevnad av EU:s föreslagna AI-lag och fann stora variationer, med generellt sett svaga resultat över hela linjen.

Studien har kritiskt granskat 10 AI-modeller mot 12 kriterier som anges i EU:s lagförslag och upptäckt stora variationer i efterlevnaden, där ingen modell uppfyller alla kriterier.

Studien belyser klyftan mellan AI-lagens förväntningar och nuvarande styrningsinsatser bland ledande AI-utvecklare.

För att följa lagen måste utvecklarna avsevärt förbättra sin transparens och sina strategier för riskreducering, som i vissa fall saknas nästan helt.

Hur studien genomfördes

Författarna genomförde en detaljerad studie av AI-lagen och tog fram 22 krav.

Av dessa valde de ut 12 som på ett meningsfullt sätt kunde utvärderas med hjälp av offentlig information. Därefter skapade de ett 5-gradigt kriterium för vart och ett av dessa 12 krav.

Den öppna AI-modellen BLOOM, som tagits fram av Hugging Face, var den modell som fick högst poäng med totalt 36 av 48 möjliga poäng.

Omvänt presterade Google-stödda Anthropic och det tyska AI-företaget Aleph Alpha betydligt sämre, med 7 respektive 5 poäng. ChatGPT föll i mitten av paketet med 25/48.

De fyra främsta områdena för bristande efterlevnad är upphovsrättsskyddade data, energi, riskreducering och utvärdering/testning.

En av författarna, Kevin Klyman, forskare vid Stanfords Center for Research on Foundation Models, noterade att de flesta utvecklare inte avslöjar sina riskreduceringsstrategier, vilket kan vara en dealbreaker. Klyman sa: "Leverantörer avslöjar ofta inte effektiviteten i sina riskreducerande åtgärder, vilket innebär att vi inte kan säga hur riskfyllda vissa grundmodeller är."

Dessutom finns det stora variationer i de träningsdata som används för att träna modeller. EU kommer att kräva att AI-utvecklare är mer transparenta med sina datakällor, vilket 4/10 av utvecklarna misslyckas med att göra. ChatGPT fick bara 1 poäng på det området.

Öppen källkod kontra proprietära modeller

Rapporten visade också att det fanns en tydlig skillnad i efterlevnad beroende på om en modell var öppen källkod eller proprietär.

Modeller med öppen källkod fick höga poäng när det gäller redovisning av resurser och datakrav, men deras risker är till stor del odokumenterade.

Proprietära modeller är motsatsen - de är hårt testade och väldokumenterade med robusta strategier för riskreducering, men de är inte transparenta när det gäller data och teknikrelaterade mätvärden.

Eller, för att sätta fingret på det, utvecklare av öppen källkod har inte så många konkurrenshemligheter att skydda, men deras produkter är i sig mer riskfyllda eftersom de kan användas och modifieras av nästan vem som helst.

Omvänt kommer privata utvecklare sannolikt att hålla delar av sina modeller under lås och bom, men de kan visa på säkerhet och riskreducering. Till och med Microsoft, OpenAI:s huvudinvesterare, är inte helt förstå hur OpenAI:s modeller fungerar.

Vad rekommenderar studien?

Författarna till studien medger att gapet mellan EU:s förväntningar och verkligheten är alarmerande och lägger fram flera rekommendationer till beslutsfattare och modellutvecklare.

I studien rekommenderas EU:s beslutsfattare:

- Förbättra och specificera parametrarna för EU:s AI-lag: Forskarna hävdar att AI-lagens tekniska språk och parametrar är underspecificerade.

- Främja öppenhet och ansvarighet: Forskare hävdar att de strängaste reglerna bör vara extremt inriktade på de allra största och mest dominerande utvecklarna, vilket bör leda till effektivare tillämpning.

- Tillhandahålla tillräckliga resurser för verkställighet: För att EU:s AI-lag ska kunna tillämpas på ett effektivt sätt bör tekniska resurser och talang göras tillgängliga för tillsynsmyndigheterna.

Studien rekommenderar globala beslutsfattare:

- Prioritera öppenhet: Forskarna betonar att transparens är avgörande och bör vara huvudfokus för politiska insatser. De menar att lärdomarna från regleringen av sociala medier visar på de skadliga konsekvenserna av bristande transparens, något som inte bör upprepas i samband med AI.

- Klargöra frågor om upphovsrätt: Gränserna för upphovsrätten för AI-träningsdata och AI-resultat är omdiskuterade. Med tanke på den låga efterlevnad som observerats när det gäller att avslöja upphovsrättsskyddade träningsdata, hävdar forskarna att juridiska riktlinjer måste ange hur upphovsrätten interagerar med träningsprocedurer och resultatet av generativa modeller. Detta inkluderar att definiera de villkor enligt vilka upphovsrätt eller licenser måste respekteras under utbildning och att fastställa hur maskingenererat innehåll kan göra intrång i upphovsrätten.

Studien ger rekommendationer till utvecklare av grundläggningsmodeller:

- Sträva efter ständiga förbättringar: Leverantörer bör konsekvent sträva efter att förbättra sin efterlevnad. Större leverantörer, som OpenAI, bör föregå med gott exempel och sprida resurser till nedströmskunder som får tillgång till deras modeller via API.

- Förespråka branschstandarder: Modellleverantörer bör bidra till att etablera branschstandarder, vilket kan leda till ett mer transparent och ansvarsfullt AI-ekosystem.

Även om det finns vissa positiva saker att hämta från de risk- och övervakningsstandarder som fastställts av ledande utvecklare som OpenAI, är bristerna inom områden som upphovsrätt långt ifrån idealiska.

När det gäller att tillämpa reglering på AI som en allomfattande kategori - Det kan visa sig vara mycket knepigt. - eftersom kommersiella modeller och modeller med öppen källkod är strukturellt olika och svåra att klumpa ihop.