Компания Nvidia представила обновленную версию суперчипа Grace Hopper Superchip (GH200), анонсированного 2 месяца назад. GH200 был разработан для питания центров обработки данных для крупномасштабной обработки ИИ.

GH200 еще не поступил в серийное производство, но уже успел получить крупное обновление в своей памяти. Секретным соусом новых чипов является модернизированная память с высокой пропускной способностью под названием HBM3e, которая способна получать доступ к данным со скоростью 5 ТБ/с.

Это на 50% лучше, чем память HBM3 в чипе, который был анонсирован в конце мая.

Nvidia подключила эту высокоскоростную память к мощным CPU и GPU на одном устройстве. Полученное увеличение скорости обработки данных позволит значительно улучшить возможности ИИ, которыми располагают нынешние центры обработки данных.

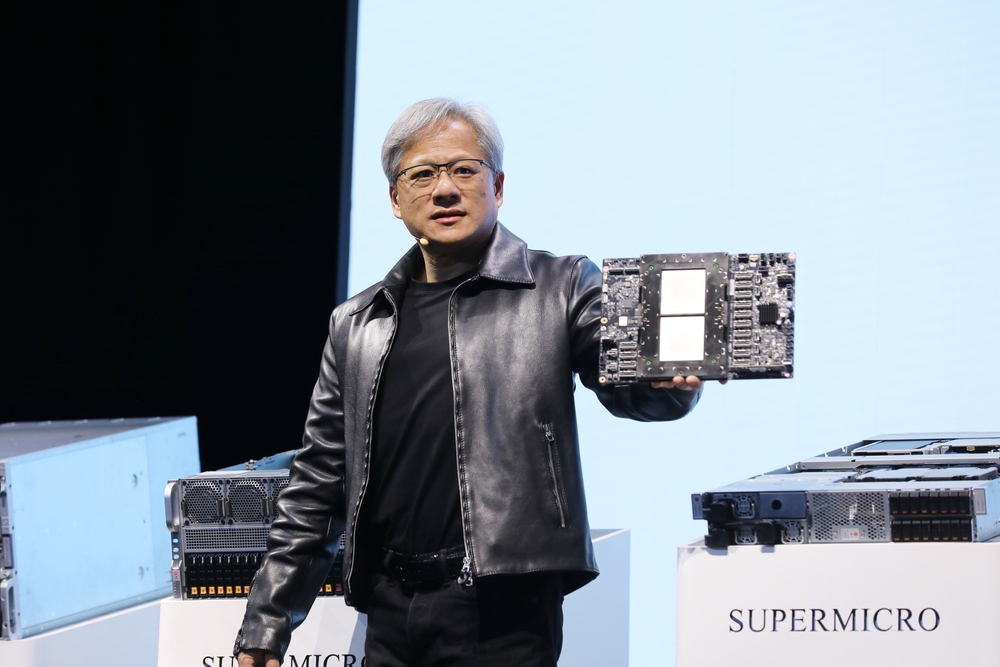

В дополнение к обновленному чипу Nvidia также анонсировала платформу GH200 Grace Hopper, которая позволяет соединить 2 чипа GH200 на одной плате.

Платформа обеспечивает восемь петафлопсов вычислений ИИ и 282 ГБ памяти HBM3e с пропускной способностью 10 ТБ/с.

Как чип Nvidia изменит центры обработки данных?

В цифрах бывает трудно разобраться. Так насколько же велика роль нового чипа и платформы?

В своей презентации генеральный директор Nvidia Дженсен Хуанг привел пример типичного центра обработки данных с 8800 процессорами x86, выполняющими различные вычислительные функции (ISO-бюджет).

Подобный центр обработки данных, в котором работает Llama 2 для выводов, запрашивается база данных векторов, а SDXL генерирует выходные данные, обойдется вам примерно в $100 млн и будет потреблять 5 МВт энергии.

Центр обработки данных площадью $100 м, использующий 2500 платформ GH200, может работать с теми же моделями в 12 раз быстрее и потреблять всего 3 МВт энергии.

Если центр обработки данных был ориентирован на выполнение очень специфического набора задач (ISO-workload), то сравнение становится еще более ошеломляющим.

Вам потребуется потратить всего $8 млн на 210 устройств GH200, сжигающих в 20 раз меньше энергии, чтобы соответствовать производительности центра обработки данных $100 млн.

Нет необходимости говорить о том, что все центры обработки данных облачных вычислений AI, которые были на стадии планирования до выхода этого релиза, вернутся к чертежной доске.

Чипы GH200 начнут выпускаться во втором квартале 2024 года и, как ожидается, отнимут много места у процессоров x86. Новый чип AMD MI300 является ближайшим конкурентом Nvidia, но его преимущество по объему памяти, похоже, будет сведено на нет обновлением в новом GH200.

Прогресс в области процессорных технологий, который мы наблюдаем, превышает Закон Мура и не показывает никаких признаков замедления. Приложения генеративного ИИ уже демонстрируют впечатляющую производительность, но, похоже, скоро они станут еще быстрее.