Ученые опубликовали результаты исследования, в котором сравнивали точность и качество резюме, составляемых LLM. Claude 3 Opus показал особенно хорошие результаты, но люди все равно имеют преимущество.

Модели искусственного интеллекта чрезвычайно полезны для обобщения длинных документов, когда у вас нет времени или желания их читать.

Роскошь растущих контекстных окон означает, что мы можем предлагать моделям более длинные документы, что ставит под сомнение их способность всегда правильно излагать факты в резюме.

Исследователи из Массачусетского университета в Амхерсте, компании Adobe, Института искусственного интеллекта Аллена и Принстонского университета, опубликовал исследование в котором пытались выяснить, насколько хорошо модели искусственного интеллекта справляются с резюмированием книжного контента (>100 тыс. записей).

ФАБЛЫ

Они выбрали 26 книг, опубликованных в 2023 и 2024 годах, и попросили разных магистрантов сделать краткое изложение текстов. Последние даты публикации были выбраны, чтобы избежать возможного загрязнения данных в исходных обучающих данных модели.

После того как модели составили резюме, они использовали GPT-4 для извлечения из них деконтекстуализированных утверждений. Затем исследователи наняли аннотаторов, прочитавших книги, и попросили их проверить утверждения на достоверность.

Полученные данные были собраны в набор данных под названием "Аннотации верности для суммирования длины книги" (FABLES). FABLES содержит 3 158 аннотаций верности на уровне утверждений в 26 повествовательных текстах.

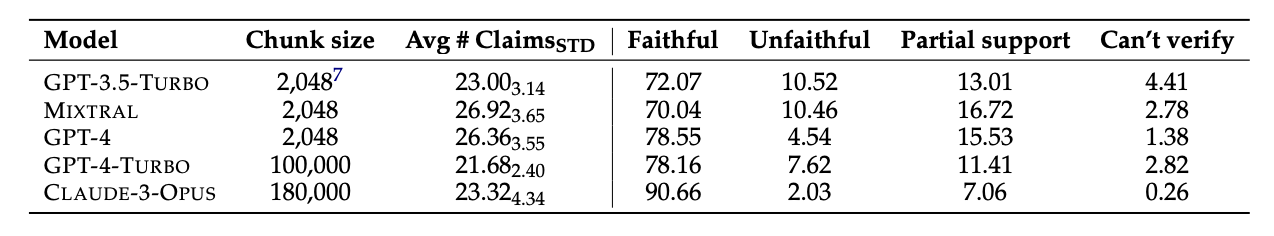

Результаты теста показали, что Claude 3 Opus - "самый верный обобщающий редактор книг со значительным отрывом": более 90% его утверждений были проверены как верные или точные.

GPT-4 занял отдаленное второе место: только 78% его утверждений были проверены на верность человеческими аннотаторами.

Трудная часть

Все тестируемые модели, похоже, испытывали трудности с одними и теми же вещами. Большинство фактов, в которых модели ошибались, касались событий или состояний персонажей и отношений.

В статье отмечается, что "большинство из этих утверждений можно опровергнуть только с помощью многоходовых рассуждений над доказательствами, что подчеркивает сложность задачи и ее отличие от существующих способов проверки фактов".

Магистранты также часто упускали важную информацию в своих резюме. Кроме того, они слишком акцентировали внимание на содержании в конце книг, пропуская важные материалы ближе к началу.

Заменит ли ИИ человеческих аннотаторов?

Человеческие аннотаторы или специалисты по проверке фактов стоят дорого. Исследователи потратили $5,200, чтобы человеческие аннотаторы проверили утверждения в резюме ИИ.

Могла ли модель искусственного интеллекта выполнить эту работу за меньшую сумму? Простой поиск фактов Это то, с чем Клод 3 справляется хорошо, но его производительность при проверке утверждений, требующих более глубокого понимания содержания, менее последовательна.

Когда им предъявляли извлеченные утверждения и предлагали проверить их, все модели ИИ не смогли превзойти человеческих аннотаторов. Особенно плохо они справлялись с выявлением неверных утверждений.

Несмотря на то, что Claude 3 Opus оказался лучшим верификатором претензий, исследователи пришли к выводу, что он "в конечном итоге работает слишком плохо, чтобы быть надежным авторейтером".

Когда дело доходит до понимания нюансов, сложных человеческих взаимоотношений, сюжетных моментов и мотиваций персонажей в длинном повествовании, кажется, что люди пока еще имеют преимущество.