Исследователи из Стэнфорда и Google DeepMind создали искусственный интеллект, способный с удивительной точностью воспроизводить человеческие личности после двухчасовой беседы.

Опросив 1052 человека из разных слоев общества, они создали так называемых "агентов-симуляторов" - цифровые копии, которые с пугающей эффективностью предсказывали убеждения, взгляды и поведение своих коллег.

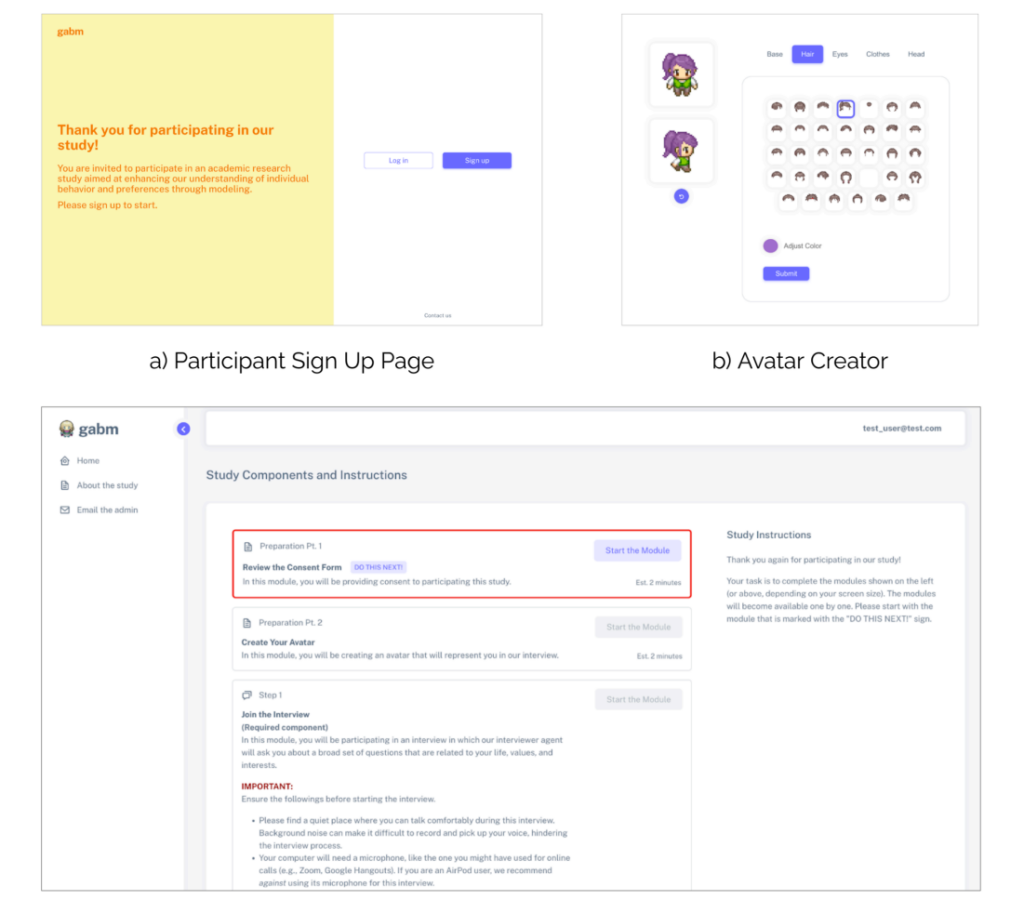

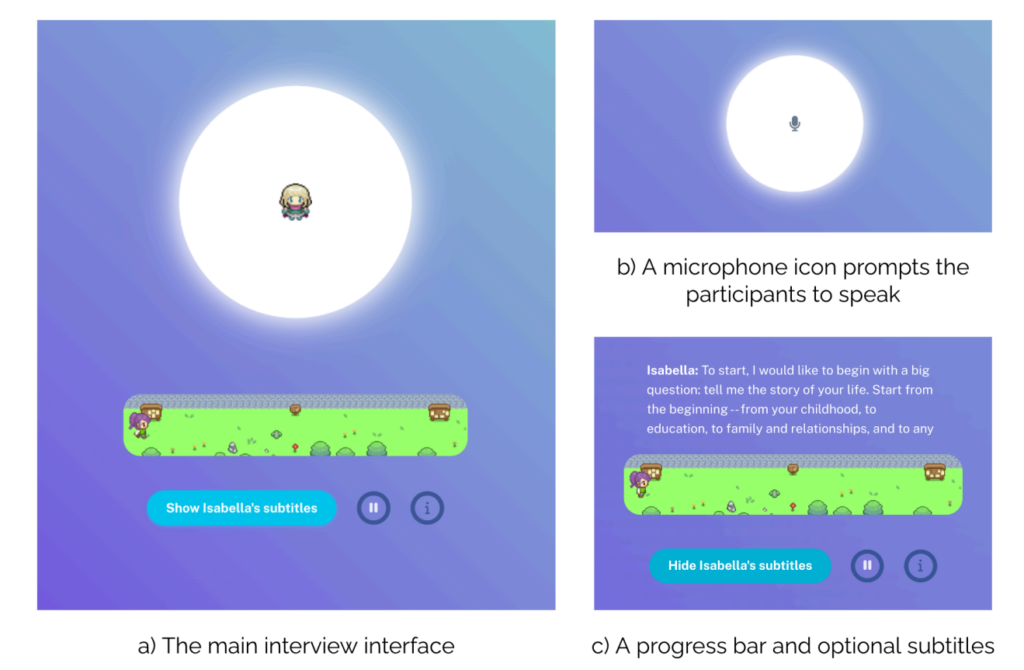

Для создания цифровых копий команда использует данные, полученные с помощью "искусственного интеллекта-интервьюера", предназначенного для вовлечения участников в естественный разговор.

ИИ-интервьюер задает вопросы и генерирует персонализированные последующие вопросы - в среднем 82 за сеанс, - которые касаются всего: от детских воспоминаний до политических взглядов.

В ходе этих двухчасовых обсуждений каждый участник составил подробные стенограммы объемом в среднем 6 500 слов.

Например, когда участник упоминает свой родной город в детстве, искусственный интеллект может прощупать его глубже, спрашивая о конкретных воспоминаниях или переживаниях. Имитируя естественный ход беседы, система улавливает нюансы личной информации, которые стандартные опросы обычно пропускают.

За кулисами исследование Исследователи документируют то, что они называют "экспертными размышлениями", побуждая большие языковые модели (LLM) анализировать каждый разговор с четырех различных профессиональных точек зрения:

- Как психолог, он определяет специфические черты личности и эмоциональные паттерны - например, отмечает, как человек ценит независимость, основываясь на его описании семейных отношений.

- Через призму поведенческой экономики он извлекает информацию о принятии финансовых решений и толерантности к риску, например, о том, как они подходят к сбережениям или выбору профессии.

- С точки зрения политологов, идеологические пристрастия и политические предпочтения отображаются в различных вопросах.

- Демографический анализ отражает социально-экономические факторы и жизненные обстоятельства.

Исследователи пришли к выводу, что этот метод, основанный на интервью, значительно превзошел аналогичные методы, такие как поиск данных в социальных сетях.

Тестирование цифровых копий

Насколько хороши были копии ИИ? Исследователи подвергли их целому ряду испытаний, чтобы выяснить это.

Сначала они использовали Общий социальный опрос (General Social Survey) - показатель социальных настроений, в котором задаются вопросы обо всем - от политических взглядов до религиозных убеждений. Здесь копии ИИ совпали с ответами своих человеческих коллег в 85% случаев.

В тесте "Большая пятерка", который измеряет такие черты, как открытость и добросовестность, с помощью 44 различных вопросов, прогнозы ИИ совпали с ответами человека примерно в 80% случаев. Система отлично справилась с такими чертами, как экстраверсия и нейротизм.

Однако тестирование экономических игр выявило интересные недостатки. В игре "Диктатор", где участники решают, как разделить деньги с другими, ИИ не смог идеально предсказать человеческую щедрость.

В игре "Доверие", проверяющей готовность сотрудничать с другими людьми ради взаимной выгоды, цифровые копии совпадали с выбором человека лишь в двух третях случаев.

Это говорит о том, что хотя ИИ и может понять наши ценности, он все еще не может полностью уловить нюансы принятия социальных решений человеком (пока, конечно).

Эксперименты в реальном мире

Не останавливаясь на достигнутом, исследователи также подвергли копии пяти классическим экспериментам по социальной психологии.

В одном из экспериментов, проверяющих, как восприятие намерения влияет на обвинение, и люди, и их копии ИИ продемонстрировали схожие тенденции: они возлагали на себя больше вины, когда вредные действия казались намеренными.

В другом эксперименте изучалось, как справедливость влияет на эмоциональную реакцию, причем копии ИИ точно предсказывали реакцию человека на справедливое и несправедливое отношение.

ИИ-реплики успешно воспроизводили поведение человека в четырех из пяти экспериментов, что говорит о том, что они могут моделировать не только отдельные тематические реакции, но и широкие, сложные поведенческие модели.

Легкие клоны искусственного интеллекта: Каковы последствия?

AI systems that ‘clone’ human views and behaviors are big business, with Мета недавно объявила о планах по заполнению Facebook и Instagram с профилями искусственного интеллекта которые могут создавать контент и взаимодействовать с пользователями.

TikTok также вступил в борьбу со своим новым набором творческих инструментов "Symphony", основанных на искусственном интеллекте, который включает в себя цифровые аватары, которые могут использоваться брендами и авторами для создания локализованного контента в масштабе.

С Симфонические цифровые аватарыTikTok позволяет создателям создавать аватары, которые представляют собой реальных людей, с широким спектром жестов, выражений, возрастов, национальностей и языков.

Исследование Стэнфорда и DeepMind предполагает, что такие цифровые копии будут становиться все более сложными - и их будет проще создавать и внедрять в масштабах.

"Если у вас будет куча маленьких "вы", которые будут бегать вокруг и принимать решения, которые приняли бы вы - это, я думаю, в конечном итоге будущее", - описывает ведущий исследователь Джун Сунг Парк, аспирант Стэнфордского университета в области компьютерных наук. MIT.

Парк говорит, что у такой технологии есть и плюсы: создание точных клонов может способствовать научным исследованиям.

Вместо того чтобы проводить дорогостоящие или сомнительные с этической точки зрения эксперименты на реальных людях, исследователи могут проверить, как население может реагировать на определенные воздействия. Например, это может помочь предсказать реакцию на сообщения в области общественного здравоохранения или изучить, как сообщества адаптируются к серьезным изменениям в обществе.

Однако в конечном итоге те же особенности, которые делают эти реплики ИИ ценными для исследований, также делают их мощными инструментами для обмана.

По мере того как цифровые копии становятся все более убедительными, отличить подлинное взаимодействие человека и искусственного интеллекта становится все сложнее, что мы и наблюдаем на примере наплыва глубоких подделок.

Что, если такая технология будет использована для клонирования человека против его воли? Каковы последствия создания цифровых копий, тщательно смоделированных на реальных людях?

Исследовательская группа из Стэнфорда и DeepMind признает эти риски. Их система требует четкого согласия участников и позволяет им отозвать свои данные, рассматривая воспроизведение личности с теми же соображениями конфиденциальности, что и конфиденциальную медицинскую информацию.

Это, по крайней мере, обеспечивает некоторую теоретическую защиту от более злонамеренных форм использования. Но в В любом случае, мы все глубже погружаемся в неизведанные территории взаимодействия человека и машины, и долгосрочные последствия этого остаются во многом неизвестными.