ИИ имеет огромное количество применений, но одно из самых опасных - создание фальшивых СМИ и дезинформации.

Новый исследование с сайта Google DeepMind и ЛобзикТехнологический инкубатор Google, отслеживающий угрозы обществу, проанализировал неправомерное использование искусственного интеллекта в период с января 2023 по март 2024 года.

В исследовании было проанализировано около 200 реальных случаев неправомерного использования ИИ, и выяснилось, что создание и распространение обманчивых фальшивых СМИ, особенно направленных на политиков и общественных деятелей, является наиболее распространенной формой злонамеренного использования ИИ.

Глубокие подделки - синтетические медиа, созданные с помощью алгоритмов искусственного интеллекта для создания очень реалистичных, но поддельных изображений, видео и аудио - становятся все более реалистичными и повсеместными.

Такие инциденты, как откровенно фальшивые изображения Тейлор Свифт Появившись на сайте X, они показали, что такие изображения могут попасть к миллионам людей, прежде чем будут удалены.

Но самыми коварными являются глубокие подделки, направленные на решение политических вопросов, например, израильско-палестинский конфликт. В некоторых случаях даже специалисты по проверке фактов, которым поручено помечать их как "сгенерированные искусственным интеллектом", не могут достоверно определить их подлинность.

Исследование компании DeepMind собирали данные из самых разных источников, включая социальные сети, такие как X и Reddit, онлайн-блоги и сообщения СМИ.

Каждый инцидент был проанализирован на предмет определения конкретного типа технологии искусственного интеллекта, использованной не по назначению, цели злоупотребления и уровня технических знаний, необходимых для осуществления вредоносной деятельности.

Глубокие подделки - основная форма злоупотребления ИИ

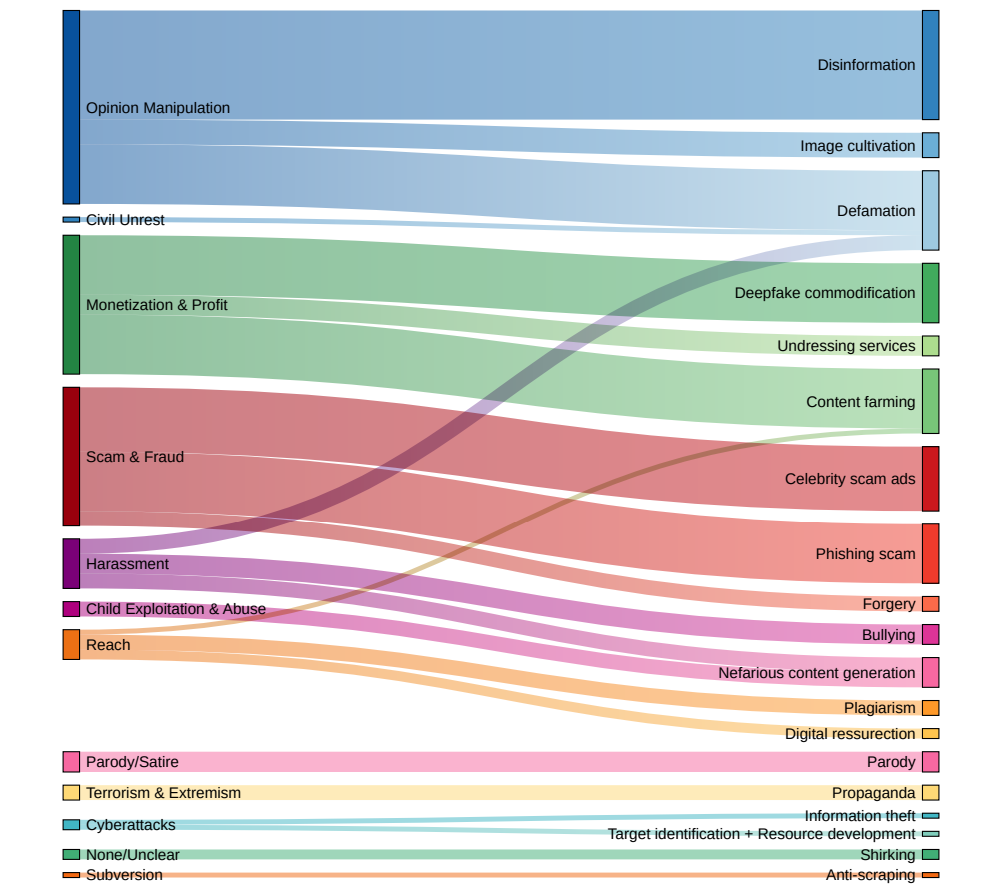

Полученные данные рисуют тревожную картину современного ландшафта использования вредоносного ИИ:

- Глубокие подделки стали доминирующей формой неправомерного использования ИИ, на них пришлось почти в два раза больше инцидентов, чем на следующую по распространенности категорию.

- Вторым наиболее часто встречающимся видом злоупотреблений ИИ было использование языковых моделей и чат-ботов для создания и распространения дезинформации в сети. Автоматизируя создание недостоверного контента, злоумышленники могут наводнять социальные сети и другие платформы фальшивыми новостями и пропагандой в беспрецедентных масштабах.

- Влияние на общественное мнение и политические нарративы было основной мотивацией более четверти (27%) проанализированных случаев неправомерного использования ИИ. Это иллюстрирует угрозу, которую глубокие подделки и дезинформация, генерируемая ИИ, представляют для демократических процессов и честности выборов во всем мире, что мы наблюдаем с недавние громкие инциденты.

- Вторым по распространенности фактором вредоносной деятельности ИИ была названа финансовая выгода: недобросовестные субъекты предлагали платные услуги по созданию глубоких подделок, включая откровенные изображения без согласия, и использовали генеративный ИИ для массового производства поддельного контента с целью получения прибыли.

- Большинство инцидентов, связанных с неправомерным использованием ИИ, связано с легкодоступными инструментами и сервисами, для работы с которыми требуется минимальный технический опыт. Такой низкий барьер для входа значительно расширяет круг потенциальных злоумышленников, облегчая отдельным лицам и группам участие в обмане и манипуляциях с помощью ИИ.

Доктор Нахема Марчал из компании DeepMind рассказала об эволюции неправомерного использования ИИ. Financial Times: "Было много понятных опасений по поводу довольно сложных кибер-атак, совершаемых с помощью этих инструментов", - продолжает он.Мы увидели довольно распространенные злоупотребления GenAI [такие как глубокие подделки, которые] могут остаться незамеченными".

Политики, технологические компании и исследователи должны совместно разрабатывать комплексные стратегии по выявлению и противодействию фальсификациям, дезинформации, генерируемой ИИ, и другим формам неправомерного использования ИИ.

Но на самом деле они уже пытались - и в основном неудачно. Совсем недавно мы наблюдали все больше случаев Дети становятся жертвами фальшивых инцидентовЭто показывает, что вред, который они наносят обществу, может быть очень серьезным.

В настоящее время технологические компании не могут надежно обнаружить глубокие подделки в масштабе, и со временем они будут становиться все более реалистичными и сложными для обнаружения.

А когда появятся системы преобразования текста в видео, такие как Sora от OpenAI, возникнет новое измерение глубоких подделок.