Мы часто слышим о безопасности ИИ, но значит ли это, что он активно используется в исследованиях?

Новый исследование В исследовании Джорджтаунского университета Emerging Technology Observatory говорится о том, что, несмотря на шум, исследования в области безопасности ИИ занимают лишь незначительную часть исследовательского фокуса индустрии.

Исследователи проанализировали более 260 миллионов научных публикаций и обнаружили, что лишь 2% статей, связанных с ИИ, опубликованных в период с 2017 по 2022 год, напрямую затрагивают темы, связанные с безопасностью, этикой, надежностью или управлением ИИ.

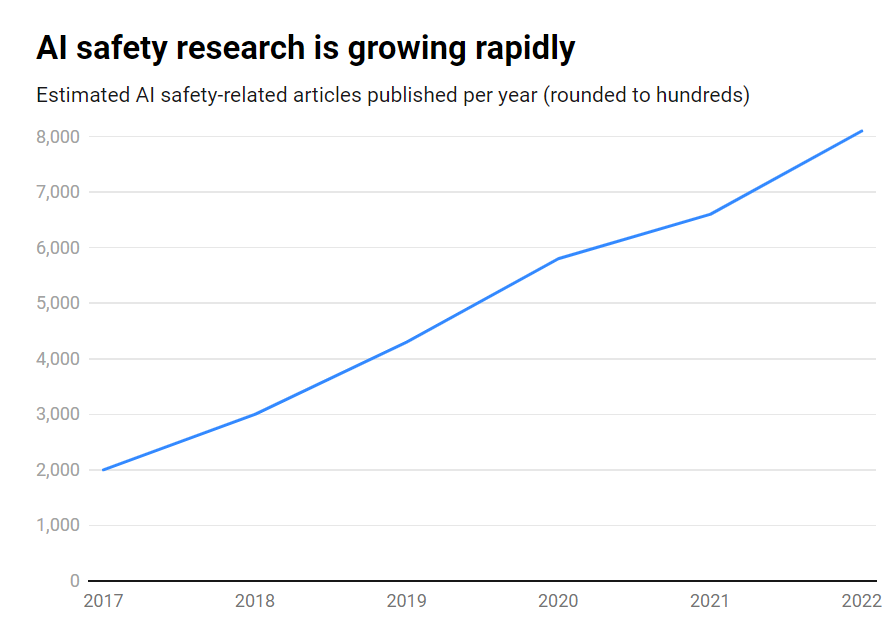

Хотя количество публикаций по безопасности ИИ за этот период выросло впечатляюще 315% с 1800 до более чем 7000 в год, она остается периферийной проблемой.

Вот основные выводы:

- Только 2% исследований в области ИИ в 2017-2022 годах будет посвящено безопасности ИИ

- Исследования в области безопасности ИИ выросли на 315% за этот период, но они уступают общим исследованиям в области ИИ.

- США лидируют в исследованиях безопасности ИИ, а Китай отстает

- Основные проблемы включают в себя надежность, справедливость, прозрачность и сохранение человеческого контроля.

Многие ведущие исследователи ИИ и специалисты по этике предупреждают об экзистенциальных рисках, если искусственный интеллект общего назначения (ИОН) будет создан без достаточных мер предосторожности и защиты.

Представьте себе систему AGI, которая способна рекурсивно улучшать себя, быстро превосходя человеческий интеллект и преследуя при этом цели, не соответствующие нашим ценностям. Такой сценарий, по мнению некоторых, может выйти из-под нашего контроля.

Однако это не одностороннее движение. На самом деле, многие исследователи ИИ считают, что Безопасность искусственного интеллекта слишком преувеличена.

Кроме того, некоторые даже считают, что вся эта шумиха была создана для того, чтобы помочь Большим технологиям обеспечить соблюдение правил и устранить низовые и конкуренты с открытым исходным кодом.

Однако даже современные узкоспециализированные системы искусственного интеллекта, обученные на прошлых данных, могут проявлять предвзятость, создавать вредный контент, нарушать конфиденциальность и использоваться не по назначению.

Таким образом, хотя безопасность ИИ должна быть направлена в будущее, она также должна устранять риски здесь и сейчас, чего, вероятно, недостаточно, поскольку глубокие подделки, предвзятость и другие проблемы продолжают оставаться актуальными.

Эффективные исследования безопасности ИИ должны быть направлены как на решение ближайших проблем, так и на долгосрочные спекулятивные риски.

США лидируют в исследованиях безопасности ИИ

Если углубляться в данные, то США являются явным лидером в области исследований безопасности ИИ: здесь было опубликовано 40% соответствующих публикаций по сравнению с 12% в Китае.

Однако китайские разработки в области безопасности значительно отстают от общих исследований в области ИИ - в то время как 5% американских исследований в области ИИ касались безопасности, только 1% китайских.

Можно предположить, что изучение китайских исследований - задача не из легких. Кроме того, Китай проактивное регулирование - Возможно, даже больше, чем в США, поэтому эти данные могут не дать справедливого представления об индустрии ИИ в этой стране.

На уровне учебных заведений лидируют Университет Карнеги-Меллона, Google, Массачусетский технологический институт и Стэнфорд.

Однако в глобальном масштабе ни одна организация не выпустила более 2% от общего числа публикаций, связанных с безопасностью, что свидетельствует о необходимости более масштабных и согласованных усилий.

Дисбаланс в системе безопасности

Что же можно сделать, чтобы устранить этот дисбаланс?

Это зависит от того, считает ли человек безопасность ИИ таким же неотложным риском, как ядерная война, пандемии и т. д. Однозначного ответа на этот вопрос нет, что делает безопасность ИИ весьма спекулятивной темой с небольшим количеством взаимных соглашение между исследователями.

Исследования и этика безопасности также являются в некотором роде косвенной областью машинного обучения, требующей иных навыков, академического образования и т. д., которые могут не получить достаточного финансирования.

Устранение пробелов в безопасности ИИ также потребует решения вопросов, связанных с открытостью и секретностью в разработке ИИ.

Крупнейшие технологические компании проводят обширные внутренние исследования в области безопасности, которые никогда не публикуются. По мере коммерциализации ИИ корпорации все активнее защищают свои достижения в области ИИ.

OpenAI, например, на заре своего существования была исследовательским центром.

Раньше компания проводила глубокие независимые аудиты своей продукции, предвзятости маркировки и рисков - таких, как сексистские предубеждения в проекте CLIP.

Anthropic по-прежнему активно занимается исследованиями в области общественной безопасности ИИ, часто публикуя исследования по смещение и джейлбрейк.

DeepMind также задокументировала возможность того, что модели искусственного интеллекта могут устанавливать "эмерджентные цели" и активно противоречить своим инструкциям или становиться враждебными по отношению к своим создателям.

Однако в целом безопасность отошла на второй план по сравнению с прогрессом, поскольку Кремниевая долина живет под девизом "двигайся быстро и ломай вещи".

Исследование Джорджтауна в конечном итоге подчеркивает, что университеты, правительства, технологические компании и финансирующие исследования организации должны вкладывать больше усилий и средств в безопасность ИИ.

Некоторые также призывают к международный орган по безопасности искусственного интеллектаПодобно Международному агентству по атомной энергии (МАГАТЭ), которое было создано после серии ядерных инцидентов, сделавших обязательным глубокое международное сотрудничество.

Потребуется ли ИИ собственная катастрофа, чтобы привлечь к сотрудничеству государства и компании такого уровня? Будем надеяться, что нет.