NVIDIA выпустила Chat with RTX в качестве демонстрации того, как чат-боты с искусственным интеллектом могут работать локально на ПК с Windows с помощью графических процессоров RTX.

Стандартный подход к использованию чатбота с искусственным интеллектом - это использование веб-платформы, такой как ChatGPT, или выполнение запросов через API, при этом выводы делаются на серверах облачных вычислений. Недостатками такого подхода являются затраты, задержки и проблемы с конфиденциальностью при передаче личных или корпоративных данных туда и обратно.

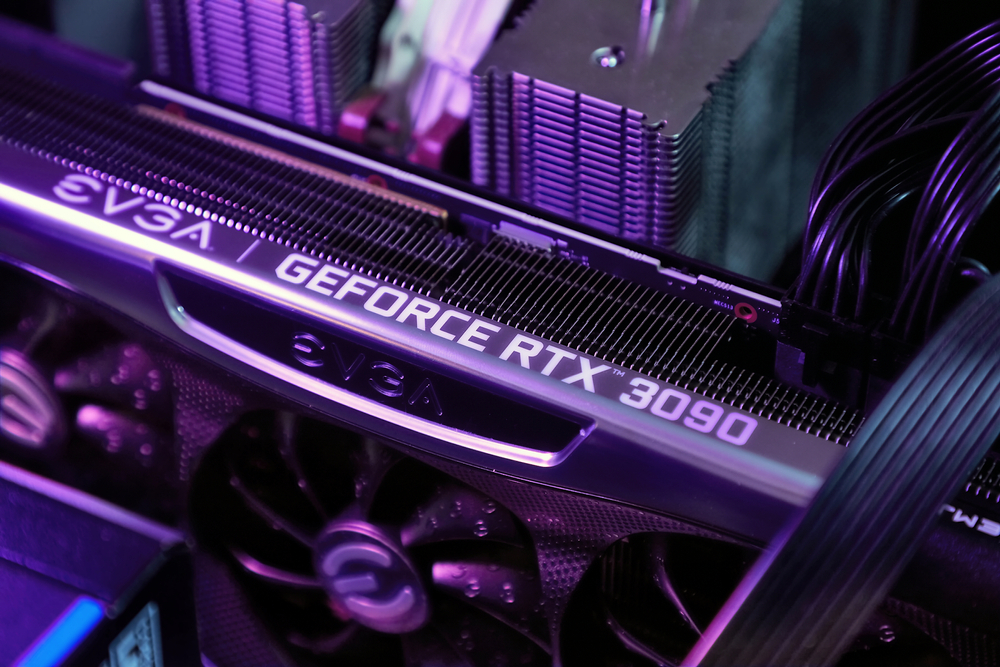

RTX от NVIDIA Линейка графических процессоров позволяет запускать LLM локально на компьютере с Windows, даже если вы не подключены к Интернету.

Chat with RTX позволяет пользователям создавать персонализированные чатботы, используя либо Мистраль или Ллама 2. В нем используется генерация с расширением поиска (RAG) и оптимизация выводов TensorRT-LLM от NVIDIA.

Вы можете направить Chat with RTX в папку на вашем компьютере, а затем задать ему вопросы, связанные с файлами в этой папке. Программа поддерживает различные форматы файлов, включая .txt, .pdf, .doc/.docx и .xml.

Поскольку LLM анализирует локально хранящиеся файлы, а выводы делаются на вашей машине, он работает очень быстро, и ни одна из ваших данных не передается в потенциально незащищенные сети.

Вы также можете задать ему URL-адрес видеоролика на YouTube и задать вопросы о нем. Для этого требуется доступ в интернет, но это отличный способ получить ответы без необходимости смотреть длинное видео.

Вы можете скачать Чат с RTX бесплатно, но для этого вам потребуется Windows 10 или 11 на вашем компьютере с графическим процессором GeForce RTX 30 Series или выше, с минимум 8 ГБ VRAM.

Чат с RTX - это скорее демо-версия, чем готовый продукт. Он немного глючит и не запоминает контекст, поэтому вы не можете задавать ему последующие вопросы. Но это хороший пример того, как мы будем использовать LLM в будущем.

Использование ИИ-чатбота на локальном уровне с нулевыми затратами на вызовы API и очень малой задержкой - это, скорее всего, тот способ, которым большинство пользователей в конечном итоге будут взаимодействовать с LLM. Подход с открытым исходным кодом, которого придерживаются такие компании, как Meta, приведет к тому, что ИИ на устройствах будет способствовать распространению их бесплатных моделей, а не проприетарных, как GPT.

Тем не менее, пользователям мобильных устройств и ноутбуков придется подождать еще некоторое время, прежде чем вычислительная мощь графического процессора RTX сможет поместиться в более компактные устройства.