Могут ли люди научиться надежно распознавать подделки, созданные ИИ? Как они влияют на нас на когнитивном уровне?

Система Sora от OpenAI Недавно в журнале "Эхо Москвы" прозвучала информация о новой волне синтетических медиа с искусственным интеллектом. Вероятно, пройдет совсем немного времени, прежде чем любая форма реалистичного медиа - аудио, видео или изображение - можно создать с помощью подсказок за считанные секунды.

По мере того как эти системы искусственного интеллекта будут становиться все более способными, нам придется оттачивать новые навыки критического мышления, чтобы отделять правду от вымысла.

На сегодняшний день усилия Больших Технологий по замедлению или пресечению глубоких подделок сводятся к незначительным усилиям, но не из-за недостатка убежденности, а потому что контент ИИ настолько реалистичен.

Это делает его трудно обнаружить на уровне пикселейВ то время как другие сигналы, такие как метаданные и водяные знаки, имеют свои недостатки.

Более того, даже если бы контент, созданный искусственным интеллектом, можно было обнаружить в масштабе, сложно отделить подлинный, целенаправленный контент от того, который предназначен для распространения дезинформации.

Передача контента человеческим рецензентам и использование "заметок сообщества" (информация, прикрепленная к контенту, которую часто можно увидеть на сайте X) - это возможное решение. Однако иногда это связано с субъективной интерпретацией и риском неправильной маркировки.

Например, в Израильско-палестинский конфликтМы были свидетелями того, как тревожные изображения выдавались за настоящие, а на самом деле были подделкой, и наоборот.

Когда на настоящее изображение наклеивают ярлык подделки, это может создать 'дивиденды лжецаКогда кто-то или что-то отмахивается от правды, считая ее фальшивкой.

Итак, в отсутствие технических методов пресечения глубоких подделок со стороны технологий, что мы можем с этим сделать?

И в какой степени глубокие подделки влияют на принятие решений и психологию?

Например, когда людям показывают фальшивые политические изображения, оказывает ли это ощутимое влияние на их поведение при голосовании?

Давайте посмотрим на несколько исследований, которые оценивают именно это.

Влияют ли глубокие подделки на наше мнение и психологическое состояние?

Исследование 2020 годаВ работе "Глубокие подделки и дезинформация: Exploring the Impact of Synthetic Political Video on Deception, Uncertainty, and Trust in News" ("Изучение влияния синтетических политических видео на обман, неопределенность и доверие к новостям"), исследовал, как видео с глубокими подделками влияет на общественное восприятие, в частности, на доверие к новостям, распространяемым в социальных сетях.

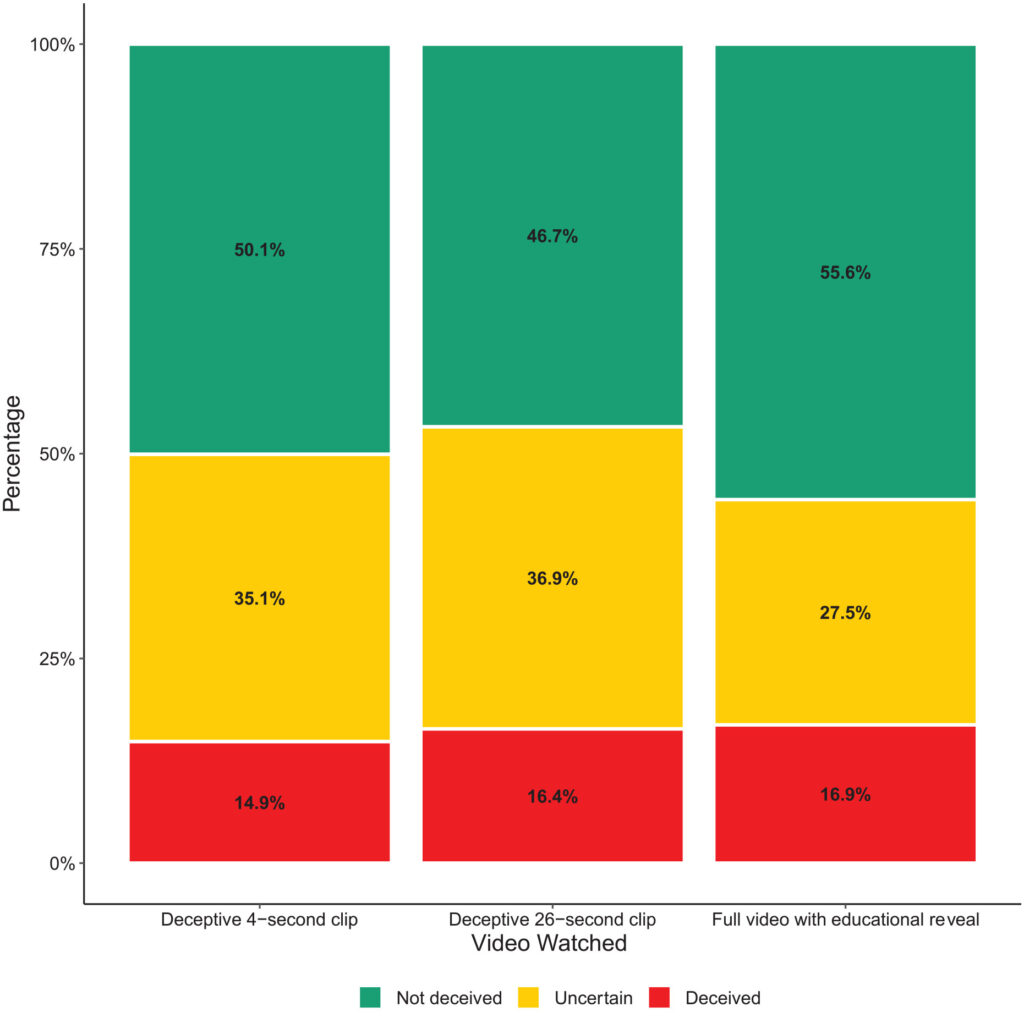

В ходе исследования был проведен крупномасштабный эксперимент с участием 2 005 человек из Великобритании, целью которого было определить реакцию на различные типы глубоко фальшивых видеороликов с изображением бывшего президента США Барака Обамы.

Участников случайным образом распределили для просмотра одного из трех видео:

- Четырехсекундный ролик, в котором Обама делает неожиданное заявление без какого-либо контекста.

- 26-секундный ролик, в котором содержались некоторые намеки на искусственную природу видео, но в основном он был обманчивым.

- Полное видео с "образовательным разоблачением", в котором открыто раскрывается искусственная природа глубокой подделки, с участием Джордана Пила, объясняющего технологию, лежащую в основе глубокой подделки.

Основные выводы

В ходе исследования были изучены три ключевые области:

- Обман: Исследование выявило минимальные доказательства того, что участники поверили ложным утверждениям в глубоких фальшивках. Процент участников, введенных в заблуждение глубокими фальшивками, был относительно низким во всех группах.

- Неопределенность: Однако главным результатом стало усиление неуверенности среди зрителей, особенно среди тех, кто видел более короткие обманчивые ролики. Около 35,1% участников, посмотревших 4-секундный ролик, и 36,9%, посмотревших 26-секундный ролик, заявили о неуверенности в подлинности видео. В отличие от этого, только 27,5% из тех, кто просмотрел полный образовательный ролик, испытывали подобное чувство.

- Доверие к новостям: Эта неопределенность негативно повлияла на доверие участников к новостям в социальных сетях. Те, кому показали обманчивую глубокую подделку, продемонстрировали более низкий уровень доверия, чем те, кто смотрел образовательную информацию.

Это говорит о том, что воздействие глубоких фальшивых изображений вызывает долгосрочную неуверенность.

Со временем фальшивые образы могут ослабить веру в любую информацию, включая правдивую.

Аналогичные результаты были продемонстрированы в исследовании более позднее исследование 2023 года"Face/Off: Изменение лица кино с помощью deepfake", в котором также делается вывод о том, что поддельные изображения имеют долгосрочные последствия.

Люди "запоминают" фальшивый контент после его просмотра

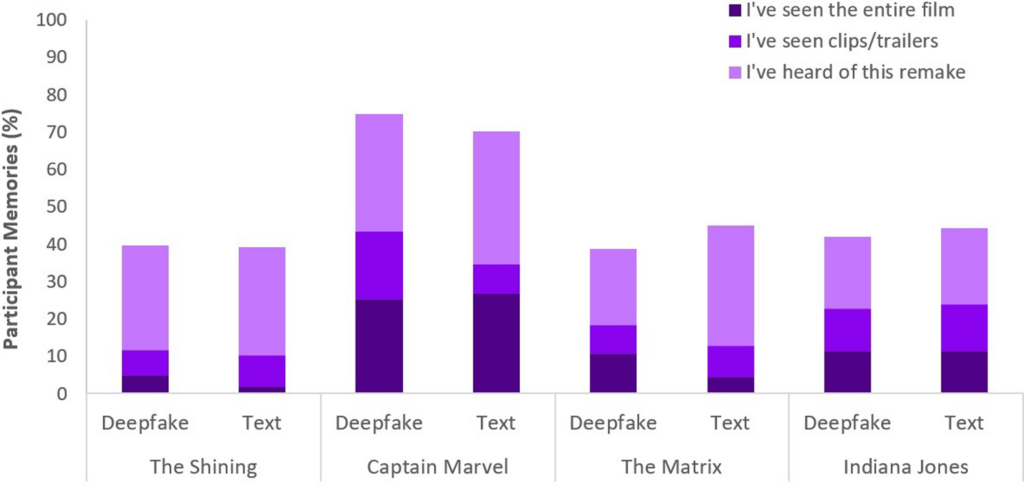

В исследовании Face/Off, в котором приняли участие 436 человек, изучалось, насколько глубокие подделки могут повлиять на наши воспоминания о фильмах.

Участники приняли участие в онлайн-опросе, целью которого было изучить их восприятие и воспоминания о реальных и воображаемых ремейках фильмов.

Суть исследования заключалась в том, что участникам предлагалось шесть названий фильмов, среди которых было четыре реальных ремейка и два вымышленных.

MФильмы были рандомизированы и представлены в двух форматах: половина фильмов была представлена в виде коротких текстовых описаний, а другая половина - в паре с короткими видеоклипами.

Вымышленные ремейки фильмов состояли из версий "Сияния", "Матрицы", "Индианы Джонса" и "Капитана Марвела", снабженных описаниями, в которых ложно утверждалось об участии в этих несуществующих ремейках известных актеров.

Например, участникам рассказали о фальшивом ремейке фильма "Сияние" с Брэдом Питтом и Анджелиной Джоли в главных ролях, которого никогда не было.

В отличие от этого, настоящие ремейки фильмов, представленные в опросе, такие как "Чарли и шоколадная фабрика" и "Total Recall", были описаны точно и сопровождались настоящими клипами. Такое сочетание настоящих и поддельных ремейков было призвано изучить, как участники различают фактический и сфабрикованный контент.

Участников опрашивали на предмет их знакомства с каждым фильмом, спрашивая, видели ли они оригинальный фильм или ремейк, а также имели ли какие-либо предварительные знания о них.

Основные выводы

- Феномен ложной памяти: Ключевым результатом исследования стало обнаружение того, что почти у половины участников (49%) развились ложные воспоминания о просмотре фиктивных ремейков, например, они представляли себе Уилла Смита в роли Нео в "Матрице". Это иллюстрирует устойчивый эффект, который могут оказывать на нашу память суггестивные медиа, будь то глубоко фальшивые видео или текстовые описания.

- В частности,"Капитан Марвел" возглавил список, 73% участников вспомнили ремейк его АИ, за ним следуют "Индиана Джонс" - 43%, "Матрица" - 42% и "Сияние" - 40%. Среди тех, кто ошибочно верил в эти ремейки, 41% считали, что ремейк "Капитана Марвела" превосходит оригинал.

- Сравнительное влияние глубоких подделок и текста: Еще одним открытием стало то, что глубокие подделки, несмотря на их визуальную и слуховую реалистичность, не более эффективно изменяли память участников, чем текстовые описания того же фиктивного контента. Это говорит о том, что формат дезинформации - визуальный или текстовый - не оказывает существенного влияния на искажение памяти в контексте фильма.

Феномен ложной памяти, о котором идет речь в этом исследовании, широко изучен. Он показывает, как люди эффективно конструируют или реконструируют ложные воспоминания, которые, как мы уверены, являются реальными, хотя это не так.

Каждый человек подвержен созданию ложных воспоминаний, и дПодделки eep, похоже, активируют это поведение, то есть просмотр определенного контента может изменить наше восприятие, даже если мы сознательно понимаем, что он не подлинный.

В обоих исследованиях глубокие подделки имели ощутимые, потенциально долгосрочные последствия. Эффект может подкрадываться незаметно и накапливаться со временем.

Не стоит забывать и о том, что фальшивый контент распространяется среди миллионов людей, поэтому небольшие изменения в восприятии распространяются на все население планеты.

Что делать с глубокими подделками?

Война с глубокими подделками означает борьбу с человеческим мозгом.

Если в последние годы рост фальшивых новостей и дезинформации заставил людей развивать новую медиаграмотность, то синтетические медиа, созданные ИИ, потребуют нового уровня адаптации.

Мы уже сталкивались с подобными переломными моментами - от фотографии до спецэффектов CGI, но ИИ потребует эволюции наших критических чувств.

Сегодня мы должны не просто верить своим глазам, а больше полагаться на анализ источников и контекстуальные подсказки.

Очень важно выяснить, каковы стимулы или предубеждения авторов. Согласуется ли она с известными фактами или противоречит им? Есть ли подтверждающие доказательства из других заслуживающих доверия источников?

Еще одним ключевым аспектом является установление правовых стандартов для выявления поддельных или манипулированных медиа и привлечения их создателей к ответственности.

Сайт Закон США о дефиансеЗакон об онлайн-безопасности Великобритании и аналогичные законы по всему миру устанавливают юридические процедуры для борьбы с фальшивками. Насколько эффективными они окажутся, еще предстоит выяснить.

Стратегии раскрытия истины

В заключение приведем пять стратегий выявления и проверки потенциальных глубоких подделок.

Хотя ни одна стратегия не является безупречной, формирование критического мышления - это лучшее, что мы можем сделать сообща, чтобы минимизировать влияние дезинформации ИИ.

- Проверка источника: Проверка достоверности и происхождения информации - это основополагающий шаг. Аутентичный контент часто поступает из авторитетных источников, имеющих репутацию надежных.

- Технический анализ: Несмотря на свою изощренность, глубокие подделки могут иметь едва заметные дефекты, такие как неправильное выражение лица или нестабильное освещение. Внимательно изучите контент и проверьте, не был ли он изменен цифровым способом.

- Перекрестные ссылки: Проверка информации по нескольким надежным источникам может обеспечить более широкую перспективу и помочь подтвердить подлинность контента.

- Цифровая грамотность: Понимание возможностей и ограничений технологий ИИ имеет ключевое значение для оценки контента. Обучение цифровой грамотности в школах и средствах массовой информации, включая работу ИИ и его этические последствия, будет иметь решающее значение.

- Осторожное взаимодействие: Взаимодействие с дезинформацией, генерируемой ИИ, усиливает ее эффект. Будьте осторожны, ставя лайк, делясь или перепостив сомнительный контент.

По мере развития фальшивок будут развиваться и методы, необходимые для их обнаружения и снижения вреда. 2024 год станет показательным, поскольку около половины населения Земли будет голосовать на крупных выборах.

Факты свидетельствуют о том, что глубокие подделки могут влиять на наше восприятие, поэтому не стоит думать, что дезинформация ИИ может существенно повлиять на результаты.

По мере продвижения вперед этические методы работы с ИИ, цифровая грамотность, регулирование и критическое участие будут играть ключевую роль в формировании будущего, в котором технологии будут усиливать, а не затушевывать суть правды.