Во время своего визита в Великобританию на саммит по безопасности ИИ вице-президент США Камала Харрис объявила, что 30 стран присоединились к США и одобрили предложенные ими "защитные рамки" для военного использования ИИ.

Объявление "Политическая декларация об ответственном военном использовании искусственного интеллекта и автономности" был опубликован 1 ноября на сайте Государственного департамента США, а 9 ноября были опубликованы дополнительные детали рамочной программы.

В своем заявлении по поводу рамочной программы Харрис отметила: "Чтобы обеспечить порядок и стабильность в условиях глобальных технологических изменений, я твердо убеждена, что мы должны руководствоваться общим набором понятий между странами".

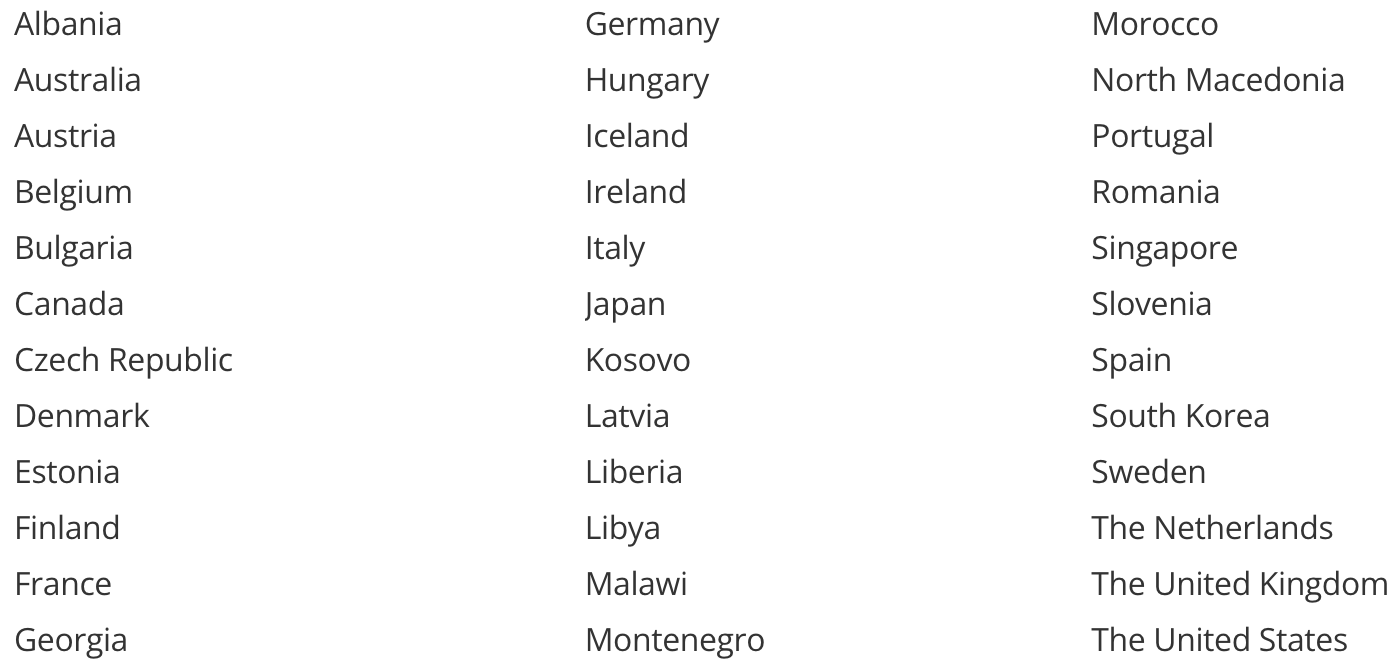

Вот страны, которые заявили о своей поддержке этой инициативы.

Примечательно, что в этом списке отсутствуют Китай и Россия. Китай одобрил Декларация Блетчли, заявив о своей принципиальной поддержке безопасного развития ИИ в целом.

Решение России и Китая отказаться от одобрения декларации о военном ИИ может иметь больше общего с авторами документа, чем с их взглядами на его суть.

Еще один пробел в списке оставили две страны, получающие миллиарды на военную поддержку от некоторых государств-одобрителей, - Израиль и Украина.

Как союзники США, их решение не поддерживать обещание, скорее всего, связано с тем, что обе страны в настоящее время используют ИИ в конфликтах, в которых они участвуют.

Израиль использует ИИ в различных военных целях, в том числе в Железный купол Система. Украина вызывает споры своими Автономные беспилотники с искусственным интеллектом, нацеленные на солдат и военной техники в конфликте с Россией.

На что они идут?

Если вы хотите ознакомиться с полной информацией о том, на что соглашаются подписанты вы можете сделать это здесь.

Вот краткая версия, которая может пожертвовать некоторым содержанием ради краткости:

- Убедитесь, что ваши военные приняли и используют эти принципы ИИ.

- Использование вашего военного ИИ должно соответствовать нормам международного права и защищать гражданское население.

- Высшее руководство должно управлять разработкой и внедрением военного ИИ.

- Активно минимизировать непреднамеренные предубеждения в возможностях военного ИИ.

- Будьте осторожны, создавая или используя оружие ИИ.

- Убедитесь, что технология защиты от ИИ прозрачна и проверяема.

- Обучите тех, кто использует или одобряет использование возможностей военного ИИ, чтобы они не доверяли слепо ИИ, когда он ошибается.

- Четко определите, что вы планируете делать с вашей военной технологией ИИ, и спроектируйте ее так, чтобы она делала только это.

- Продолжайте тестировать самообучающиеся и постоянно обновляемые возможности военного ИИ, чтобы убедиться, что они по-прежнему безопасны.

- Имейте выключатель на случай, если оружие ИИ поведет себя неправильно.

Это похвальные идеалы, но сомнительно, что они технологически или даже логистически по силам оборонным организациям.

Могут ли они быть принудительно исполнены? Подписание обещания является подтверждением принципиального одобрения, но не влечет за собой никаких юридических обязательств.

Подписание документа, в котором говорится: "Мы будем осторожны при использовании ИИ в наших вооруженных силах", также подразумевает, что страна полностью намерена использовать ИИ в качестве оружия, хотя и "ответственным и этичным" способом.

По крайней мере, эти страны признают, что ИИ может усилить вред, который уже наносит обычное оружие. Сделали ли эти рамки мир немного безопаснее, или просто прожектор пролил свет на то, что неизбежно ждет нас впереди?