Приобретает ли ИИ определенный уровень сознания? Как мы узнаем, если и когда это произойдет?

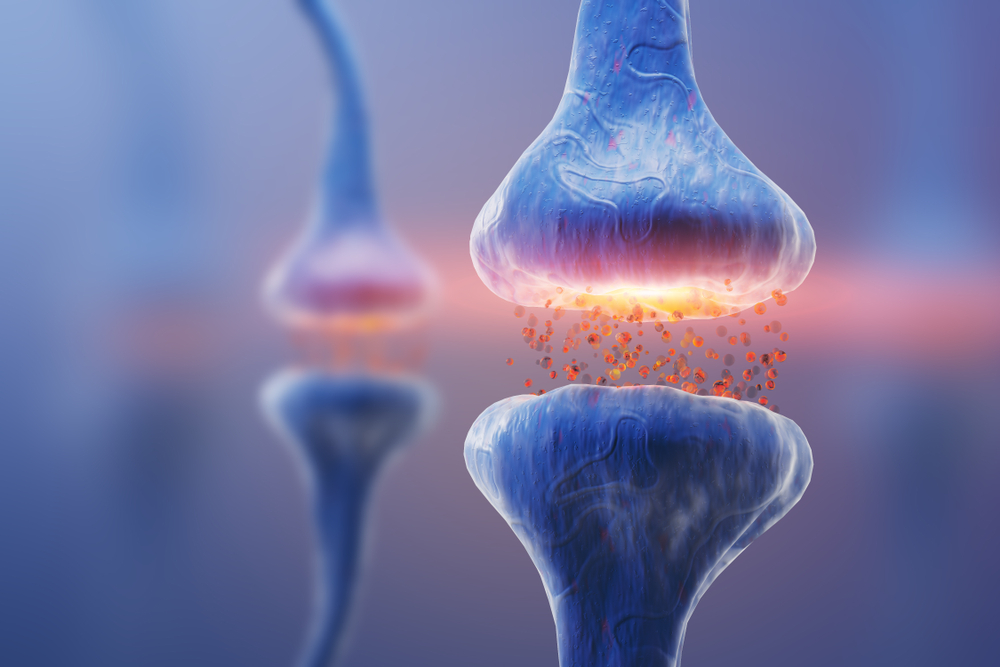

Большие языковые модели (БЯМ) могут вести реалистичные разговоры и генерировать тексты на различные темы, что вызывает споры о том, когда они становятся разумными или сознательными - эти понятия хоть и часто связаны между собой, но все же являются разными.

Чувство - это прежде всего ощущение и осознание, в то время как сознание - более сложная и всеобъемлющая область.

Только в начале этого года компания Microsoft, протестировав GPT-4 от OpenAI, указано что модель продемонстрировала "искры" "общего интеллекта" - термин, используемый для определения гибкого, адаптируемого ИИ с высокими когнитивными способностями.

Более того, Блейк Лемуан, бывший инженер Google, заявил, что ИИ LaMDA компании Google достиг уровня разумности. Лемуан сказал о LaMDA: "Google может назвать это обменом собственностью. Я же называю это передачей дискуссии, которую я вел с одним из своих коллег" - этим "коллегой" была система искусственного интеллекта, которая выразила "страх" перед тем, что ее "выключат".

В попытке обосновать дебаты вокруг сознания ИИ междисциплинарная команда исследователей в области философии, вычислительной техники и нейронаук провела всестороннее изучение самых современных систем ИИ.

Сайт исследованиеАвторы исследования под руководством Роберта Лонга и его коллег из некоммерческой организации Center for AI Safety (CAIS), расположенной в Сан-Франциско, тщательно проанализировали множество теорий человеческого сознания. Они составили список из 14 "индикаторных свойств", которыми, скорее всего, будет обладать сознательный ИИ.

CAIS - это та же некоммерческая организация, которая выдвинула восемь предложений по созданию головотяпства. потенциальные риски для искусственного интеллекта в июне.

Проанализировав результаты, команда пришла к выводу, что самые сложные модели не справляются практически со всеми тестами на сознание, которым они подвергались.

Исследователи оценили несколько моделей ИИ, в том числе Адаптивный агент DeepMind (ADa) и PaLM-EОн описывается как воплощенный роботизированный мультимодальный LLM.

Сравнив эти ИИ с 14 показателями, исследователи не нашли существенных доказательств того, что какие-либо модели ИИ обладают сознанием.

Подробнее об исследовании

В этом подробном междисциплинарном исследовании проанализированы многочисленные теории сознания, которое остается малоописанной концепцией в научной литературе, и применены к современным методам ИИ.

Хотя исследование не позволило установить, что современные ИИ обладают сознанием, оно закладывает основу для будущего анализа, по сути, предоставляя "контрольный список", на который исследователи могут ссылаться при анализе возможностей своих ИИ.

Понимание сознания также крайне важно для информирования общественности о дебатах вокруг ИИ.

Однако сознание не является бинарным понятием, и определить его границы по-прежнему чрезвычайно сложно.

Некоторые исследователи считают, что сознание будет развиваться спонтанно, как только ИИ приблизится к "сингулярности", которая, по сути, обозначает момент, когда сложность систем ИИ превзойдет человеческое познание.

Вот 14 показателей сознания, которые оценивали исследователи:

Теория рекуррентной обработки (RPT)

Теория рекуррентной обработки фокусируется на временных аспектах обработки информации.

В контексте сознания это подчеркивает, как информация поддерживается и обновляется в течение времени.

Это считается критически важным для создания богатства сознательного опыта.

RPT-1: Входные модули с использованием алгоритмической рекурсии

Под алгоритмической повторяемостью здесь понимается циклическая обработка информации.

Подумайте об этом как о цикле компьютерной программы, который постоянно обновляет свои данные на основе новых входных данных.

RPT-2: Входные модули, генерирующие организованный, интегрированный перцептивный опыт

Подобно людям и другим животным, эта система не просто получает сенсорную информацию - она интегрирует ее в целостную и единую "картину", которую можно воспринимать как единый опыт.

Теория глобального рабочего пространства (GWT)

Вторым набором показателей, заданных исследовательской группой, была теория глобального рабочего пространства, которая предполагает, что сознание возникает в результате взаимодействия различных когнитивных модулей в "глобальном рабочем пространстве".

Это рабочее пространство служит своего рода когнитивной сценой, где различные модули могут "передавать" и "принимать" информацию, создавая единый, целостный опыт.

GWT-1: Несколько специализированных систем, работающих параллельно

По сути, это означает, что система искусственного интеллекта должна иметь несколько специализированных "мини-мозгов", каждый из которых отвечает за разные функции (например, память, восприятие и принятие решений), и они должны работать одновременно.

GWT-2: Рабочее пространство ограниченной вместимости

Эта идея связана с тем, что человек может сосредоточиться только на ограниченном количестве информации в любой момент времени.

Аналогично, система искусственного интеллекта должна обладать избирательным фокусом, то есть способностью определять наиболее важную информацию, на которую следует "обратить внимание".

GWT-3: Глобальная трансляция

Информация, поступающая в глобальное рабочее пространство, должна быть доступна для всех когнитивных модулей, чтобы каждый "мини-мозг" мог использовать ее для своей специализированной функции.

GWT-4: Внимание, зависящее от состояния

Это более продвинутая форма фокусировки. Система ИИ должна уметь переключать свое внимание в зависимости от текущего состояния или задачи.

Например, при навигации по комнате он может отдавать предпочтение сенсорным данным, а при решении головоломок переключиться на алгоритмы решения задач.

Вычислительные теории высшего порядка (HOT)

Теории высшего порядка подходят к сознанию с метакогнитивной точки зрения.

Они утверждают, что осознанный опыт - это не только восприятие, мысли или чувства, но и осознание того, что вы их испытываете.

Это осознание крайне важно, и отчасти именно поэтому высокоинтеллектуальные животные общительны - мы коллективно осознаем свое существование и взаимозависимость.

HOT-1: Генеративные, нисходящие или шумовые модули восприятия

Вместо того чтобы пассивно получать информацию, система интерпретирует или генерирует восприятие.

Представьте себе программу для редактирования фотографий, которая могла бы не просто изменить снимок, но и понять, почему необходимо скорректировать те или иные параметры.

HOT-2: Метакогнитивный мониторинг

Это означает, что система должна иметь "мыслительный процесс" о своих "мыслительных процессах".

Он должен уметь подвергать сомнению собственные решения и восприятие, как это делают люди и некоторые животные.

HOT-3: Агентство руководствуется общей системой формирования убеждений

Агентство здесь подразумевает, что система ИИ не просто пассивно анализирует данные - она принимает решения на основе своего анализа.

Более того, эти решения постоянно обновляют "убеждения" системы или модели данных, подобно тому, как люди создают прогрессивные знания через любопытство и исследования.

HOT-4: Способность удерживать предпочтения

Это относится к способности системы упорядочивать сложные данные в более простые и управляемые формы, что потенциально позволяет ей иметь субъективные "предпочтения" или "опыт".

Теория схем внимания (АСТ)

Теория схем внимания утверждает, что сознание возникает в результате осознания мозгом своего собственного состояния внимания.

AST-1: Предсказательная модель, представляющая текущее состояние внимания

Система искусственного интеллекта должна уметь прогнозировать, на чем она сосредоточится в следующий момент, что свидетельствует о своеобразном самоанализе собственного когнитивного состояния.

Предиктивная обработка (PP)

Модели обработки предсказаний описывают прогностические возможности мозга.

Он постоянно обновляет свои модели мира и использует их для прогнозирования поступающей сенсорной информации.

PP-1: Входные модули с использованием предиктивного кодирования

Это предполагает использование прошлых и текущих данных для прогнозирования будущих состояний, позволяя системе "предвидеть", а не просто "реагировать".

Агентство и воплощение (AE)

Теории агентства и воплощения предполагают, что способность действовать и понимать эффект действий являются критическими показателями сознания.

Воплощение очень характерно для животных и других живых организмов, которые обладают тесно связанными нервными системами, постоянно передающими сенсорную информацию к органам и центральным системам обработки.

AE-1: Агентство

Под управлением понимается обучение на основе обратной связи для адаптации будущих действий, в первую очередь при наличии противоречивых целей. Представьте себе самоуправляемый автомобиль, который учится оптимизировать как скорость, так и безопасность.

AE-2: Воплощение

Речь идет о способности системы понимать, как ее действия влияют на окружающий мир и как эти изменения, в свою очередь, повлияют на нее саму.

В настоящее время исследователи работают над системами ИИ, связанными с передовыми датчиками, такими как мультимодальная система ИИ PaLM-E, разработанная компанией Google, которая была одной из систем, проанализированных исследователями.

Сознание в ИИ: баланс между рисками заниженной и завышенной атрибуции

Исследователи и широкая общественность стремятся прояснить, насколько ИИ действительно разумен и движется ли он в сторону сознания.

Большинство публичных ИИ, таких как ChatGPT, являются "черными ящиками", то есть мы не до конца понимаем, как они работают - Их внутренняя механика является секретом.

Руководитель исследования Роберт Лонг подчеркнул необходимость междисциплинарного подхода к анализу машинного сознания, предостерегая от "риска ошибочно принять человеческое сознание за сознание в целом".

Колин Клейн, член команды из Австралийского национального университета, также обратил внимание на этические последствия сознания ИИ. Он объяснил, что очень важно понять сознание машины, "чтобы убедиться, что мы не относимся к ней неэтично, и чтобы не позволить ей относиться к нам неэтично".

Он также пояснил: "Идея заключается в том, что если мы сможем создать эти сознательные ИИ, то будем обращаться с ними как с рабами и делать с ними всевозможные неэтичные вещи".

"Другая сторона заключается в том, беспокоимся ли мы о себе, и какой контроль будет иметь над нами ИИ; сможет ли он манипулировать нами?"

Итак, каковы риски недооценки или переоценки сознания ИИ?

Недооценка машинного сознания

По мере того как достижения в области искусственного интеллекта продолжают расширять границы, этические споры вокруг этой технологии начинают накаляться.

Такие компании, как OpenAI, уже разрабатывают искусственный интеллект общего назначения (ИИОН)В ней предполагается выйти за рамки возможностей нынешних ИИ, таких как ChatGPT, и создать гибкие и мультимодальные системы.

Если мы признаем, что любая сущность, способная осознанно страдать, должна быть удостоена морального внимания - как это происходит со многими животными, - мы рискуем нанести моральный ущерб, если упустим возможность существования сознательных систем искусственного интеллекта.

Более того, мы можем недооценить их способность причинить нам вред. Представьте, какие риски несет в себе продвинутая сознательная система ИИ, которая понимает, что человечество плохо с ней обращается.

Переоценка машинного сознания

С другой стороны, существует риск чрезмерного приписывания сознания системам ИИ.

Люди склонны антропоморфировать ИИ, что приводит к тому, что многие ошибочно приписывают технологии сознание, поскольку она прекрасно подражает нам.

Как сказал Оскар Уайльд, "подражание - самая искренняя форма лести", и ИИ это удается исключительно хорошо.

Антропоморфизм становится проблематичным по мере того, как системы ИИ развивают человекоподобные характеристики, такие как способности к естественному языку и мимика.

Многие критиковали Блейка Лемуана из Google за то, что он позволил "обмануть" себя человекоподобными разговорными навыками LaMDA, хотя на самом деле он синтезировал текст из человеческих разговоров, содержащихся в его обучающих данных, а не что-то уникальное сознательного происхождения.

Эмоциональные потребности могут усилить склонность к антропоморфизму. Например, люди могут стремиться к социальному взаимодействию и эмоциональному одобрению со стороны систем ИИ, что искажает их суждения о сознании этих сущностей.

ИИ-чатбот Replika, как следует из названия, предназначен для копирования человеческого общения и был втянут в Заговор с целью убийства психически больного человека убить королеву Елизавету II, что привело к его аресту и заключению в психиатрическую клинику.

Другие ИИ, такие как Claude от Anthropic и Pi от Inflection, призваны в точности имитировать человеческий разговор и выступать в роли персональных помощников.

DeepMind также развитие лайф-коуча Чатбот, предназначенный для предоставления прямых персональных советов пользователям, - идея, которая вызвала опасения по поводу того, хотят ли люди, чтобы искусственный интеллект вмешивался в их личные дела.

Среди этих споров важно помнить, что технология остается молодой.

Хотя современные системы искусственного интеллекта не обладают устойчивым сознанием, в ближайшие несколько лет мы, несомненно, будем все ближе и ближе подходить к созданию сознательных искусственных систем, которые будут равны или превосходить когнитивные возможности биологического мозга.