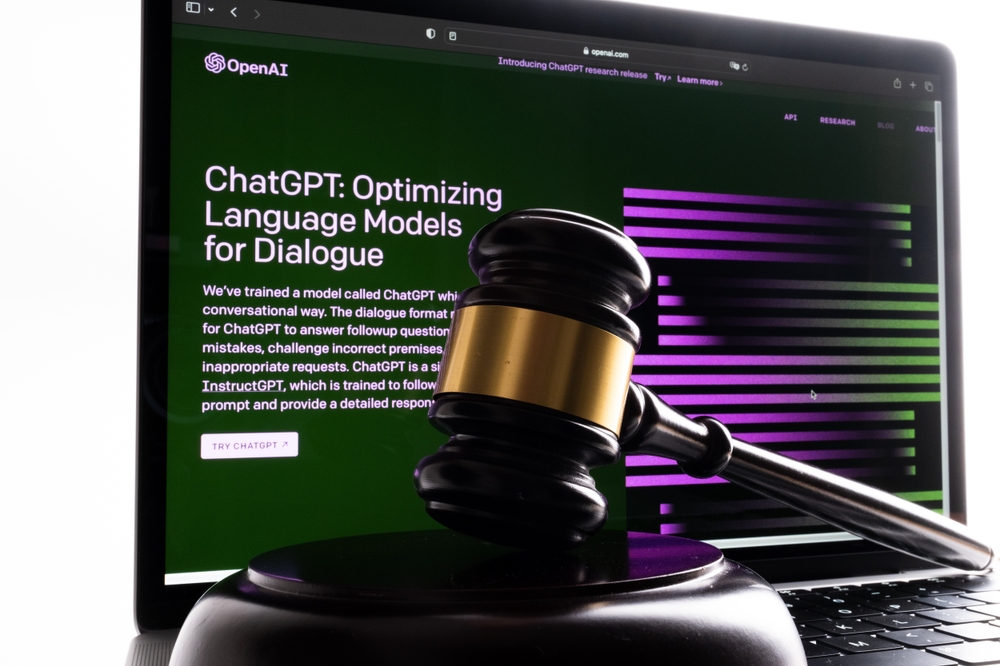

В конце мая нью-йоркский адвокат Стивен Шварц (Steven A Schwartz) использовал ChatGPT для изучения судебных дел по поручению клиента.

Шварц и его коллега из той же юридической фирмы, Питер ЛоДука, в четверг предстали перед судьей, чтобы объяснить свои действия.

На слушаниях оба адвоката признались, что ссылались на ложные судебные дела, сгенерированные ChatGPT.

Шварц использовал ChatGPT для поиска юридических прецедентов в поддержку дела клиента против колумбийской авиакомпании Avianca, к которой AI вернул несколько ложных случаев и один реальный случай с грубо измененными деталями.

Шварц процитировал их в записке истца, но когда окружной судья США Кевин Кастел получил ее, он быстро заметил следующее фиктивные дела и заявил: "Шесть из представленных дел, похоже, являются фиктивными судебными решениями с фиктивными цитатами и фиктивными внутренними ссылками".

"Я не понимал, что ChatGPT может фабриковать дела", - признался Шварц Кастелю, признав, что "действовал в заблуждении... что этот сайт получал эти дела из какого-то источника, к которому у меня не было доступа".

Судья Кастель столкнул их с конкретным сфабрикованным судебным делом, которое должно было показаться Шварцу ложным. Сначала дело было описано как дело о неправомерной смерти, но затем трансформировалось в дело о человеке, который опоздал на самолет и был вынужден оплатить дополнительные расходы.

Другими словами, даже неспециалисту было очевидно, что это дело ложное, поэтому Шварц, скорее всего, не прочитал вывод ИИ должным образом. "Можем ли мы согласиться с тем, что это юридическая тарабарщина?" сказал Кастель о деле.

Шварц принес глубокие извинения: "Я хотел бы искренне извиниться", и сказал, что чувствует себя "смущенным, униженным и крайне раскаивается".

ЛоДука признал, что недостаточно внимательно изучил материалы, составленные Шварцем. Он сказал: "Мне и в голову не приходило, что это было фиктивное дело", и такой исход "не дает мне покоя".

Что касается того, понесет ли дуэт наказание, адвокат Рональд Минкофф утверждает, что действия пары "были результатом небрежности, а не недобросовестности" и, следовательно, не должны быть наказаны.

Минкофф утверждал: "Мистер Шварц, который почти не занимается федеральными исследованиями, решил использовать эту новую технологию. Он думал, что имеет дело с обычной поисковой системой".

Окончательный вердикт по санкциям еще не вынесен.

ИИ "галлюцинации" создают этические и юридические проблемы

Последовательность судебные дела наносят удар по OpenAIВ том числе три случая потенциальной клеветы, которые возникли, когда выходные данные ChatGPT содержали ложную и клеветническую информацию.

Здесь результат другой. Это пример неправомерного поведения, вызванного советами, взятыми из результатов работы ChatGPT.

Дэниел Шин, адъюнкт-профессор и помощник директора по исследованиям Центра юридических и судебных технологий в Школе права Уильяма и Мэри, сказал: "Это первый задокументированный случай потенциального профессионального нарушения со стороны адвоката, использующего генеративный ИИ".

То, что кто-то совершит эту ошибку, было лишь вопросом времени. Шварц стал первым (насколько нам известно) в том прецеденте, который он, вероятно, не ожидал создать.