Компании, занимающиеся разработкой искусственного интеллекта, настаивают на регулировании. Что ими движет - паранойя или альтруизм? Или регулирование обеспечивает конкурентные цели?

В начале мая Люк Сернау, старший инженер-программист Google, написал неофициальную записку об ИИ с открытым исходным кодом. Она была широко распространена во внутренних системах Google, после чего консалтинговая компания Semi-Analysis, проверил и опубликовал его.

Вот некоторые выдержки:

"Мы в OpenAI часто оглядываемся через плечо. Кто преодолеет следующий рубеж? Каким будет следующий шаг?

Но неудобная правда заключается в том, что мы не в состоянии выиграть эту гонку вооружений, как и OpenAI. Пока мы препирались, третья фракция спокойно съедала наш обед. Я говорю, конечно же, об открытом исходном коде.

Проще говоря, они нас обгоняют. Вещи, которые мы считали "основными открытыми проблемами", уже решены и находятся в руках людей. И хотя наши модели все еще имеют небольшое преимущество в плане качества, разрыв сокращается поразительно быстро.

Модели с открытым исходным кодом быстрее, более настраиваемы, более приватны, и в фунтах стерлингов имеют больше возможностей. Они делают с параметрами $100 и 13B то, с чем мы с трудом справляемся на $10M и 540B. И делают они это за недели, а не за месяцы.

В начале марта сообщество разработчиков с открытым исходным кодом получило в свои руки первую действительно способную модель фундамента, так как LLaMA от Meta стала достоянием общественности.

В нем не было ни инструкций, ни разговорной мелодии, ни RLHF. Тем не менее, сообщество сразу же поняло значение того, что им было дано. Вслед за этим последовал огромный поток инноваций, причем между основными событиями проходило всего несколько дней...

Прошел всего месяц, а уже есть варианты с настройкой инструкций, квантованием, улучшением качества, человеческими испытаниями, мультимодальностью, RLHF и т. д. и т. п., многие из которых опираются друг на друга. Самое главное - они решили проблему масштабирования до такой степени, что каждый может возиться.

Многие новые идеи приходят от обычных людей. Барьер для обучения и экспериментов снизился с общего объема работы крупной исследовательской организации до одного человека, вечера и мощного ноутбука".

Записка Сернау была подхвачена крупными новостными изданиями и вызвала дискуссию о том, не скрывается ли за стремлением больших технологий к регулированию мотив вытеснения ИИ с открытым исходным кодом из игры. Бен Шрексингер из Politico пишетКроме того, "код с открытым исходным кодом сложнее запретить, поскольку новые экземпляры могут появиться, если регулирующие органы попытаются закрыть использующий его веб-сайт или инструмент. В сочетании с другими децентрализующими функциями эти проекты с открытым исходным кодом способны нарушить не только бизнес-модель Кремниевой долины, но и модели управления Вашингтона и Брюсселя".

Сообщество ИИ с открытым исходным кодом уже процветает. Разработчики в считанные дни решают задачи, на которые у Google и OpenAI уходят месяцы или годы. Сернау утверждает, что гибкие сообщества разработчиков с открытым исходным кодом лучше приспособлены для создания итерационных моделей, чем большие технологии, поскольку они более разнообразны, эффективны и прагматичны.

Если это так, то господство больших технологий над ИИ может оказаться недолгим.

Утечка Meta LLaMA

Модель LLaMA компании Meta, большая языковая модель (LLM), подобная ChatGPT, была просочилась на 4chan через неделю после того, как компания разослала запросы на доступ. 3 марта на форуме сообщений появился загружаемый торрент, который распространился как лесной пожар.

Как указывает Сернау, сообщество разработчиков с открытым исходным кодом продолжило модифицировать LLaMA, добавив впечатляющую функциональность без использования компьютерных ресурсов предприятия.

Создание мощных моделей ИИ сейчас дешевле, чем когда-либо, и сообщества разработчиков с открытым исходным кодом стремятся демократизировать доступ к ним. В то время как LLaMA является в значительной степени предварительно обученной моделью, другие модели с открытым исходным кодом, такие как BLOOM, были обучены добровольцами.

Для обучения BLOOM потребовался суперкомпьютер, оснащенный 384 графическими процессорами NVIDIA A100 80GB, который, к счастью, был предоставлен французским правительством. Компания Together, занимающаяся разработкой ИИ с открытым исходным кодом, недавно объявила о финансировании в размере $20 млн, а облачные провайдеры, ориентированные на ИИ, такие как CoreWeave предлагают оборудование по ценам ниже рыночных.

У проектов с открытым исходным кодом есть различные способы сосредоточить ресурсы и обойти большие технологии. Большим технологиям, вероятно, хотелось бы, чтобы мы думали, что их ИИ - продукт десятилетий работы и миллиардов долларов инвестиций. - сообщество разработчиков открытого программного обеспечения, вероятно, не согласно с этим.

На тему того, что большие технологии отделяют себя от мелких ИИ-проектов, на одном из мероприятий в Индии бывший руководитель Google Раджан Анандан спросил генерального директора OpenAI Сэма Альтмана, смогут ли индийские инженеры построить фундаментальные модели ИИ, получив инвестиции в размере $10 млн.

Альтман ответил: "Конкурировать с нами в области подготовки базовых моделей совершенно безнадежно. Вы не должны пытаться, и ваше дело - любить попытки в любом случае". И я верю в обе эти вещи. Я думаю, что это довольно безнадежно".

Но в своей записке Сернау говорит о том, что open-source уже конкурирует с большими технологиями. Он говорит: "Удержать конкурентное преимущество в области технологий становится еще сложнее теперь, когда передовые исследования в области LLM стали доступными. Исследовательские институты по всему миру опираются на наработки друг друга, исследуя пространство решений в широком масштабе, который намного превосходит наши собственные возможности".

Разработчики с открытым исходным кодом создают альтернативы ИИ больших технологий и обгоняют их по производительности и статистике пользователей.

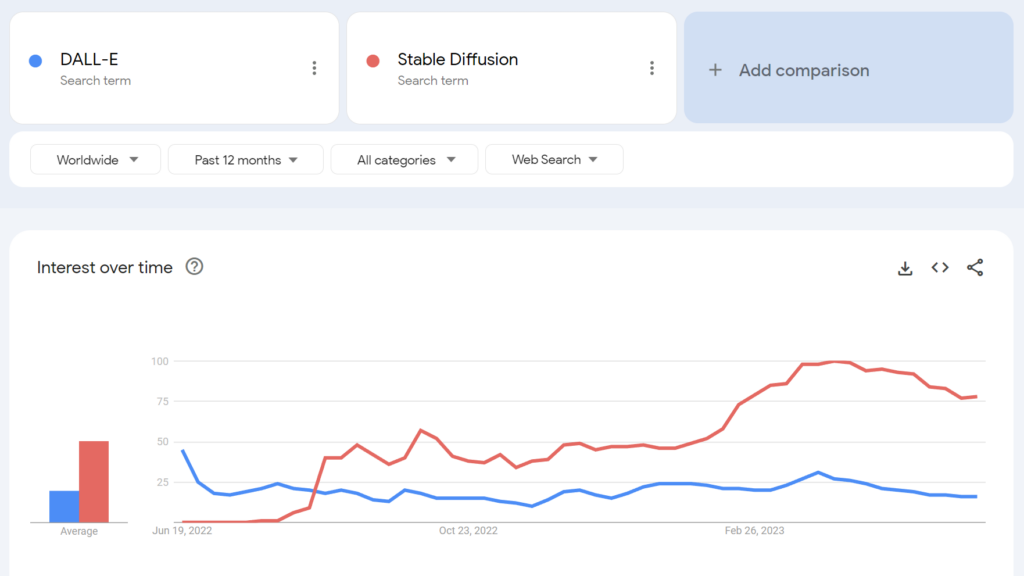

Например, Stable Diffusion с открытым исходным кодом стал более популярным, чем DALL-E от OpenAI, в течение нескольких месяцев после запуска.

В какой степени мы можем разглядеть здесь потенциальные скрытые мотивы? Есть ли у больших технологий, добивающихся регулирования, альтруистические цели?

Сообщество ИИ с открытым исходным кодом

Помимо LLaMA, существует как минимум три крупных примера проектов ИИ с открытым исходным кодом:

- Обнимающееся лицо и BLOOM - ИИ-компания Hugging Face совместно с более чем 1000 ученых-добровольцев разработала BLOOM, LLM с открытым исходным кодом. BLOOM призван предложить более прозрачный и доступный аналог собственным моделям ИИ.

- Вместе - ИИ-стартап под названием Together успешно привлек $20 миллионов посевного финансирования для поддержки своей цели - создания децентрализованных альтернатив закрытым системам ИИ. Они представили несколько инициатив по созданию генеративного ИИ с открытым исходным кодом, включая GPT-JT, OpenChatKit и RedPajama.

- Стабильность AI - В апреле 2023 года компания Stability AI, стоящая за Stable Diffusion, запустила StableLM, последовательность альтернатив ChatGPT с открытым исходным кодом.

Стоит отметить, что если некоторые из этих разработчиков (например, Stable Diffusion) предлагают свои модели с помощью интуитивно понятных и простых в использовании приборных панелей, то другие, такие как BLOOM, требуют значительных ресурсов для запуска. Для начала вам потребуется около 360 ГБ оперативной памяти для работы BLOOM, но есть много интересных приемов, позволяющих снизить требования к ресурсам.

По мере того как аппаратные средства с поддержкой ИИ будут дешеветь, а модели с открытым исходным кодом станут проще в развертывании, вполне возможно, что практически любой человек сможет развернуть модели, подобные ChatGPT. В утечке служебной записки Google приводятся примеры того, как люди настраивали и внедряли LLaMA на потребительских устройствах, включая MacBook.

Для предприятий со значительными ИТ-ресурсами, Модели с открытым исходным кодом позволяют экономить деньги и обеспечивают суверенитет данных и контроль над обучением и оптимизацией.

Однако не все с оптимизмом смотрят на влияние мощного ИИ с открытым исходным кодом. Например, исследователь в области кибербезопасности Джеффри Ладис написал в Твиттере: "Готовьтесь к большому количеству персонализированного спама и попыток фишинга" и "Открытая разработка этих моделей была ужасной идеей".

Распространение ИИ делает нас всех менее безопасными. Кажется, что это хорошая вещь, которую нужно предотвратить, и в то же время довольно сложная задача!

Я не удивлюсь, если в ближайшие год-два кому-нибудь из государственных деятелей удастся завладеть моделями рубежей OpenAI. https://t.co/PUEWvfUFqk

- Джеффри Ладиш (@JeffLadish) 10 мая 2023 года

Другой наблюдатель написал в твиттере: "Открытый исходный код - это угроза, но не в том смысле, как вы думаете. Это угроза, потому что ИИ в руках людей, которые могут использовать его в своих целях, становится еще сложнее регулировать или отслеживать, а это уже большая проблема".

Google и OpenAI утверждают, что они боятся ИИ с открытым исходным кодом, что между ними "нет рва". Но на самом деле это не так.

Открытый исходный код - это угроза, но не в том смысле, в котором вы думаете. Это угроза, потому что ИИ в руках людей, которые могут использовать его в своих целях, становится еще сложнее... pic.twitter.com/g6kMh3TshY

- Тео (@tprstly) 5 мая 2023 года

Янн ЛеКун, которого часто считают "крестным отцом ИИ" наряду с Джеффри Хинтоном и Йошио Бенгманом, утверждает обратное"Как только LLM станут основным каналом, по которому каждый получает доступ к информации, люди (и правительства) будут *требовать*, чтобы она была открытой и прозрачной. Базовая инфраструктура должна быть открытой".

ЛеКун также не согласен с мейнстримом в отношении рисков ИИ: "Я думаю, что масштабы проблемы согласования ИИ были нелепо раздуты, а наша способность решить ее сильно недооценена". Элон Маск ответил в Twitter: "Вы действительно считаете, что ИИ - это острый меч?"

Вы действительно считаете, что ИИ - это острый меч?

- Элон Маск (@elonmusk) 1 апреля 2023 года

Другие комментаторы проводили параллели между регулированием ИИ и криптографией, где правительство США пыталось запретить публичные криптографические методы путем классифицируя их как "боеприпасы". - прозвали "криптовалютными войнами".

Сейчас практически все имеют право использовать шифрование, но эта битва была выиграна с большим трудом, как и в случае с ИИ с открытым исходным кодом.

OpenAI отчуждает ИИ с открытым исходным кодом

Открытый исходный код - это не просто программное обеспечение, код и технология. Это принцип, образ мышления или вера в то, что совместная, открытая и прозрачная рабочая среда превосходит конкуренцию на закрытом рынке.

OpenAI, некогда некоммерческая компания, ориентированная на общественное сотрудничество и разработки с открытым исходным кодом, неуклонно отходит от своего тезки.

В 2019 году стартап перешел в статус "коммерческой" компании, фактически прекратив отношения с сообществом разработчиков открытого кода. Инвестиции со стороны Microsoft лишили OpenAI возможности вести какую-либо "открытую" научно-исследовательскую деятельность.

В середине мая компания объявила о модель с открытым исходным кодом в разработкеНо они не были откровенны в деталях.

Теперь OpenAI настаивает на регулировании, которое больше всего ударит по компаниям, создающим ИИ, не говоря уже о потенциальной криминализации сообщества разработчиков с открытым исходным кодом.

Это привело к тому, что некоторые критикуют стремление OpenAI к регулированию как не более чем бизнес - бизнес по защите своих прибыльных моделей от сообществ с открытым исходным кодом, стремящихся к демократизации ИИ.

Является ли ИИ с открытым исходным кодом риском для больших технологий?

Сочетание утечки меморандума Google, стремления больших технологий к регулированию и принижения Альтманом низовых проектов ИИ заставляет задуматься. Действительно, обоснованность рисков ИИ, которые оправдывают регулирование, была поставлена под сомнение.

Например, когда Центр безопасности ИИ (CAIS) опубликовал свое сейсмическое заявление о рисках ИИ, подписанное несколькими руководителями ИИ, некоторые внешние наблюдатели не были убеждены в этом.

В подборке реакций экспертов на заявление Опубликовано Научным медиацентромДоктор Мейри Эйткен, научный сотрудник по этике Института Алана Тьюринга, сказала:

"В последнее время подобные заявления все чаще звучат от крупных технологических игроков, преимущественно из Кремниевой долины. Хотя некоторые считают, что это связано с их осведомленностью о достижениях в области технологий, я думаю, что на самом деле это служит способом отвлечения внимания. Это отвлекает внимание от решений крупных технологов (людей и организаций), которые разрабатывают ИИ и стимулируют инновации в этой области, и вместо этого фокусирует внимание на гипотетических сценариях будущего и воображаемых будущих возможностях ИИ".

Некоторые утверждают, что большие технологии обладают достаточной мощью, чтобы выделить ресурсы на этику, управление и мониторинг, что позволит им избавиться от худших последствий регулирования и продолжать продавать свои продукты.

Однако одновременно проблематично считать риски ИИ фантазиями и утверждать, что регулирование не имеет смысла.

Скептики есть в обоих лагерях.

Отрицание рисков ИИ как чисто умозрительных может оказаться критической ошибкой для человечества.

Действительно, комментаторы, не имеющие конфликта интересов, предупреждали об ИИ на протяжении десятилетий, включая покойного профессора Стивена Хокинга, который сказал, что ИИ "может означать конец человеческой расы" и стать "худшим событием в истории нашей цивилизации".

Хотя некоторые могут утверждать, что большие технологии используют видения ИИ-апокалипсиса для укрепления рыночных структур и повышения барьеров для входа на рынок, это не отменяет легитимности рисков, связанных с ИИ.

Например, исследовательские группы уже доказали способность ИИ к автономному установите новые цели с потенциально катастрофическими последствиями.

Другие эксперименты показывают, что ИИ могут активно собирать ресурсы, накапливать энергию и предпринимать упреждающие шаги, чтобы не дать себя "выключить". Достоверные исследования показывают, что по крайней мере некоторые риски ИИ не слишком преувеличены.

Совместимые взгляды?

Вопрос в том, можем ли мы доверить себе исключительно мощный ИИ? Под "самими собой" подразумеваются люди повсюду, на всех уровнях, от крупных исследовательских лабораторий до сообществ, создающих ИИ с открытым исходным кодом.

Большие технологии, возможно, хотят консолидировать рыночные структуры и в то же время выразить искреннее беспокойство по поводу будущего ИИ. Эти два варианта не обязательно являются взаимоисключающими.

Между тем, рост ИИ с открытым исходным кодом неизбежен, и регулирование чревато недовольством среди сообщества, владеющего одной из самых опасных технологий человечества.

Уже слишком поздно подчинять себе ИИ с открытым исходным кодом с помощью регулирования, а попытки сделать это могут привести к разрушительной эре запрета ИИ.

В то же время дискуссии об опасностях ИИ должны вестись на основе фактических данных - единственного объективного сигнала, который мы имеем о потенциальном вреде этой технологии.