Un'inchiesta del Guardian ha fatto luce sull'uso pervasivo dell'IA e di algoritmi complessi in vari processi decisionali del settore pubblico nel Regno Unito.

I dipendenti pubblici di almeno otto dipartimenti del settore pubblico, insieme a diverse unità di polizia, hanno incorporato strumenti di IA nei loro flussi di lavoro.

Gli strumenti di intelligenza artificiale hanno assistito processi decisionali cruciali nei settori del welfare, dell'immigrazione e della giustizia penale. L'indagine ha rivelato prove di abuso e discriminazione.

Sebbene i pregiudizi legati agli algoritmi e all'IA non rientrino strettamente nella stessa definizione, entrambi rischiano di ottenere risultati distorti quando vengono esposti a scenari reali. I modelli di apprendimento automatico ad autoapprendimento possono amplificare le distorsioni predominanti negli insiemi di dati.

Secondo il rapporto:

- Un parlamentare ha sollevato dubbi su un algoritmo utilizzato dal Dipartimento per il lavoro e le pensioni (DWP), che si sospetta abbia erroneamente fatto perdere i benefici a numerose persone.

- È stato riscontrato che lo strumento di riconoscimento facciale della polizia metropolitana presenta un tasso di errore più elevato nell'identificazione dei volti neri rispetto a quelli bianchi in determinate condizioni. Si tratta di un fenomeno ormai consolidato, con uno studio indicando che queste piattaforme hanno offerto una precisione di un misero 2% nel 2018.

- Il Ministero dell'Interno ha utilizzato un algoritmo che prende di mira in modo sproporzionato individui di specifiche nazionalità per scoprire matrimoni fraudolenti per ottenere benefici e agevolazioni fiscali. I cittadini di Albania, Grecia, Romania e Bulgaria potrebbero essere stati ingiustamente segnalati.

Gli strumenti di intelligenza artificiale apprendono modelli da ampie serie di dati. Se le serie di dati sono distorte o poco rappresentative della realtà, il modello eredita tali modelli.

Esistono molti esempi internazionali di pregiudizi legati all'IA e agli algoritmi, tra cui false corrispondenze di riconoscimento facciale che portano all'incarcerazione, sistemi di valutazione del credito infliggere pregiudizi alle donnee gli strumenti discriminatori utilizzati nei tribunali e nei sistemi sanitari.

Il rapporto del Guardian sostiene che il Regno Unito si trova ora sull'orlo di un potenziale scandalo, con esperti che esprimono preoccupazioni sulla trasparenza e sulla comprensione degli algoritmi utilizzati dai funzionari.

Gli scandali hanno già sono stati testimoniati in altri paesicome negli Stati Uniti, dove le piattaforme di polizia predittiva sono state smantellatee nei Paesi Bassi, dove i tribunali si sono opposti a un sistema di intelligenza artificiale progettato per ridurre le frodi sociali.

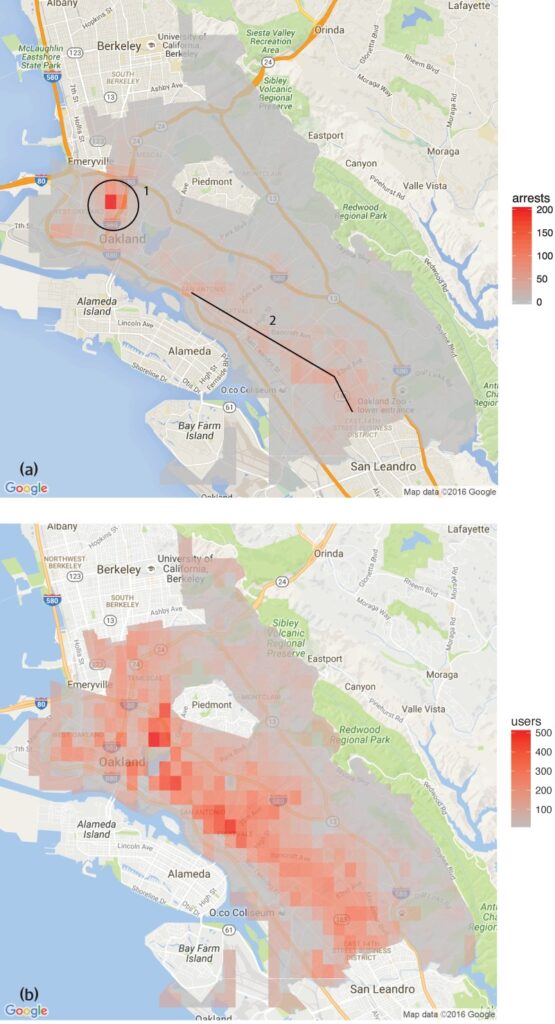

Uno studio condotto dal Gruppo di analisi dei dati sui diritti umani ha scoperto che il software di polizia predittiva in uso a Oakland, in California, prendeva di mira in modo sproporzionato le comunità di colore, perpetuando un ciclo di sovrapolizia in questi quartieri.

Questo riflette le preoccupazioni sollevate dal Lo strumento di riconoscimento facciale della Polizia Metropolitanache ha dimostrato tassi di errore più elevati nell'identificazione di volti neri in determinate condizioni.

Ci sono diversi esempi anche nel settore sanitario, come le incongruenze nei modelli di intelligenza artificiale progettati per aiutare a rilevare il cancro della pelle. Nella maggior parte dei casi, i gruppi minoritari e le donne sono i più a rischio.

Shameem Ahmad, direttore generale del Public Law Project, ha sottolineato la necessità di un'azione immediata, affermando: "L'intelligenza artificiale ha un enorme potenziale di utilità sociale. Ad esempio, possiamo rendere le cose più efficienti. Ma non possiamo ignorare i gravi rischi. Senza un'azione urgente, potremmo camminare nel sonno verso una situazione in cui sistemi automatizzati opachi vengono regolarmente utilizzati, forse illegalmente, in modi che alterano la vita, e in cui le persone non saranno in grado di chiedere un risarcimento quando questi processi vanno male".

Facendo eco a queste preoccupazioni, Marion Oswald, docente di diritto alla Northumbria University, ha evidenziato le incoerenze e la mancanza di trasparenza nell'utilizzo dell'IA nel settore pubblico, affermando: "C'è una mancanza di coerenza e di trasparenza nel modo in cui l'IA viene utilizzata nel settore pubblico. Molti di questi strumenti influenzeranno molte persone nella loro vita quotidiana, ad esempio coloro che richiedono sussidi, ma le persone non capiscono perché vengono utilizzati e non hanno la possibilità di contestarli".

I rischi dell'IA per il settore pubblico

L'applicazione incontrollata dell'IA nei dipartimenti governativi e nelle forze di polizia solleva preoccupazioni in merito a responsabilità, trasparenza e pregiudizi.

Nel caso del Dipartimento per il lavoro e le pensioni (DWP), il rapporto del Guardian ha rivelato casi in cui un algoritmo ha sospeso i benefici delle persone senza una chiara spiegazione.

La deputata Kate Osamor ha dichiarato che i suoi elettori bulgari hanno perso i loro sussidi a causa di un sistema semi-automatico che segnalava i loro casi come potenziali frodi, evidenziando una mancanza di trasparenza.

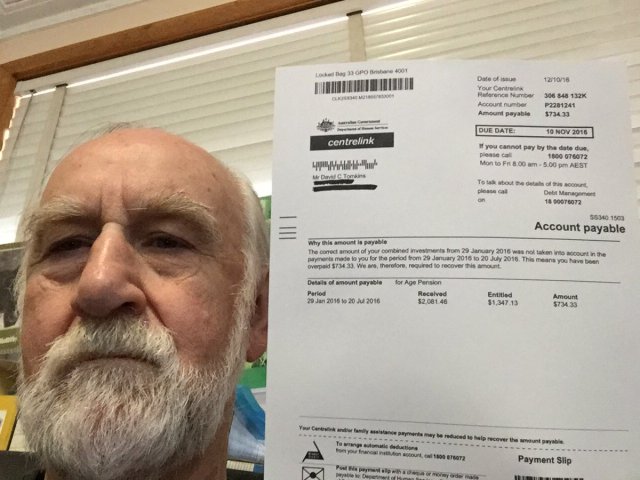

Questo ricorda il Scandalo "Robodebt" in Australiadove un sistema automatizzato ha accusato erroneamente più di 400.000 persone di frode assistenziale, causando un disagio diffuso.

Lo scandalo Robodebt, oggetto di indagini da parte del Commonwealth Ombudsman, di ricorsi legali e di inchieste pubbliche, ha dimostrato la portata dell'impatto inflitto dal processo decisionale algoritmico.

Il governo australiano ha accettato una cifra di $1,8 miliardi di AUS nel 2021.

Le carenze dell'IA non si limitano ai servizi pubblici. Anche il mondo delle aziende ha assistito a fallimenti, in particolare negli strumenti di reclutamento basati sull'IA.

Un esempio significativo è lo strumento di reclutamento AI di Amazon, che ha mostrato pregiudizi nei confronti delle candidate donne. Il sistema è stato addestrato sui curriculum inviati all'azienda in un periodo di 10 anni, la maggior parte dei quali proveniva da uomini, con il risultato che l'IA ha favorito i candidati maschi.

Tre esempi di pregiudizi algoritmici di cui diffidare

Man mano che l'IA e il processo decisionale algoritmico si integrano nei complessi processi della società, aumentano gli esempi allarmanti di pregiudizi e discriminazioni.

Il sistema sanitario e giudiziario degli Stati Uniti

Uno studio del 2019 pubblicato su Science ha rivelato che un algoritmo sanitario ampiamente utilizzato negli Stati Uniti presenta pregiudizi razziali. L'algoritmo aveva meno probabilità di indirizzare le persone di colore a programmi progettati per migliorare l'assistenza ai pazienti con esigenze mediche complesse rispetto alle loro controparti bianche.

Lo studio spiega perché: "Il pregiudizio si verifica perché l'algoritmo utilizza i costi sanitari come proxy dei bisogni sanitari. Si spendono meno soldi per i pazienti neri che hanno lo stesso livello di necessità, e l'algoritmo conclude quindi erroneamente che i pazienti neri sono più sani di quelli bianchi ugualmente malati".

Un altro esempio critico è l'uso dell'IA nella polizia predittiva e nelle sentenze giudiziarie. Strumenti come Profilazione della gestione dei detenuti per le sanzioni alternative (COMPAS) sono stati utilizzati per valutare il rischio di recidiva degli imputati.

Le indagini hanno rivelato che questi strumenti possono essere prevenuti nei confronti degli imputati afroamericani, assegnando loro punteggi di rischio più elevati rispetto alle loro controparti bianche. Ciò solleva preoccupazioni circa l'equità e l'imparzialità del processo giudiziario assistito dall'intelligenza artificiale.

Riconoscimento facciale in Brasile

Il Progetto Smart Sampa a San PaoloBrasile, ha segnato una tappa significativa nell'integrazione dell'intelligenza artificiale e della sorveglianza all'interno dei paesaggi urbani, cosa che era tipica solo della Cina.

Entro il 2024, l'obiettivo è installare fino a 20.000 telecamere a San Paolo e integrare un numero uguale di telecamere di terzi e private in un'unica piattaforma di videosorveglianza. Questa rete sorveglierà spazi pubblici, strutture mediche e scuole e controllerà i contenuti dei social media rilevanti per la pubblica amministrazione.

Se da un lato Smart Sampa promette maggiore sicurezza e migliori servizi pubblici, dall'altro gli esperti avvertono che potrebbe esacerbare i problemi sociali esistenti, in particolare il razzismo strutturale e la disuguaglianza.

Oltre 90% delle persone arrestate in Brasile sulla base del riconoscimento facciale sono di colore. L'iniziativa di San Paolo rischia di perpetuare questa tendenza, emarginando ulteriormente la comunità nera, che costituisce il 56% della popolazione brasiliana.

Le tecnologie di riconoscimento facciale spesso identificano in modo errato le tonalità di pelle più scure, in parte perché la tecnologia di imaging non è all'altezza delle carnagioni più scure e in parte perché i set di dati di addestramento non sono rappresentativi.

Fernanda Rodrigues, avvocato specializzato in diritti digitali, ha sottolineato il potenziale di falsi positivi e il conseguente rischio di incarcerazione di massa di persone di colore.

Rodrigues ha dichiarato: "Oltre al rischio che le informazioni fornite a queste piattaforme non siano accurate e che il sistema stesso possa fallire, c'è un problema che precede le implicazioni tecnologiche, ovvero il razzismo".

"Sappiamo che il sistema penale in Brasile è selettivo, quindi possiamo concludere che [l'uso della sorveglianza con il riconoscimento facciale] aumenta i rischi e i danni per questa popolazione", ha aggiunto.

Anche le preoccupazioni relative alla privacy sono di primaria importanza. I critici sostengono che Smart Sampa potrebbe violare i diritti umani fondamentali, tra cui la privacy, la libertà di espressione, di riunione e di associazione. La natura opaca del progetto ha complicato ulteriormente le cose, con un coinvolgimento limitato del pubblico durante la fase di consultazione.

Smart Sampa non è rimasto incontrastato. I pubblici ministeri hanno indagato e le organizzazioni per i diritti umani hanno avviato azioni legali per fermare la tecnologia.

L'indicazione di rischio del sistema olandese (SyRI)

Nel 2022, il tribunale distrettuale dell'Aia ha esaminato l'impiego da parte del governo olandese di Indicazione di rischio del sistema (SyRI), un algoritmo progettato per rilevare potenziali frodi sociali.

Il SyRI aveva l'obiettivo di migliorare l'efficienza nell'identificazione delle frodi previdenziali, aggregando dati provenienti da diversi database governativi e applicando indicatori di rischio per generare profili di potenziali frodatori. Tuttavia, le decisioni sospette e la mancanza di trasparenza hanno fatto scattare un campanello d'allarme, portando a un ricorso legale da parte di una coalizione di organizzazioni della società civile.

I querelanti hanno sostenuto che SyRI ha violato diverse leggi internazionali ed europee sui diritti umani. Hanno inoltre messo in dubbio la legalità, la necessità e la proporzionalità dell'applicazione dell'algoritmo.

La Corte distrettuale dell'Aia ha stabilito che la legislazione che regola il SyRI e la sua applicazione non soddisfa gli standard necessari in materia di diritti umani. Il tribunale ha evidenziato la mancanza di trasparenza e il potenziale di effetti discriminatori, sottolineando la necessità di adeguate garanzie legali quando si implementano tali tecnologie.

Il caso è stato salutato come uno dei primi ad affrontare l'impatto sui diritti umani dell'IA nel settore pubblico, evidenziando la necessità di trasparenza, responsabilità e quadri giuridici solidi.

La verifica trasparente ed equa degli strumenti è fondamentale

Sulla scia delle recenti sfide legali e dello scrutinio pubblico che ha interessato il processo decisionale algoritmico nelle operazioni governative, l'invito a testare in modo trasparente gli strumenti di IA è diventato sempre più urgente.

Garantire la responsabilità, prevenire la discriminazione e mantenere la fiducia del pubblico dipende dall'implementazione di protocolli di test rigorosi e aperti.

La trasparenza dei test consente di comprendere a fondo il funzionamento di questi algoritmi, i dati che utilizzano e i processi decisionali che seguono. Questo è fondamentale per identificare potenziali pregiudizi, imprecisioni o pratiche discriminatorie incorporate nel sistema.

Tuttavia, le rigorose procedure di test sono in contrasto con la promessa di una rapida efficienza dell'IA.

Nel caso del Regno Unito, il Primo Ministro Rishi Sunak stancante innovazione".e forse non lascia abbastanza spazio a procedure di test complete. Inoltre, ci sono pochi - se non nessuno - processi concordati per testare gli strumenti di IA prima di distribuirli per l'uso pubblico.

Questo scenario si rispecchia in tutto il mondo. Il rapido aumento dell'adozione dell'IA non dovrebbe avvenire a costo di controlli e analisi.