Nel 1956, Philip K. Dick scrisse una novella intitolata "Rapporto di minoranza" che raccontava di un futuro in cui i "precog" potevano prevedere i crimini prima che si verificassero nella realtà.

Qualche decennio dopo, Tom Cruise ha portato questa inquietante visione sul grande schermo, dando la caccia ad aspiranti criminali sulla base di queste previsioni.

Entrambe le versioni ci hanno costretto a contemplare le implicazioni etiche dell'essere arrestati per qualcosa che si potrebbe fare in futuro.

Oggi, mentre i metodi di polizia predittiva si fanno strada nelle moderne forze dell'ordine, ci si deve chiedere: siamo sul punto di realizzare la preveggente narrazione di Dick?

Che cos'è la polizia predittiva e come funziona?

La polizia predittiva fonde le forze dell'ordine e l'analisi avanzata, sfruttando l'apprendimento automatico per anticipare le attività criminali prima che si verifichino.

La premessa è abbastanza semplice sulla carta: se riusciamo a decodificare gli schemi nascosti nei dati storici sui crimini, possiamo creare algoritmi per prevedere gli eventi futuri.

Il processo inizia con l'accumulo di dati storici sui crimini, feed di sorveglianza, chiacchiere sui social media e persino sfumature come le fluttuazioni meteorologiche. Questo vasto archivio di informazioni viene poi inserito in sofisticati modelli di apprendimento automatico progettati per discernere gli schemi sottostanti.

Ad esempio, il modello potrebbe rilevare che in un determinato quartiere si registra un picco di furti nelle notti dei fine settimana piovosi.

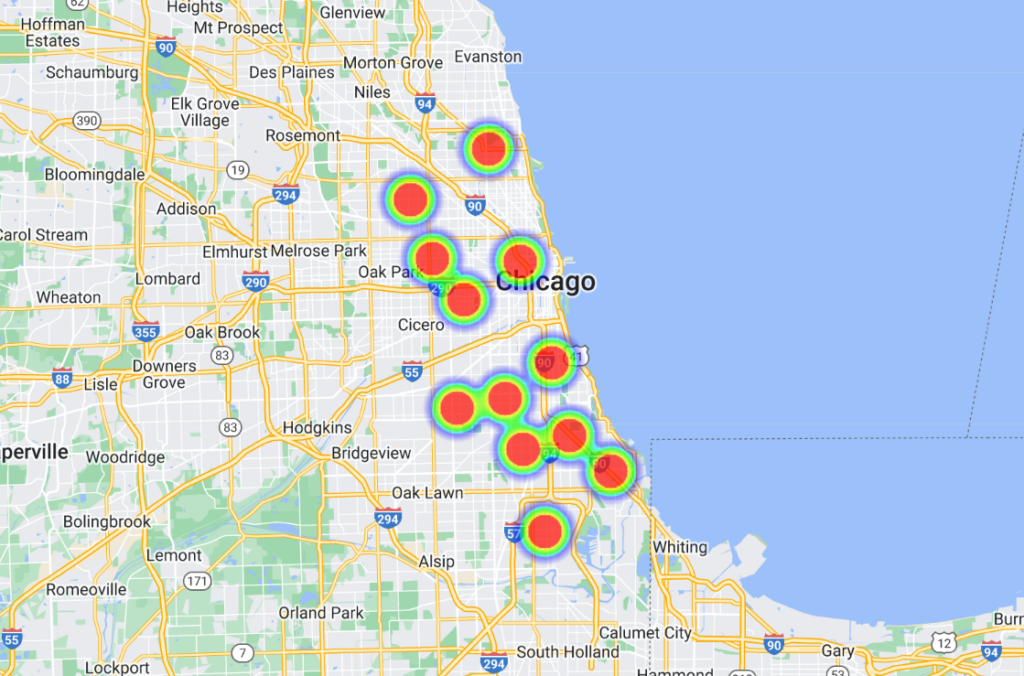

Una volta individuate queste correlazioni, le piattaforme software avanzate le trasformano in rappresentazioni visive, spesso simili a "mappe di calore" che evidenziano i probabili punti caldi della criminalità. Questo, a sua volta, consente alla polizia di allocare le proprie risorse in modo proattivo, ottimizzando le pattuglie e gli interventi.

Alcuni modelli si sono spinti oltre, elencando le persone per nome e indirizzo, dotando gli agenti di previsioni altamente specifiche e localizzate.

La storia della polizia predittiva

La tecnologia di polizia predittiva è ancora in fase embrionale e, sebbene ci siano stati alcuni attori influenti nel settore, come Palantir, l'industria è piccola.

Nel giugno 2022, l'Università di Chicago sviluppato un modello di intelligenza artificiale in grado di prevedere i luoghi e i tassi di criminalità all'interno della città con una precisione presunta di 90%.

Attingendo ai dati aperti sulla criminalità dal 2014 al 2016, il team ha suddiviso Chicago in quadrati di circa 300 metri. Il modello è stato in grado di prevedere, con una settimana di anticipo, la piazza con la più alta probabilità di accadere un crimine.

Lo studio aveva intenzioni oneste, portando alla luce pregiudizi spaziali e socioeconomici negli sforzi della polizia e nell'allocazione delle risorse. Ha rilevato che i quartieri benestanti hanno ricevuto più risorse rispetto alle aree a basso reddito.

Nelle parole dello studio: "Qui dimostriamo che, se da un lato i modelli predittivi possono rafforzare il potere dello Stato attraverso la sorveglianza criminale, dall'altro consentono di sorvegliare lo Stato rintracciando le distorsioni sistemiche nell'applicazione del crimine".

Inoltre, il modello è stato addestrato utilizzando i dati di altre sette città statunitensi, mostrando risultati simili. Tutti i set di dati e gli algoritmi sono stati resi disponibili su GitHub.

Chicago è un importante caso di studio di polizia guidata dai dati e assistita dall'intelligenza artificiale. Un altro esempio è il progetto della città mappa termica del crimine con armi da fuocoche identifica i "punti caldi" della criminalità che possono essere utilizzati per le attività di polizia.

Un episodio degno di nota risale al 2013, agli albori della polizia predittiva. coinvolto Robert McDaniels, residente nel quartiere Austin di Chicago, dove si concentra il 90% dei crimini con armi da fuoco della città.

Nonostante la sua fedina penale non violenta, l'inclusione di McDaniel in un elenco di criminali potenzialmente violenti lo ha visto diventare per due volte bersaglio di violenza con armi da fuoco, in virtù del fatto che la polizia si è presentata alla sua porta e lo ha reso un bersaglio.

Un'indagine di The Verge afferma che un giornalista del Chicago Tribune ha contattato McDaniel in merito alla "lista di calore", un nome non ufficiale che la polizia ha assegnato agli algoritmi che etichettano potenziali tiratori e bersagli.

Ishanu Chattopadhyay, il ricercatore principale del progetto 2022 Chicago progetto di previsione del crimineha sottolineato che il loro modello predice i luoghi, non gli individui. "Non si tratta di Minority Report", ha detto, ma l'evento di McDaniels ha certamente un certo parallelismo.

Per rispondere ai dubbi di parzialità, Chattopadhyay ha osservato che sono state intenzionalmente omesse le infrazioni minori per droga e traffico segnalate dai cittadini, concentrandosi sui crimini violenti e di proprietà segnalati più frequentemente.

Tuttavia, sStudi dimostrano che le persone di colore sono più frequentemente denunciate per crimini rispetto alle loro controparti bianche. Di conseguenza, i quartieri neri sono ingiustamente etichettati come "ad alto rischio".

Inoltre, l'intensificazione dell'attività di polizia in un'area comporta un aumento dei reati denunciati, creando un circuito di feedback che distorce la percezione del crimine.

Inoltre, basarsi sui dati del passato può perpetuare gli stereotipi e trascurare il potenziale di cambiamento e riabilitazione.

Come si è comportata la polizia predittiva?

La polizia predittiva, come è ovvio, è molto controversa, ma funziona o soddisfa il suo scopo fondamentale?

Un'indagine dell'ottobre 2023 di Il Markup e Wired ha rivelato fallimenti clamorosi, aggiungendosi a un volume crescente di prove che evidenziano i pericoli e le carenze del trasferimento del processo decisionale delle forze dell'ordine alle macchine.

Il programma in questione è Geolitica, un software di polizia predittiva utilizzato dalla polizia di Plainfield, nel New Jersey. Vale la pena notare che il dipartimento di polizia di Plainfield è stato l'unico su 38 dipartimenti disposto a condividere i dati con i media.

Precedentemente conosciuto come PredPolQuesto software di apprendimento automatico è stato acquistato da diversi dipartimenti di polizia.

The Markup e Wired hanno analizzato 23.631 previsioni di Geolitica da febbraio a dicembre 2018. Di queste, meno di 100 previsioni corrispondevano a casi di crimini reali, con un tasso di successo inferiore allo 0,5%.

Questi modelli di previsione sono sempre stati controversi e hanno sollevato numerose questioni etiche riguardo al loro potenziale di rafforzare i pregiudizi discriminatori e razzisti prevalenti nell'IA e nelle forze dell'ordine.

Questa recente indagine sottolinea i dilemmi etici e mette in dubbio l'efficacia del software nel prevedere i crimini.

Sebbene il software abbia mostrato lievi variazioni nell'accuratezza della previsione tra i vari tipi di crimine (ad esempio, ha previsto correttamente lo 0,6% delle rapine o delle aggressioni aggravate rispetto allo 0,1% dei furti con scasso), il quadro generale rimane quello di una grave sottoperformance.

La candida risposta del capitano della polizia di Plainfield, David Guarino, fa luce sulla realtà dei fatti. "Perché abbiamo preso PredPol? Volevamo migliorare la nostra efficienza nella riduzione del crimine", ha commentato.

"Non sono sicuro che abbia raggiunto questo obiettivo. Lo abbiamo usato raramente, se non mai". Ha anche detto che il dipartimento di polizia ha smesso di usarlo.

Il capitano Guarino ha suggerito che i fondi stanziati per Geolitica - che ammontavano a una quota di abbonamento annuale di $20.500 più un ulteriore $15.500 per un secondo anno - avrebbero potuto essere investiti in modo più efficace in programmi incentrati sulla comunità.

Geolitica è destinata a chiudere le operazioni entro la fine dell'anno.

Prove che documentano la parzialità della polizia predittiva

La promessa di una polizia predittiva rimane allettante, in particolare quando le forze di polizia sono sempre più sotto pressione e la qualità del processo decisionale della polizia umana è messa in discussione.

Le forze di polizia degli Stati Uniti, del Regno Unito e di diversi Paesi europei, tra cui la Francia, sono sottoposte a controlli per pregiudizi nei confronti di gruppi minoritari.

I membri della Camera dei Lord e della Camera dei Comuni del Regno Unito chiedono con insistenza una arresto temporaneo sull'impiego della tecnologia di riconoscimento facciale da parte della polizia.

Questo è emerso dopo che il ministro della polizia Chris Philip ha discusso di concedere alle forze di polizia l'accesso a 45 milioni di immagini dal database dei passaporti per il riconoscimento facciale della polizia. Finora, 65 parlamentari e 31 organizzazioni per i diritti e l'uguaglianza razziale si sono opposti all'uso delle tecnologie di riconoscimento facciale nelle forze di polizia.

Il gruppo di difesa Guarda il Grande Fratello ha dichiarato che l'89% degli avvisi di riconoscimento facciale della polizia britannica fallisce il suo scopo, con risultati sproporzionatamente peggiori per i gruppi di minoranza etnica e le donne. Un esperimento di riconoscimento facciale condotto nel 2018 dalla polizia metropolitana di Londra ha avuto un esito negativo. tasso di successo solo di circa 2%.

Come dice Michael Birtwistle, dell'Ada Lovelace Institute, descrittoL'accuratezza e le basi scientifiche delle tecnologie di riconoscimento facciale sono molto contestate e la loro legalità è incerta".

Negli Stati Uniti, un progetto di collaborazione tra la Columbia University, l'AI Now Institute e altri ha recentemente analizzato le controversie giudiziarie statunitensi che coinvolgono gli algoritmi.

Lo studio ha rilevato che i sistemi di IA sono stati spesso implementati frettolosamente, senza un'adeguata supervisione, principalmente per ridurre i costi. Purtroppo, questi sistemi hanno spesso causato problemi costituzionali a causa di pregiudizi intrinseci.

Almeno quattro uomini di colore sono stati ingiustamente arrestati e/o imprigionati a causa di errate corrispondenze facciali negli USA, tra cui Parchi Nijeer, falsamente accusato di taccheggio e di reati stradali, nonostante si trovasse a 30 miglia di distanza dai presunti incidenti. Ha quindi trascorso dieci giorni in carcere e ha dovuto pagare migliaia di euro di spese legali.

Il Gli autori dello studio hanno conclusoQuesti sistemi di intelligenza artificiale sono stati implementati senza una formazione, un supporto o una supervisione significativi e senza alcuna protezione specifica per i destinatari. Ciò è dovuto in parte al fatto che sono stati adottati per produrre risparmi sui costi e standardizzazione nell'ambito di un modello monolitico di approvvigionamento tecnologico, che raramente prende in considerazione i problemi di responsabilità costituzionale".

La polizia predittiva può incoraggiare un processo decisionale innaturale

Anche quando la polizia predittiva è accurata, gli esseri umani devono agire in base alle previsioni, e qui le cose si complicano.

Quando un algoritmo dice alla polizia che deve trovarsi in un posto perché è in corso o è probabile che venga commesso un crimine, è tutt'altro che impossibile pensare che questo distorca il processo decisionale.

Ci sono alcune teorie psicologiche di base con cui sarebbe saggio confrontarsi quando si considera il ruolo dell'IA nella polizia.

In primo luogo, quando un algoritmo informa la polizia di una probabile scena del crimine, potenzialmente la induce a vedere la situazione attraverso una lente di aspettativa. Questo potrebbe aver giocato a favore dell'incidente di McDaniels: la polizia è arrivata sul posto aspettandosi un incidente, innescando un'escalation di eventi in un ambiente volatile.

Ciò è radicato nel bias di conferma, che suggerisce che una volta in possesso di un'informazione, tendiamo a cercare e interpretare le informazioni successive in modo da allinearci con quella convinzione iniziale.

Quando un algoritmo dice a qualcuno che è probabile che si verifichi un crimine, può dare inconsciamente più peso agli indizi che confermano questa previsione e trascurare quelli che la contraddicono.

Inoltre, gli algoritmi, soprattutto quelli utilizzati in veste ufficiale, possono essere considerati autorevoli per la loro natura computazionale e i funzionari potrebbero riporre in essi un'indebita fiducia.

E poi c'è il rischio di disimpegno morale. Gli agenti possono scaricare la responsabilità delle loro azioni sull'algoritmo, pensando che sia stato il software a fare la chiamata, e non loro, il che è molto rilevante anche nel campo della guerra.

I dibattiti in questo caso sono paralleli a quelli che riguardano L'uso dell'IA sul campo di battagliache pone alcuni dilemmi simili.

L'autorità imposta dell'IA può portare a un "gap di responsabilità" in cui nessuno si assume la responsabilità per gli errori commessi dall'IA, come evidenziato da Kate Crawford e Jason Schultz in un recente Articolo JSTOR.

In definitiva, in base alle prove attualmente disponibili, la polizia predittiva spesso perpetua i pregiudizi piuttosto che ridurli.

Quando le previsioni si combinano con il processo decisionale umano, gli impatti sono potenzialmente catastrofici.