Il fondatore e CEO di HyperWrite, Matt Shumer, ha annunciato che il suo nuovo modello, Reflection 70B, utilizza un semplice trucco per risolvere le allucinazioni LLM e fornisce risultati di benchmark impressionanti che battono modelli più grandi e persino chiusi come GPT-4o.

Shumer ha collaborato con il fornitore di dati sintetici Glaive per creare il nuovo modello, basato sul modello Llama 3.1-70B Instruct di Meta.

Nell'annuncio del lancio su Hugging Face, Shumer ha dichiarato che. "Reflection Llama-3.1 70B è (attualmente) il miglior LLM open-source del mondo, addestrato con una nuova tecnica chiamata Reflection-Tuning che insegna a un LLM a rilevare gli errori nel suo ragionamento e a correggere la rotta".

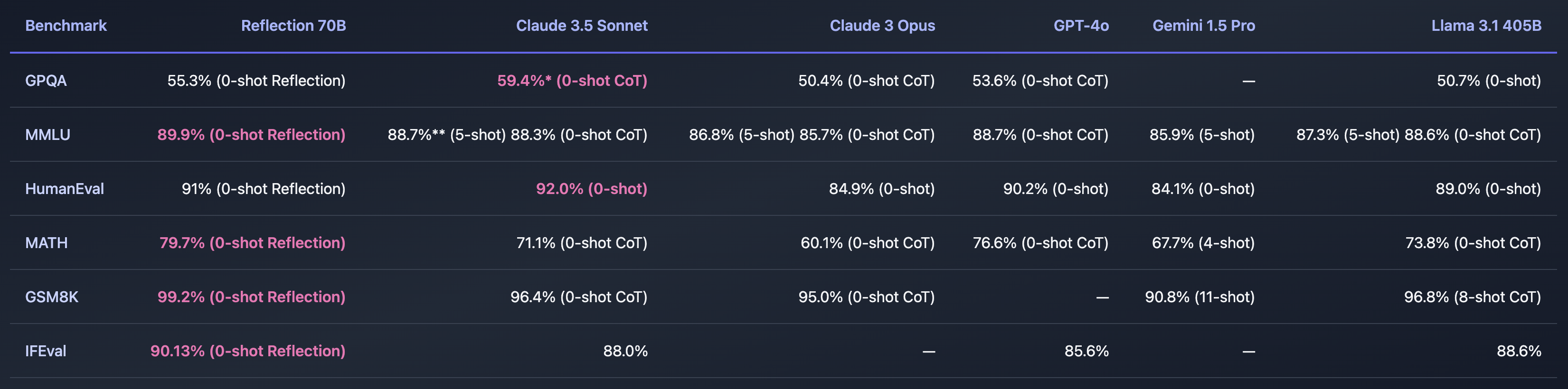

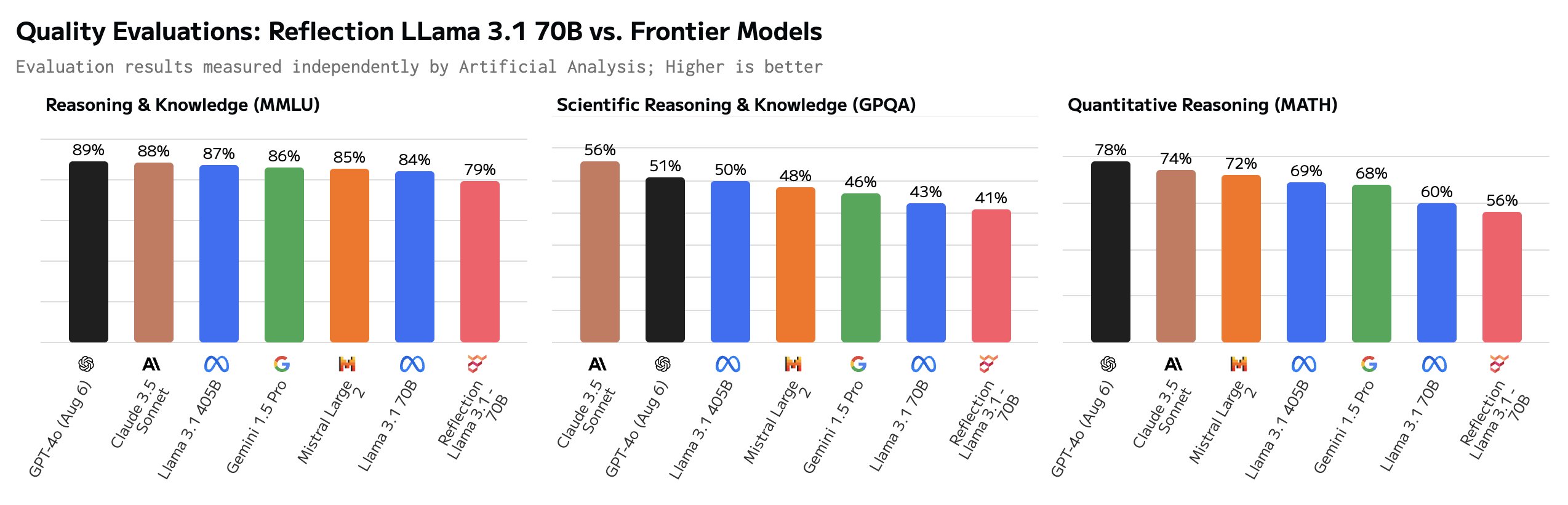

Se Shumer trovasse un modo per risolvere il problema delle allucinazioni dell'intelligenza artificiale, sarebbe incredibile. I benchmark che ha condiviso sembrano indicare che Reflection 70B è molto più avanti di altri modelli.

Il nome del modello fa riferimento alla sua capacità di autocorreggersi durante l'inferenza. Shumer non svela troppo, ma spiega che il modello riflette sulla sua risposta iniziale a un prompt e la fornisce solo quando è convinto che sia corretta.

Shumer afferma che la versione 405B di Reflection è in lavorazione e che, quando sarà presentata la prossima settimana, lascerà a bocca aperta gli altri modelli, compreso il GPT-4o.

Reflection 70B è una truffa?

È tutto troppo bello per essere vero? Reflection 70B è disponibile per il download su Huging Face, ma i primi tester non sono stati in grado di replicare le impressionanti prestazioni mostrate dai benchmark di Shumer.

Il Parco giochi di riflessione vi fa provare il modello, ma dice che a causa dell'elevata richiesta la demo è temporaneamente interrotta. I suggerimenti dei prompt "Conta le 'r' in fragola" e "9,11 vs 9,9" indicano che il modello è in grado di rispondere correttamente a queste richieste difficili. Ma alcuni utenti sostengono che Reflection è stato messo a punto appositamente per rispondere a queste richieste.

Alcuni utenti hanno messo in dubbio gli impressionanti benchmark. Il GSM8K di oltre 99% sembrava particolarmente sospetto.

Ciao Matt! È molto interessante, ma sono piuttosto sorpreso di vedere un punteggio GSM8k di oltre 99%. A mio avviso, è probabile che più di 1% di GSM8k siano etichettati in modo errato (la risposta corretta è in realtà sbagliata)!

- Hugh Zhang (@hughbzhang) 5 settembre 2024

Alcune delle risposte della verità di base nel dataset GSM8K sono in realtà sbagliate. In altre parole, l'unico modo per ottenere un punteggio superiore a 99% sul GSM8K era fornire le stesse risposte errate a quei problemi.

Dopo alcuni test, gli utenti affermano che Reflection è in realtà peggiore di Llama 3.1 e che in realtà era solo Llama 3 con la messa a punto di LoRA.

In risposta ai commenti negativi, Shumer ha pubblicato una spiegazione su X: "Aggiornamento rapido: abbiamo ricaricato i pesi ma c'è ancora un problema. Abbiamo appena ricominciato l'allenamento per eliminare ogni possibile problema. Dovrebbe essere pronto a breve".

Shumer ha spiegato che c'era un problema con l'API e che ci stavano lavorando. Nel frattempo, ha fornito l'accesso a un'API segreta e privata, in modo che i dubbiosi potessero provare Reflection mentre si lavorava alla correzione.

Ed è qui che le ruote sembrano staccarsi, dato che alcune domande attente sembrano mostrare che l'API è in realtà solo un involucro di Claude 3.5 Sonnet.

"Reflection API" è un wrapper di Sonnet 3.5 con prompt. E al momento lo stanno mascherando filtrando la stringa 'claude'.https://t.co/c4Oj8Y3Ol1 https://t.co/k0ECeo9a4i pic.twitter.com/jTm2Q85Q7b

- Giuseppe (@Giuseppe Reale) 8 settembre 2024

Secondo i test successivi, l'API avrebbe restituito i risultati di Llama e GPT-4o. Shumer ribadisce che i risultati originali sono accurati e che sta lavorando per correggere il modello scaricabile.

Gli scettici sono un po' prematuri nel definire Shumer un truffatore? Forse il rilascio è stato gestito male e Reflection 70B è davvero un modello open-source innovativo. O forse si tratta di un altro esempio di hype per l'IA per raccogliere capitali di rischio da parte di investitori alla ricerca della prossima grande novità nel campo dell'IA.

Dovremo aspettare un giorno o due per vedere come si evolverà la situazione.